Wykupienie dostępu pozwoli Ci czytać artykuły wysokiej jakości i wspierać niezależne dziennikarstwo w wymagających dla wydawców czasach. Rośnij z nami! Pełna oferta →

Biurowiec przylegający do dworca w Zurychu to miejsce, w którym maszyny mają nauczyć się myśleć. Ich nauczycielem ma być Emmanuel Mogenet. 50-letni Francuz pracował wcześniej dla Apple’a, zajmował się efektami specjalnymi, a teraz w europejskim centrum badawczym Google Research ma zmieniać fantastykę w rzeczywistość. Choć z fantastyką nie zawsze mu po drodze, co staje się oczywiste, kiedy próbuję zacząć rozmowę od pytania o film „Blade Runner 2049”.

– Nie widziałem go jeszcze – przyznaje. – Co tam jest?

– Rozumne hologramy, programy z uczuciami. To w takim kierunku idziemy?

– Wszystko jest możliwe przy wystarczająco odległej perspektywie – odpowiada Mogenet. – Ale dzisiaj sztuczna inteligencja budzi ogromne emocje. Czasami oparte na faktach, często na fantastyce.

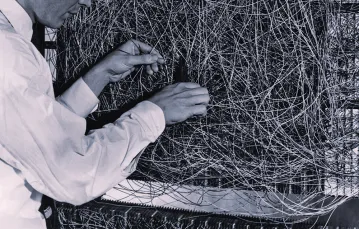

On sam zajmował się AI jeszcze we wczesnych latach 90., kiedy komputery były po prostu za słabe. Dopiero błyskawiczny wzrost mocy procesorów w XXI wieku otworzył drogę do poważnych badań.

– Od kiedy istnieją komputery, próbowaliśmy nauczyć je myśleć tak jak my. I ponosiliśmy klęski – mówi. – Był czas, kiedy naukowcy niemal całkiem zaniechali prac. Dopiero w ciągu ostatnich dziesięciu lat doszło do odrodzenia. Udało się nam stworzyć coś, co nazywamy nauczaniem nadzorowanym. I robić rzeczy, które wydawały się niemożliwe.

Jak rozpoznać kota

Cała stołówka Google Research jest zastawiona przykładami. Na rozstawionych tu komputerach pracują algorytmy wykorzystujące formy uczenia maszynowego, ale na całkowicie różne sposoby. Jeden jest akompaniatorem, odpowiadającym na grane na syntezatorze nuty swoimi nutami. Inny rozpoznaje obiekty rysowane w szkicowniku. Jeszcze inny analizuje zdjęcia dzieł sztuki i szuka motywów łączących, powiedzmy, autoportret van Gogha z chińską ceramiką. To zabawki – ale ilustrujące subtelne sposoby, w jakie sztuczna inteligencja już dziś działa za kulisami internetowych serwisów: od wyszukiwarek po programy do katalogowania fotografii. Oraz to, jak odlegli jesteśmy od czasów, gdy komputer był jedynie maszyną niewolniczo wykonującą linie programu.

– Musimy nauczyć komputery wykonywać zadania – tłumaczy Mogenet. – Do niedawna jedyny znany nam sposób nazywaliśmy programowaniem. Ono jest jak skomplikowany przepis z książki kucharskiej. Zrób to, potem tamto. Czasami sprawdza się doskonale. Ale czy potrafisz mi wytłumaczyć, jak chodzisz? Jak kolejno działają wszystkie mięśnie w twoim ciele? Robisz to bez zastanowienia, ale założę się, że zupełnie nie potrafisz wytłumaczyć, w jaki sposób.

– Nawet nie wiedziałbym, jak zacząć – przyznaję.

– Inny przykład – kontynuuje. – Jeśli dam ci zdjęcie i spytam, czy jest na nim kot, odpowiesz natychmiast. Każdy człowiek odpowie. Ale czy wytłumaczysz mi, skąd to wiesz? Wszędzie tam, gdzie możesz wytłumaczyć, jak rozwiązać problem, wystarczy programowanie. Ale jest wiele zadań, które są dla nas zupełnie naturalne, a których wytłumaczyć nie potrafimy. I przez to one były bardzo trudne dla komputerów.

W rozmowie o maszynowym nauczaniu rzadko używamy terminów takich jak „program”. Zamiast tego mówimy o „uczeniu”.

– Dziś umiemy uczyć komputer na przykładach. Zamiast tłumaczyć krok po kroku, pokazujemy, jak coś zrobić. Weźmy kota. Robimy mnóstwo zdjęć i na każdym dajemy adnotacje: na tym zdjęciu kot jest, na tamtym go nie ma. Tę bazę dajemy komputerowi do przejrzenia i krok po kroku budujemy system, który nauczy się rozpoznawać kota na zdjęciach tak jak człowiek. Nie pokazujemy metody osiągnięcia rozwiązania. Pokazujemy przykłady.

– Komputer sam musi znaleźć rozwiązanie?

– O to chodzi. To metoda kija i marchewki. Za nieprawidłową odpowiedź komputer odrobinę karzemy. Polega to na drobnej zmianie parametrów. Jeśli odpowie dobrze, nagradzamy. Po milionach powtórzeń komputer zaczyna rozumieć, jak rozpoznać kota. Nazywamy to głębokim uczeniem. Głębokim, bo naśladujemy naszą własną korę wzrokową. Rezultat to system, co do którego, tak jak w przypadku naszego mózgu, nie do końca wiemy, jak działa.

– Nie może nam wytłumaczyć, jak rozumuje?

– To aktualnie bardzo ważny temat badań: próba przeprowadzenia „sekcji” sieci neuronowej, żeby komputer wytłumaczył nam swój proces wnioskowania. Jesteśmy blisko rozwiązania, ale na razie faktycznie mamy systemy, które działają wspaniale, ale nie jesteśmy pewni jak. Bo uczą się same.

Nauka chwytania

Co prowadzi do intrygujących sytuacji. Jak ta sprzed roku, kiedy okazało się, że algorytmy serwisu Google Translate, żeby ułatwić sobie tłumaczenie z, powiedzmy, urdu na słowacki, stworzyły własny, nieznany ludzkości metajęzyk, pośredniczący w przekazywaniu znaczeń.

– Standardowo uczymy się języka, poznając gramatykę i słownictwo. Próbowaliśmy takiego podejścia w translatorze. Wyobraź sobie tłumaczenie z polskiego na japoński przez programowanie. Nie działa. Teraz robimy to poprzez przykłady. Miliardy przykładowych zdań. Prawdziwa magia tkwi w tzw. generalizacji. Kiedy uczysz system uczenia maszynowego, pokazując mu miliardy przykładów, on najpierw stara się po prostu zapamiętywać. Powie: „Już mi to pokazywałeś, więc znam odpowiedź”. Ale w którymś momencie zaczyna uogólniać. Pokazujesz mu coś nowego, a system mówi: „To trochę przypomina coś, co już kiedyś widziałem”. Będzie tłumaczyć zdania, których nigdy wcześniej nie widział. Bo jest w stanie dojść do prawidłowego tłumaczenia na przykładach.

Łatwo przypisywać tak działającym sieciom neuronowym ludzkie cechy, ale Mogenet przestrzega przed ich „uczłowieczaniem”. Są bardzo dobre w tym, co robią – ale do „Blade Runnera” droga daleka.

– Na czym polega różnica między systemem, który rozpoznaje na zdjęciu plamę i mówi: „Tak, to kot”, a systemem, który wie, co to jest kot?

– To dobre pytanie, bo pokazuje ograniczenia naszych modeli. Musimy zrozumieć, że dzisiejsze systemy AI są bardzo wąskie. Robią jedną rzecz doskonale, ale nie potrafią niczego innego. System, który rozpoznaje kota, nie zrobi niczego innego. Inny system zajmuje się tylko tłumaczeniami. My mamy wspólny model umysłowy świata. Mówię „kot”, a w twoim mózgu pojawiają się obrazy, które znasz z doświadczenia. Widziałeś koty, dotykałeś ich, wiesz, że są drapieżnikami... Długa jest lista rzeczy, które o nich wiesz. Ja dysponuję podobną. To właśnie semantyczny poziom zrozumienia, czym jest kot. Komputer powie ci: „to jest kot” albo „to nie jest kot”, bo to jedyne zadanie, które wykonuje. Ale nie rozpozna np. dziecięcego rysunku kółka z dwoma trójkątnymi uszami jako kota, nawet jeśli dla człowieka to oczywiste. Takie rozumowanie na wyższym poziomie nie jest dla komputerów dostępne z dwóch powodów. Po pierwsze, nie mają tego współdzielonego umysłowego modelu świata. My go zdobywamy przez całe życie. Po drugie, nie potrafią wnioskować. Przykład: wiem, że jesteś z Polski, wiem, że przyjechałeś do Zurychu, mogę wywnioskować, że w którymś momencie wsiądziesz do samolotu i wrócisz do Polski. Skąd to wiem?

– Z doświadczenia.

– Dokładnie. Mogę wyciągnąć wnioski, konstruować scenariusze i przewidywać przyszłość. AI nie ma o tym pojęcia. Nie ma zdrowego rozsądku i nie potrafi wyciągnąć wniosków.

– Czy to kwestia naszego podejścia? Mocy obliczeniowej?

– To kwestia danych. Widzisz osiem obrazów na sekundę przez powiedzmy dziesięć godzin dziennie. Od urodzenia. To mnóstwo danych. Do tego otrzymujesz skompresowane informacje przetworzone dla ciebie przez innych ludzi. To jedna z rzeczy, których tutaj próbujemy: chcemy nauczyć komputery zdrowego rozsądku dzięki analizie obrazów. Muszą się uczyć o świecie w taki sam sposób jak my. A my nie tylko patrzymy. Czasami wsadzamy palce do kontaktu, żeby zobaczyć, co się stanie. Komputery też muszą, jeśli mają zdobyć zdrowy rozsądek.

– Powinniśmy stworzyć maszynę, która potrafi się bawić? – pytam.

– Mamy laboratorium, w którym próbujemy rozwiązać jeden jedyny problem: jak złapać obiekt. Moje roczne dziecko właśnie tego próbuje. Przyglądam mu się i widzę, że to tak trudne, aż boli. Zajmie mu to dwa lata, a i tak nie będzie w tym doskonałe. Tego samego próbujemy nauczyć roboty. Mamy coś, co nazywamy „farmą rąk”. To pokój pełen mechanicznych ramion, które przez cały dzień próbują łapać piłki. Pudłują, pudłują, pudłują, aż raz na jakiś czas któremuś się udaje i zapamiętuje, jak to zrobił. Po długim czasie maszyna z grubsza rozumie, jak złapać przedmiot, ale to bardzo trudny problem. Nie doceniamy tego, jak skomplikowany jest świat. Jesteśmy bardzo złożonymi maszynami, które są produktem milionów lat ewolucji.

Egzoszkielet dla umysłu

Roy Amara, zmarły w 2007 r. amerykański naukowiec i futurysta, stwierdził, że „zwykle przeceniamy wpływ, jaki nowa technologia będzie miała w krótkim terminie, ale nie doceniamy jej wpływu w dłuższej perspektywie”. W przypadku AI mieliśmy już do czynienia z kilkoma cyklami fascynacja-zachwyt-rozczarowanie. Ze słów Mogeneta wynika, że czeka nas wiele kolejnych.

– Dysponujemy podstawowymi klockami. Udaje nam się naśladować pewne cechy naszej inteligencji. Budujemy bardzo wąskie, choć czasami bardzo głębokie systemy, które w konkretnych kwestiach są już od nas lepsze, np. jeśli idzie o grę w szachy czy w go. Ale pomyśl, jak uniwersalni jesteśmy. Umiemy chodzić, mówić, śpiewać, tworzyć. Co ważniejsze, umiemy przenosić umiejętności, które zdobyliśmy w jednym miejscu, na inną dziedzinę. Kiedy nauczysz się jeździć na rowerze, łatwiej ci się potem będzie nauczyć prowadzenia auta. Maszyny nie umieją stosować umiejętności w nowym kontekście. Gdzie będziemy za 5-15 lat? Nawet nie wiem, gdzie zacząć spekulacje. Ale droga do inteligencji dorównującej ludzkiej jest bardzo, bardzo długa. Jesteśmy pewnie 50-100 lat od celu. Jeśli ktoś mówi ci coś innego, blefuje.

– Po co właściwie je tworzymy?

– Na pewno nie po to, żeby nas zastąpiły. Sztuczne inteligencje będą rozszerzeniem nas, narzędziami, które zwielokrotnią moc naszego umysłu. Egzoszkieletem dla niego – odpowiada Mogenet. – Dzięki wsparciu technologii będziemy lepszymi ludźmi.©

Autor jest dziennikarzem Polsat News, gdzie prowadzi autorski program popularnonaukowy „Horyzont zdarzeń”. Stale współpracuje z „Tygodnikiem”.

„CHIŃSKI POKÓJ”

to słynny eksperyment myślowy zaproponowany w 1980 r. przez Johna Searle’a. W zamkniętym pokoju siedzi osoba nieznająca języka chińskiego. Dostaje ona kartkę z ciągiem chińskich symboli. W pokoju znajdują się podręczniki zawierające zestaw reguł, które wyjaśniają, jakie symbole należy zapisać w odpowiedzi na otrzymane symbole. Korzystając z podręczników, osoba z pokoju odpowiada na otrzymany tekst. Z perspektywy kogoś, kto jest na zewnątrz, może się wydawać, że człowiek w pokoju zrozumiał chiński tekst, podczas gdy w rzeczywistości „jedynie” stosował się do ciągu reguł przekształcania jednych symboli w inne.

Tzw. argument chińskiego pokoju miał uzasadnić, że semantyki (rozumienia) nie da się sprowadzić do syntaktyki, dlatego przetwarzające symbole maszyny będą tylko symulować rozumienie. Argument ten do dziś jest dyskutowany w filozofii. ©