Wykupienie dostępu pozwoli Ci czytać artykuły wysokiej jakości i wspierać niezależne dziennikarstwo w wymagających dla wydawców czasach. Rośnij z nami! Pełna oferta →

Prawie każde nasze działanie zostawia dziś jakiś cyfrowy ślad. Aplikacje mobilne, takie jak Uber czy Google Maps, znają nasze położenie, wyszukiwarka Google wie, co nas interesuje, a media społecznościowe znają nasze poglądy polityczne. Ktoś te dane zbiera, analizuje i wykorzystuje, większość z nas nie widzi zaś w tym nic groźnego (albo uznaje, że zalety tych aplikacji i tak przeważają nad ich wadami).

Jednak w ostatnich latach systemy sztucznej inteligencji zaczęły być wykorzystywane w dziedzinach, które mają bezpośredni i ważki wpływ na nasze życie. Coraz częściej algorytmy podejmują decyzje o zatrudnieniu, przyznaniu pożyczki bankowej, a nawet wspomagają sędziów w wydawaniu wyroków. Ma to oczywiście swoje zalety. Decyzje ludzkie obarczone są zawsze pewną dozą arbitralności: podanie o pracę od najbardziej nawet wykwalifikowanego kandydata może być odrzucone przez potencjalnego szefa tylko dlatego, że ten źle spał poprzedniej nocy. Patrzymy z nadzieją na automatyzację takich decyzji, bo algorytmy – w przeciwieństwie do ludzi – orzekają spójnie i bezstronnie.

Mimo to czujemy się nieswojo, kiedy algorytmy zastępują ludzi, zwłaszcza że wiele z nich to tzw. czarne skrzynki – ich mechanizm działania jest przed nami ukryty.

Prawo do wyjaśnienia

Pojawiają się wręcz teorie spiskowe. Frank Pasquale w wydanej w zeszłym roku głośnej książce pod znamiennym tytułem „The Black Box Society” pisze, że wielki biznes i agencje rządowe ukrywają w ten sposób swoje machinacje. Niezależnie od wiarygodności tego rodzaju oskarżeń pytanie o to, w jaki sposób algorytm podejmuje decyzje, jest uzasadnione. Chcemy wyjaśnienia jego działania. W sukurs użytkownikom przyszli ostatnio prawnicy, argumentując, że skoro obywatel ma prawo podważać wyroki ferowane przez automatyczne systemy (rzeczywiście ma), musi mieć też wgląd w mechanizm ich działania. W 2018 r. przywilej ten został wręcz usankcjonowany w unijnym rozporządzeniu o ochronie danych osobowych (słynnym RODO) pod nazwą „prawa do wyjaśnienia”.

Ale co dokładnie miałoby być wyjaśniane? Wbrew pozorom nie chodzi wcale o algorytm zbudowany przez informatyka. Budowa i działanie automatycznego systemu podejmowania decyzji przebiega bowiem w dwóch fazach. W fazie pierwszej stworzony przez informatyków algorytm do klasyfikacji danych samodzielnie uczy się na podstawie dostarczonych mu danych (np. mówiących o tym, że dana ilustracja przedstawia słonia, a inna żyrafę; albo że w jednym konkretnym przypadku przyznano pożyczkę, w innym konkretnym – nie przyznano) i buduje model działania. I to właśnie ten model, a nie algorytm użyty do jego budowy, jest istotą systemu automatycznego podejmowania decyzji. Albowiem w fazie drugiej użytkownik systemu, np. klient banku starający się o pożyczkę, wprowadza do niego swoje dane (wiek, wysokość wynagrodzenia itd.), a system na podstawie już skonstruowanego modelu – a nie pierwotnego algorytmu – podejmuje decyzję o wielkości pożyczki. A zatem to nie algorytm – którego struktura jest od początku klarowna i ustalona przez programistów – lecz model, którego struktura wyłania się dopiero w toku uczenia się, wymaga wyjaśnienia.

Tyle tylko, że projektant systemu ma bardzo niewielki wpływ na to, jak taki model działa (w końcu to algorytm samodzielnie go konstruuje) i nie interesuje go to dopóty, dopóki decyzje podejmowane na jego podstawie są „poprawne” (np. człowiek mając identyczne dane zdecydowałby tak samo). Dla projektanta ten model to po prostu czarna skrzynka, do której my nagle chcemy zajrzeć i wyjaśnić jej działanie. Otóż nie warto. Jest to niemożliwe, nieuzasadnione i nieskuteczne.

Gdzie jest struś

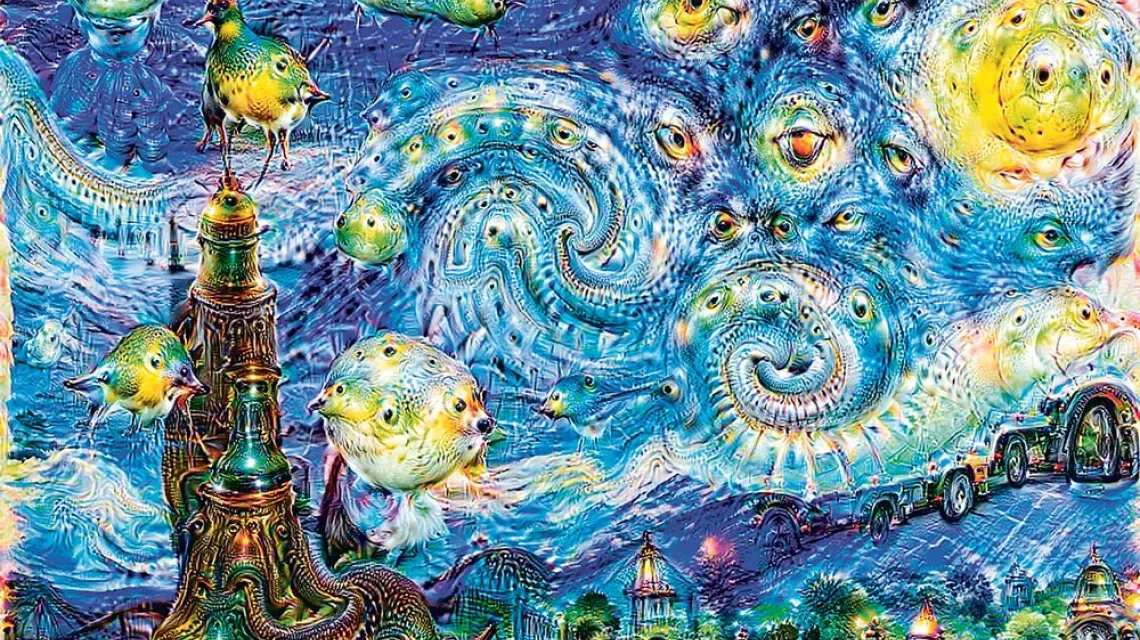

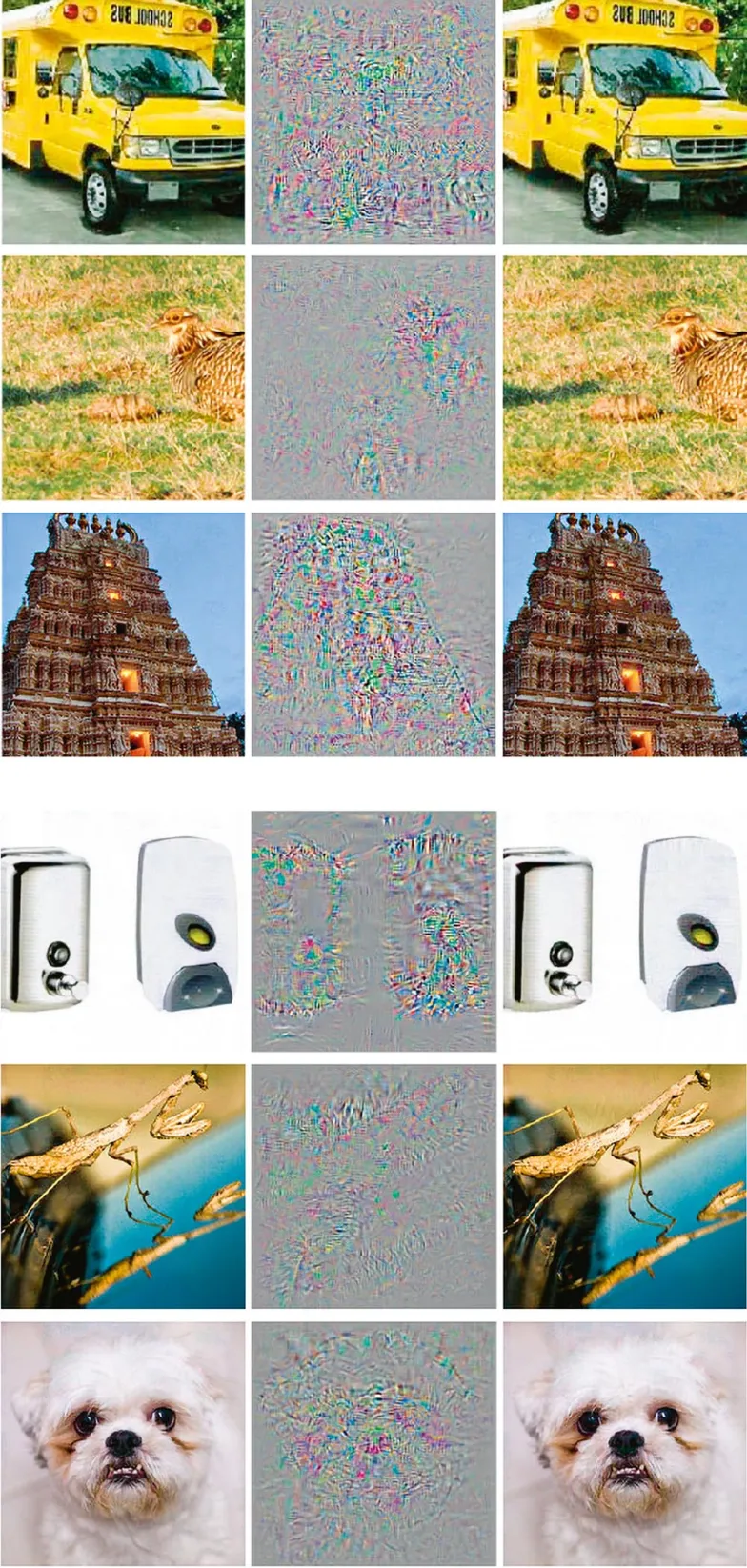

Znakomita większość algorytmów klasyfikacyjnych, o których tu mowa, działa na bazie sieci neuronowych lub drzew decyzyjnych. Nie da się, nawet w skrócie, opisać bez technicznego żargonu sposobu działania sieci neuronowych. Posłużę się więc dwoma przykładami, by pokazać, że modele budowane przy ich użyciu są zupełnie niezrozumiałe dla człowieka. AlexNet to system oparty na sieciach neuronowych, który kilka lat temu odnosił ogromne sukcesy w dziedzinie rozpoznawania obrazów. Ale okazało się, że jest niezwykle łatwo wprowadzić ten system w błąd. Spójrzmy na poniższe pary obrazków.

Fotografie po lewej stronie są poprawnie rozpoznawane przez AlexNet jako autobus, świątynia, pies itp. Wszystkie te fotografie poddane zostały obróbce przez zmianę niektórych pikseli (pokazanych na środkowych zdjęciach). Fotografie po prawej stronie to wynik tych zmian. Dla ludzkiego oka fotografie z każdej pary wyglądają identycznie, dla AlexNet wszystkie zdjęcia po prawej stronie przedstawiają… strusie.

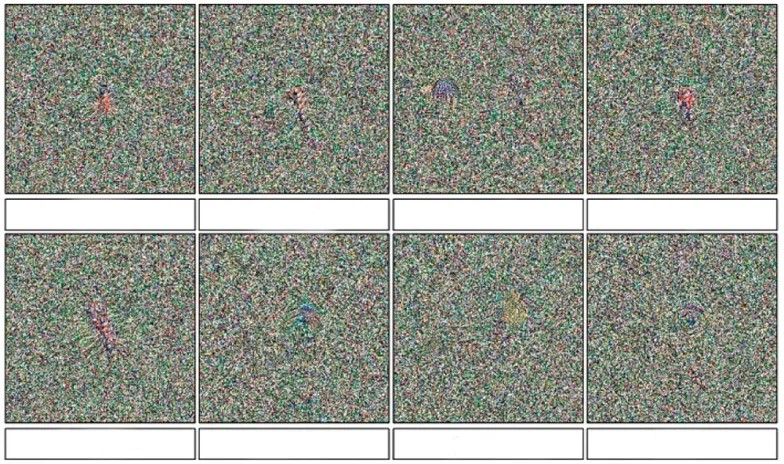

Oto drugi przykład przedstawiający – no właśnie, co?

Dla nas wszystkie te obrazki są losowo rozrzuconymi pikselami. Tymczasem AlexNet z 99-procentową pewnością rozpoznaje na nich konkretne organizmy (drozd, gepard, pancernik, stonoga, paw, owoc chlebowca). Spróbujmy zatem wyjaśnić, dlaczego AlexNet widzi strusia tam, gdzie my widzimy autobus, albo pawia tam, gdzie my nic nie widzimy. I pamiętajmy, że oczekujemy odpowiedzi zrozumiałej dla przeciętnego człowieka, bez wspominania pikseli, struktur danych czy algorytmów. Oczywiście jest to zupełnie nierealne. Znamienna jest tu wypowiedź guru w dziedzinie sieci neuronowych, Alego Rahimiego, na konferencji Neural Information Processing Systems (NIPS) sprzed trzech lat: „Uczenie maszynowe stało się alchemią (...) wielu projektantów sieci neuronowych używa technologii, której tak naprawdę nie rozumie”. Jeśli projektanci tych systemów nie rozumieją, jak one działają, to dlaczego oczekiwać tego od laików?

Muzyka dla ciebie

Drzewa decyzyjne mają nieco bardziej zrozumiałą strukturę niż sieci neuronowe, ale budowane na ich podstawie modele również są bardzo skomplikowane. Z grubsza biorąc, drzewa decyzyjne reprezentują zestawy warunków, których spełnienie prowadzi do odpowiedniej klasyfikacji. I tak np. zestaw warunków: wiek poniżej 50 lat, dochód ponad 5 tys. zł miesięcznie, zadłużenie poniżej 10 tys., klasyfikuje pozytywnie do przyznania pożyczki. Wydawać by się mogło, że przynajmniej w tym przypadku możemy podać proste wyjaśnienie decyzji algorytmu przez zwykłe wyliczenie powyższych warunków. Rzecz w tym, że w praktyce drzewa decyzyjne są dużo bardziej skomplikowane.

Oto przykład z mojego podwórka. Dwa lata temu jeden z moich doktorantów zaprojektował dobrze sprawdzający się system rekomendacji piosenek dla jednego z największych azjatyckich serwisów muzycznych. Wygenerowany model zawierał miliardy zestawów warunków. Co gorsza, 90 proc. z tych warunków nie odnosiło się do żadnych cech piosenek czy słuchaczy, bo zostało wygenerowane maszynowo bez żadnej intuicyjnej interpretacji. Żeby wyjaśnić, dlaczego system rekomenduje jakąś piosenkę, należałoby zatem wyliczyć dziesiątki zestawów warunków, z których większość nie miałaby dla nas żadnego sensu. Jaka byłaby wartość takiego wyjaśnienia?

Nawet gdyby wyjaśnienia podane prostym językiem były w jakiś sposób osiągalne, to mogłyby one wyrządzić więcej szkody niż pożytku. Dlaczego? Otóż algorytmy są ślepe na poprawność polityczną i mimo braku dostępu do danych na temat płci czy rasy, bezwzględnie powielają stereotypy. Wyobraźmy sobie, że kobieta i mężczyzna składają identyczne podania o pożyczkę bankową i dostają odpowiednio negatywną i pozytywną decyzję. Jako wyjaśnienie kobieta otrzymuje następującą odpowiedź: „Twoje imię kończy się na »a«, a z moich danych wynika, że takie osoby często biorą zwolnienia i urlopy wychowawcze, nie awansują i w rezultacie ich pensja po 10 latach jest dużo niższa niż osób o innych końcówkach imion”. Nietrudno sobie wyobrazić konsekwencje prawne dla firmy udzielającej tego rodzaju „wyjaśnień”.

Czytaj także: Cyfrowe diagnozy - rozmowa z prof. Aleksandrą Przegalińską

Pociągnijmy dalej ten przykład. Przyjmijmy, że kobieta poinformowała też w podaniu, że ma 50 lat i rodzinę. Po decyzji odmownej chciałaby dostać nie tyle wyjaśnienie, ile sugestię, co powinna zmienić w swojej sytuacji, żeby się do pożyczki kwalifikować. W tym celu algorytm powinien znaleźć taki profil wnioskodawcy, który w minimalny sposób różniłby się od profilu naszej bohaterki, ale zapewniałby pozytywną decyzję w sprawie pożyczki. Oczywiście algorytm zaproponuje, aby nasza wnioskodawczyni zmieniła imię, a może nawet pozbyła się rodziny albo obniżyła swój wiek. Nie jest to bynajmniej wydumany przykład: jeśli chcemy, by algorytmy brały pod uwagę psychologiczny i społeczny kontekst w swoich wyjaśnieniach, to musimy ich tego kontekstu nauczyć. Badacze sztucznej inteligencji próbują to robić od kilkudziesięciu lat. Jak dotąd bezowocnie.

Oczywiście algorytmy nie są seksistowskie same z siebie – w końcu to my dostarczamy im danych treningowych. One po prostu powielają nasze własne uprzedzenia.

Poznawcza niekonsekwencja

Zastanówmy się, dlaczego tak bardzo zależy nam, by zrozumieć decyzje podejmowane przez automatyczne systemy. Przytacza się zazwyczaj trzy powody. Po pierwsze, do niedawna decyzje takie podejmowane były przez człowieka, który zawsze mógł je uzasadnić – chcielibyśmy, aby nadal tak było. Po drugie, w wielu przypadkach są to decyzje nietrywialne, wpływające na nasze życie (przyjęcie do pracy, wyrok sądowy etc.) i nie możemy ich przyjmować „na wiarę”. Po trzecie wreszcie, dlaczego mielibyśmy tak bardzo ufać maszynom?

Żaden z tych argumentów nie wytrzymuje krytyki, ponieważ pokazują one naszą niekonsekwencję w podejściu do różnych technologii. Wyobraźmy sobie, że wykryto u mnie nowotwór i lekarz proponuje chemioterapię jako najlepszą według niego metodę leczenia. Żądam od niego wyjaśnień. Lekarz podaje alternatywne terapie, ale powołując się na – nieznane mi – badania, upiera się przy chemioterapii. Jeśli mam lepszą niż przeciętna wiedzę medyczną, mogę jeszcze przez chwilę negocjować z lekarzem, ale przyjdzie taki moment, że się poddam, nie uzyskawszy w rzeczywistości żadnego wyjaśnienia. Co więcej, decyzja lekarza to nie jest decyzja tylko człowieka, ale także wynik testów diagnostycznych (badania farmakologiczne, prześwietlenia itp.) opartych na technologii dla większości z nas niezrozumiałej. Dlaczego zatem nie żądamy za każdym razem, by wyjaśniono nam działanie tej technologii? Wydaje się, że istnieje dość proste wyjaśnienie tego fenomenu: przyzwyczajenie i wynikające z niego przekonanie, że skoro to działa, to nie ma sensu żądać za każdym razem wyjaśnień. Spodziewam się, że wkrótce będzie tak z automatycznymi systemami podejmowania decyzji, które przecież w większości sytuacji już teraz świetnie działają.

Co nam więc pozostaje? To samo, co robimy wobec innych technologii: ufamy procedurom i ekspertom na tyle, że nie musimy wertować podręcznika aerodynamiki przed wejściem do samolotu. Możemy wiarygodnie i bez trudu oceniać algorytmy ze względu na ich poprawność i bezstronność z zewnątrz, bez konieczności zaglądania do środka. Mamy również usankcjonowaną prawnie możliwość odwoływania się od decyzji algorytmu – do rozprawy sądowej włącznie.

Myślę, że jest tylko kwestią czasu, byśmy traktowali algorytmy tak samo, jak dziś traktujemy wszystkie inne niezrozumiałe dla nas współczesne technologie. ©