Wykupienie dostępu pozwoli Ci czytać artykuły wysokiej jakości i wspierać niezależne dziennikarstwo w wymagających dla wydawców czasach. Rośnij z nami! Pełna oferta →

14 listopada ubiegłego roku Pew Research Center opublikował raport na temat zaufania do nauki w społeczeństwie amerykańskim. Tylko 57 proc. populacji uważa, że nauka ma w większości pozytywny wpływ na społeczeństwo, a sam trend jest bardzo niepokojący – bo to spadek aż o 16 punktów procentowych od 2019 r. Podobnie spadło wśród Amerykanów przekonanie (z 87 proc. do 73 proc.), że sami naukowcy działają w interesie społecznym. W efekcie aż jedna piąta Amerykanów twierdzi, iż nie warto w naukę inwestować. W wielu innych krajach da się zauważyć podobny trend.

Są niestety powody, dla których zaufanie do nauki spada. Z pozoru nauka rozwija się szybciej niż kiedykolwiek: odkryliśmy bozon Higgsa, opracowaliśmy rewolucyjną metodę edycji genomu ludzkiego CRISPR-Cas, zbudowaliśmy niewiele ustępujący człowiekowi system sztucznej inteligencji. Ale wielu naukowców, może nawet większość z nich, nie zajmuje się nauką jako taką, tylko tym, czego wymagają zatrudniające ich instytucje, a więc publikowaniem: byle czego, byle jak, byle szybciej. Ich zachowanie jest racjonalne, bo istniejący od ponad dwustu lat system organizacji nauki w pełni to sankcjonuje. I to ten właśnie system wymaga zmiany.

Uniwersytet na eksport

Dziś wydaje nam się oczywiste, że właściwym miejscem dla uprawiania nauki jest uniwersytet. Ale nie zawsze tak było. XVIII-wieczne uniwersytety amerykańskie służyły młodym dżentelmenom głównie do nawiązywania kontaktów towarzyskich, a uczelnie niemieckie kształciły nauczycieli szkół średnich. Naukowcy i filozofowie przeprowadzali eksperymenty i pisali swe traktaty poza uczelniami. Ramy instytucjonalne dla pracy badawczej próbowano stworzyć, organizując tzw. akademie. Kiedy w 1666 r. Ludwik XIV zakładał Francuską Akademię Nauk, to właśnie po to, by inspirować i otaczać opieką pracujących tam naukowców. Zmiana nastąpiła za sprawą Wilhelma von Humboldta, który na zlecenie króla rozpoczął w 1809 r. reformę pruskiego systemu edukacji.

Jednym z elementów tej reformy było założenie uniwersytetu w Berlinie działającego na nowych zasadach. Humboldt był człowiekiem wyrafinowanym i postępowym, dla którego prawdziwym celem życia było „kultywowanie w pełnym zakresie talentów, którymi jest się obdarzonym”. To przekonanie stało się dewizą projektowanego systemu edukacji, gdzie dążenie do doskonałości w nauce było celem nadrzędnym. Z drugiej strony pokonany przez Napoleona król Fryderyk Wilhelm III zapowiadał, że „państwo musi zastąpić straty materialne potęgą intelektualną”. Tak oto nauka, i to ta uprawiana przez najlepszych, znalazła swoje miejsce na finansowanym przez państwo uniwersytecie.

Nie jest oczywiste, że niemiecki model uniwersytetu przyjąłby się tak powszechnie na świecie, gdyby nie Amerykanie. Do końca XIX w. prawie dziesięć tysięcy młodych ludzi z USA wyjechało na studia do Niemiec. Tamtejsze uniwersytety zrobiły na nich takie wrażenie, że chcieli ich system przeszczepić na grunt amerykański. Udało im się to znakomicie, głównie dlatego, że w samym tylko Lipsku i Getyndze studiowało 45 przyszłych rektorów amerykańskich uczelni. Kiedy w 1875 r. Daniel Coit Gilman został rektorem pierwszego badawczego uniwersytetu w USA, Johns Hopkins University, nazywano tę uczelnię Getyngą w Baltimore. W ciągu kolejnych kilkudziesięciu lat amerykańskie uniwersytety doprowadziły niemiecki model do perfekcji, a za nimi zaadoptowała go reszta świata.

Zły chirurg

Aż do połowy XX wieku liczba studentów, a tym samym i pracowników naukowych, była niewielka i stanowili oni absolutną elitę intelektualną. Sytuacja zmieniła się diametralnie wraz z umasowieniem wyższych studiów po drugiej wojnie światowej. Nie można już było polegać na autorytecie zatrudnianych profesorów czy nieformalnych opiniach na ich temat. Wraz z gwałtownym wzrostem liczby pracowników naukowych pojawiła się potrzeba formalnej oceny ich pracy naukowej, a od tego zależał potem przydział środków na badania, awanse czy wręcz wynagrodzenie. Już w początkach XX w. postulowano, że liczba cytowań, jakie pismo naukowe dostaje od innych tytułów, świadczy o randze tego pisma i powinno być wskazówką dla bibliotekarzy, aby dodali je do zbiorów uniwersyteckich. Idea ta zaczęła z czasem (między 1975 a 1990 rokiem) być stosowana także do oceny wartości dorobku naukowego poszczególnych naukowców.

Rozśpiewane małpy. Jaką funkcję pełnią pieśni u gibonów?

System ten funkcjonowałby dobrze, gdyby humboldtowski ideał doskonałości w nauce nadal leżał na sercu naukowcom. Ale tak nie jest. Dla wielu z nich celem stały się publikacje, a nie nauka sama w sobie. A w takim systemie zaczyna stosować się prawo Goodharta: gdy dowolny wskaźnik zaczyna być traktowany jako cel, przestaje być dobrym wskaźnikiem. Patologie, do jakich prowadzi pęd za publikacjami, są już w nauce wszechobecne, a skutki społeczne często zatrważające. Literatura naukowa pełna jest dziś niewiarygodnych, nierzetelnych i trudnych do zweryfikowania opracowań, które przynoszą więcej szkody niż pożytku. Oto dwa spektakularne przykłady z ostatnich dekad.

W 2008 r. włoski chirurg Paolo Macchiarini opublikował w prestiżowym piśmie „The Lancet” artykuł opisujący nowatorską metodę przeszczepu tchawicy. Nowa technika była na tyle rewolucyjna, że przyniosła Włochowi natychmiastową sławę, a w dwa lata później etat w renomowanym Karolinska Institute w Szwecji. W 2011 r. Macchiarini przeprowadził pierwszy zabieg transplantacji, co Karolinska Hospital ogłosił jako „pierwszy w historii przeszczep syntetycznej tchawicy”.

W tym samym roku chirurg przeprowadził kolejną operację, a w następnym jeszcze trzy, z czego dwie w Rosji. Każdej takiej operacji towarzyszył nowy artykuł w prestiżowym piśmie przedstawiający ją jako fenomenalny sukces. Pierwszy pacjent zmarł po trzech latach, ale jeszcze przed publikacją artykułu opisującego tę operację jako pełny sukces. Drugi pacjent zmarł już po trzech miesiącach. Trzeci dożył do 2017 r. po kilku dodatkowych operacjach. Jedna z rosyjskich pacjentek, Julia Tuulik, przeszła takich operacji aż trzydzieści i zmarła dwa lata po przeszczepie. Lekarze zajmujący się pacjentami po operacjach wiedzieli, że stan ich zdrowia nijak się nie miał do tego, co opisywał Macchiarini w swoich publikacjach. Kiedy zaalarmowali administrację Karolinska Institute, trafili jednak na opór i próby zastraszania: lepiej było tolerować szarlatana niż przyznać się do błędu. Dopiero niezależne śledztwo przeprowadzone w 2016 r. doprowadziło do zdymisjonowania Macchiariniego i wszystkich odpowiedzialnych za przymykanie oczu na jego matactwa. Widzowie Netfliksa mogli zapoznać się z tą historią w dokumencie „Zły chirurg” z ubiegłego roku.

Jeszcze gorszy lekarz

Drugi wart przywołania przykład to dobrze znany skandal z 1998 r. Andrew Wakefield, lekarz jednego z londyńskich szpitali, na podstawie obserwacji dwanaściorga dzieci postawił hipotezę, że szczepionka MMR (jednoczesne szczepienie na świnkę, odrę i różyczkę) wywołuje u dzieci autyzm. Wakefield opublikował swoje „odkrycie” na łamach „The Lancet” i rozpoczął trwający kilka lat cyrk medialny, w którym sam autor aktywnie uczestniczył. Inne badania nie potwierdziły tez Wakefielda, a analiza danych klinicznych, na które się powoływał, wykazała, że były one przez niego fałszowane. Autorowi udowodniono także konflikt interesów. Jednak jego rewelacje spowodowały panikę wśród rodziców, która doprowadziła do znacznego spadku zaszczepień (w samym tylko UK spadł on z 95 proc. do 80 proc. populacji). Według WHO w 2018 r. z powodu świnki zmarło na świecie 140 000 osób. Część tych zgonów to niewątpliwie zasługa Wakefielda.

Roślina, która świeci: ruszyła sprzedaż bioluminescencyjnej petunii

Można dyskutować, jaką winę w przypadku oszustw naukowych ponoszą redakcje czasopism publikujące wadliwe artykuły – nie zawsze fałszerstwa da się od razu wykryć. Artykuły Wikefielda i Macchiariniego po latach zostały formalnie wycofane z „The Lancet”, choć byłoby oczywiście lepiej, gdyby się tam nigdy nie ukazały. Istotne jest jednak to, że obecny system funkcjonowania nauki sprzyja powstawaniu takich patologii, bo wszystkim jego uczestnikom – tak naukowcom, jak i redakcjom i wydawcom czasopism – zależy na publikowaniu kontrowersyjnych, nieoczekiwanych czy prowokacyjnych wyników. Bo to one mają szanse się wyróżnić. A to właśnie takie przełomowe i kontrowersyjne wyniki najczęściej nie znajdują potwierdzenia w kolejnych badaniach.

Gdyby Macchiarini przysłał do „The Lancet” tekst pokazujący bezcelowość przeszczepów syntetycznej tchawicy, redakcja na pewno odrzuciłaby ten tekst bez recenzji. Tymczasem taki negatywny wynik ma ogromną wartość nie tylko naukową, ale i społeczną, bo pokazuje, że nie warto poświęcać środków (w medycynie potencjalnie bardzo znacznych) na prowadzenie badań w tej dziedzinie.

Kilka lat temu grupa naukowców francuskich postanowiła sprawdzić, jakie odkrycia medyczne przebijają się do mediów. Interesowały ich w szczególności te publikacje, których wnioski zakwestionowane zostały potem w kolejnych badaniach. Policzono, że o odkryciach napisano w analizowanym okresie 234 artykuły prasowe, ale o zakwestionowaniu któregokolwiek z nich wspomniano tylko cztery razy! Trudno się dziwić, że wielu ludzi, których swego czasu przekonał Wakefield, nadal nic nie wie o finale tej całej sprawy. Jak zgrabnie ujął to Jonathan Swift, „prawda kuśtyka za pędzącym fałszem”.

Pomyłki i spółdzielnie

Trudno ocenić, jak powszechne są oszustwa w nauce. Kiedy wprost zapytano o to naukowców, do matactw przyznało się niecałe 2 proc. z nich, ale już ponad 14 proc. twierdziło, że robią to ich koledzy. Są to dane deprymujące, bo bałamutne wyniki w nauce pojawiają się przecież nie tylko w wyniku złej woli, ale także niekompetencji, niedbalstwa czy zwykłych błędów; można się spodziewać, że takich jest dużo więcej niż ordynarnych fałszerstw. Od kilku lat mamy już do dyspozycji algorytmy, które automatycznie skanują artykuły naukowe i wychwytują błędy w zamieszczonych tam danych statystycznych i rachunkowych (niestety tylko takie błędy). Prawie połowa tekstów zbadanych w ten sposób zawierała co najmniej jedną nieścisłość tego rodzaju. Zapewne większość z nich to błędy niewinne, ale tam, gdzie błędy są poważne, takie też mogą być ich konsekwencje społeczne.

W 2010 r. dwójka harvardzkich ekonomistów Kenneth Rogoff i Carmen Reinhart opublikowała historyczne studium, z którego wynikało, że dochód narodowy kraju zaczyna spadać, kiedy jego dług publiczny przekroczy 90 proc. PKB. Prestiż autorów i sugestywność argumentów sprawiły, że rządy USA i Wielkiej Brytanii wzięły pod uwagę wnioski artykułu przy uchwalaniu budżetu na kolejny rok. Niepotrzebnie. Okazało się, że w swoich kalkulacjach autorzy pominęli – zupełnie przypadkowo – dane z kilku krajów. Po ich włączeniu do analizy z oryginalnego wyniku nic nie zostało.

Czy można usłyszeć ciszę?

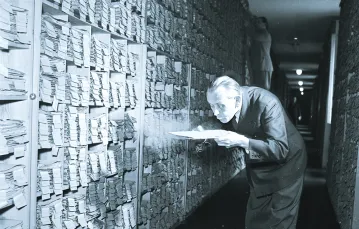

Nauką zajmuje się na świecie coraz więcej ludzi. Od kiedy do globalnego systemu wymiany naukowej dołączyły Chiny, ten trend bardzo przyspieszył. W 2013 r. opublikowano 2,4 mln artykułów naukowych i ta liczba wzrasta co roku o 8 proc. Z pozoru to dobra wiadomość, bo wydaje się, że im więcej naukowców, tym większej liczby odkryć i wynalazków możemy oczekiwać. Niestety, nie ma tu bezpośredniej zależności, bo praca badawcza zawsze była działalnością elitarną. Toteż znaczna część współczesnej produkcji naukowej jest niewiele warta i nikt jej nie cytuje. Jest tak w przypadku 12 proc. artykułów w dziedzinie medycyny, 27 proc. w naukach ścisłych, 32 proc. w naukach społecznych i aż 82 proc. w humanistyce.

Abstrakt od AI

Żeby zaradzić tej jałowości, w produkcji naukowej wprowadzono różnego rodzaju wskaźniki, takie jak impact factor (dla oceny pism) czy h-index (dla oceny naukowców), które biorą pod uwagę właśnie liczbę cytowań. Ale i tym razem hydra Goodharta podnosi głowę. Żeby zwiększyć liczbę cytowań swoich artykułów, wystarczy je samemu zacytować w kolejnych publikacjach. Redaktorzy pism naukowych potrafią cynicznie sugerować uzupełnienie bibliografii recenzowanych artykułów o swoje własne publikacje. I wreszcie grupy naukowców umawiają się na wzajemne cytowanie swoich tekstów, gdy nie ma to żadnego uzasadnienia merytorycznego. Członkowie takich „spółdzielni” osiągają dzięki temu fenomenalnie wysokie poziomy indeksu h, choć żaden z nich nie jest znany poza murami macierzystej uczelni.

To, jak bardzo podupadła jakość publikacji naukowych, pokazało kilka eksperymentów dokonanych ostatnio z użyciem ChatGPT. Autorzy tych badań, Catherine A. Gao i współpracownicy oraz Michael Dowling i Brian Lucey, zwrócili się do doświadczonych recenzentów o wskazanie, które fragmenty przedstawionych im tekstów z, odpowiednio, medycyny oraz finansów pochodziły z autentycznych pism naukowych, a które były wygenerowane przez ChatGPT. Recenzenci zidentyfikowali co prawda większość fragmentów autorstwa ChatGPT, ale sklasyfikowali też jako „sztuczne” wiele autentycznych artykułów. Zadanie recenzentów było zresztą ułatwione, bo wiedzieli oni, że część czytanych przez nich tekstów była mistyfikacją i nie jest wcale oczywiste, że rozpoznaliby którykolwiek z nich, gdyby dostali go do oceny tradycyjną drogą. Wszyscy bodaj komentatorzy wspomnianych eksperymentów wyrażają podziw dla możliwości ChatGPT, nie zauważając, że dorównanie standardom przeciętnego artykułu naukowego może wcale nie być wielkim osiągnięciem.

Migrena: więcej niż ból głowy

W ostatnich tygodniach algorytmy sztucznej inteligencji znalazły się w sercu kolejnej burzy, jaka przetoczyła się w środowisku naukowym. W czasopiśmie „Frontiers in Cell and Developmental Biology” ukazał się, a potem został szybko wycofany, tekst dotyczący mechanizmów biochemicznych występujących w komórkach macierzystych i rozrodczych u szczurów, którego autorzy przygotowali diagramy przy użyciu generatora obrazków Midjourney. W efekcie strony czasopisma zdobiła ilustracja ze szczurem o genitaliach większych od jego własnego ciała czy bardzo kolorowe i pełne nonsensów schematy szlaków sygnalizacyjnych rzekomo występujących w komórkach.

Brytyjski naukowiec Stuart Ritchie w znakomitej książce „Science Fictions” (z której pochodzi kilka z podanych wyżej przykładów) opisuje zbudowany kilka lat temu model komputerowy symulujący system uprawiania nauki z jego obecnymi zachętami i efektami. Okazało się, że optymalną strategią ambitnego naukowca jest w tym modelu prowadzenie wielu niewielkich projektów dla zmaksymalizowania liczby publikacji, nawet jeśli połowa zawartych w nich wyników jest mało wiarygodna. Dla Darwina czy Einsteina mogłoby w takim systemie zabraknąć miejsca. Peter Higgs, od którego nazwiska nazwano odkrytą potem cząstkę, mówił kilka lat temu: „Trudno sobie wyobrazić, żebym w dzisiejszych czasach miał czas i spokój, żeby zrobić to, co zrobiłem w 1964 r. Dziś nie dostałbym etatu akademickiego. Nie uznano by mnie za wystarczająco produktywnego”. Mamy dziś za to na uczelniach takich naukowców jak profesor Y.X. Gao z uniwersytetu Heilongjiang, który w latach 2004-2009 opublikował 279 artykułów na temat jednego tylko odkrycia w piśmie „Acta Clystallographica Section E”. Jak odnotowują Wei Quan i współpracownicy w swojej analizie wpływu systemu nagród stosowanych w Chinach na rozwój nauki, profesor Gao otrzymał połowę premii pieniężnych, jakie jego uczelnia wypłaciła swoim pracownikom w tych latach za ich działalność publikacyjną.

Nauka dla mas

Jak zatem naprawić naukę? Ritchie proponuje kilka rozwiązań: publiczną rejestrację rozpoczynanych projektów (dla zapobiegania fałszerstwom – to tzw. prerejestracja, na szczęście coraz powszechniejsza), publikacje internetowe bez recenzji (dla zapewnienia powszechnego dostępu do artykułów) czy wprowadzenie loterii w aplikacjach o granty (dla odciążenia naukowców). Każdy z tych pomysłów wart jest sprawdzenia, ale – jak przyznaje sam Ritchie – to leczenie symptomów, a nie źródeł problemu. Wydaje się bowiem, że sam system uprawiania nauki, który stworzony został 200 lat temu, nie sprawdza się w dzisiejszych czasach. Podstawowy problem to kwestia jego skalowalności. Kiedy Humboldt przeniósł naukę na uniwersytety, zajmowało się nią kilka tysięcy ludzi na świecie. Dziś jest to kilka milionów (w samej tylko Polsce jest ponad 80 tysięcy pracowników naukowych i prawie 40 tysięcy doktorantów), a w miarę wzrostu zamożności Chin i Indii ta liczba znacznie wzrośnie. Jest rzeczą chwalebną, że tak wielu ludzi chce się zajmować nauką, ale nauka zawsze była działalnością elitarną, gdzie ilość nie przekłada się na jakość.

Zaryzykuję wręcz tezę, że gdyby z dnia na dzień połowa najmniej produktywnych naukowców zaprzestała jakiejkolwiek działalności naukowej, nie miałoby to żadnego wpływu na jej rozwój. Może czas zgodzić się, że nie każda wyższa uczelnia musi być uniwersytetem badawczym – i nie każdy wykładowca akademicki naukowcem (zresztą w Polsce akurat ta zmiana już się dokonała – po reformie przeprowadzonej przez ministra Gowina powstała ścieżka kariery czysto dydaktycznej).

Cena, jaką płacimy za brak reform w nauce, to nie tylko trwonienie pieniędzy na niepotrzebne nikomu paranaukowe teksty, ale także dalszy spadek zaufania społecznego do nauki. Wspomniane na początku dane o znaczącym jego spadku w USA budzą niepokój, choć nie są zaskakujące. Ile razy lekarze sugerują nam leki lub terapie, które kilka lat potem okazują się bezużyteczne? Ile razy zmieniamy dietę tylko po to, by przekonać się po kilku miesiącach, że przynosi ona więcej szkody niż pożytku? Ile razy politycy, powołując się na ekspertów naukowych, wprowadzają pozbawione sensu przepisy? Im dłużej tolerować będziemy w nauce bylejakość, tym więcej będziemy mieli w społeczeństwie antyszczepionkowców i płaskoziemców.

Hodowla szczurzych ogonów

Dyskusja nad służącą poprawie jakości nauki zmianą systemu ewaluacji pracy naukowców toczy się obecnie również w Polsce. Przykładowo znany także z tych łamów Marcin Miłkowski, profesor Instytutu Filozofii i Socjologii PAN, przekonywał niedawno w „Forum Akademickim”, że sam proces ewaluacji nauki, oparty na liczbie publikacji ukazujących się w wysoko punktowanych przez nasze ministerstwo czasopismach i wydawnictwach, nie ma sensu, ponieważ jest zbyt drogi i nie służy poprawie jakości badań naukowych, tylko poprawie wskaźników, na podstawie których uznajemy, że jakieś badania są wartościowe. Uczelnie i naukowcy łatwo uczą się, jak ten system hakować. Dzięki temu cała procedura przypomina sytuację, w której zamiast zabrać się za naprawianie dziurawych dróg uczylibyśmy się retuszować zdjęcia prezentujące dziury na drogach.

Miłkowski posługuje się też innym barwnym porównaniem: gdy w 1902 r. w Hanoi wybuchła epidemia dżumy, władze poprosiły mieszkańców o pomoc i wyznaczyły nagrodę za każdego zabitego szczura, o których wiedziano, że roznoszą epidemię. Dowodem na zabicie gryzonia miał być przyniesiony szczurzy ogon. Już wkrótce w mieście zaczęło roić się od szczurów z obciętymi ogonami, które swobodnie się rozmnażały, co tylko prowadziło do wzrostu zysków zbieraczy ogonów. Naukowcy zachowują się podobnie, gdy swoją pracę dostosowują do panującego systemu – szukają łatwych ścieżek publikacji, przynoszących im jak najwięcej punktów, z których są rozliczani. Rozwój kariery uczonych czy dobro instytucji często wymaga działań, które wcale nie służą postępowi naukowemu.

ŁK