Wykupienie dostępu pozwoli Ci czytać artykuły wysokiej jakości i wspierać niezależne dziennikarstwo w wymagających dla wydawców czasach. Rośnij z nami! Pełna oferta →

Od niemal 90 lat w publikacjach naukowych pojawia się pojęcie „statystycznej istotności”. Słyszymy m.in. o statystycznie istotnych różnicach w reakcjach pacjentów, którym podano nowy lek, oraz tych, którzy przyjęli placebo. Czytamy o wykazaniu statystycznie istotnego wpływu jednej zmiennej (np. jakości powietrza w mieście) na drugą (długość życia mieszkańców) albo o statystycznie istotnej korelacji (np. koncentracji dwutlenku węgla w atmosferze i średniej temperaturze na Ziemi).

Tymczasem coraz większa liczba naukowców opowiada się za zmianą podejścia do pojęcia istotności statystycznej i – tym samym – zmianą sposobu prowadzenia badań naukowych. Czasopismo „Nature” z marca tego roku tytułuje swój komentarz: „Czas skończyć już z kategorią statystycznej istotności”. W tym samym czasie inne cenione czasopismo naukowe „The American Statistician” zamieściło 43 artykuły poświęcone temu właśnie zagadnieniu – ułomności w ocenianiu, mierzeniu i komunikowaniu statystycznej istotności.

Źródło niepewności

Pojęcie statystycznej istotności wiąże się przede wszystkim z niepewnością, której źródłem jest dokonanie pomiarów na określonej próbie losowej, a nie na wszystkich jednostkach interesującej badacza populacji. Gdyby interesowała nas różnica między średnim wzrostem dziewcząt i chłopców pewnej szkoły, to po zmierzeniu wszystkich uczniów moglibyśmy stwierdzić, że różnica ta wynosi np. 3 cm, i nie bardzo byłoby tu miejsce na określenie, czy jest ona statystycznie istotna czy nie. Po prostu wynosi 3 cm w całej badanej zbiorowości. Jedni mogliby powiedzieć, że to sporo, inni – że raczej mało, ale dla pojęcia istotności statystycznej nie miałoby to żadnego znaczenia.

Gdyby jednak tę samą liczbę dziewcząt i chłopców (w określonym przedziale wieku) wylosowano do próby z populacji całego kraju w celu wnioskowania o różnicy przeciętnego wzrostu w ogólnokrajowej populacji, to sytuacja wyglądałaby inaczej. Przede wszystkim w losowej próbie liczymy się z tym, że mają prawo wystąpić różnice i odchylenia w stosunku do struktury populacji, z której próbę pobrano. Taka jest natura losowości. W końcu nikt się raczej nie upiera, że kostka do gry jest nierzetelna, jeżeli w dziesięciu kolejnych rzutach nie wypadła „szóstka”.

Losowość ma bowiem swoje prawa. Badacz otrzymuje w próbie wyniki, które nie są doskonałym odzwierciedleniem populacji. Akceptuje więc pewne odchylenia, podobnie jak gracz rzucający kostkę, nieco zniecierpliwiony brakiem „szóstki”. Ale gdy wielkość tych odchyleń wzrasta, pojawiają się wątpliwości, czy wciąż da się je wytłumaczyć wyłącznie losowością obserwacji.

Jeżeli po 15 lub 20 rzutach kostką nadal nie pojawia się „szóstka”, to coraz poważniej traktujemy przypuszczenie, iż kostka nie jest symetryczna.

W pewnym momencie badacz stwierdza, że choć świadom jest istnienia zakłóceń spowodowanych niedoskonałością mechanizmu losowania, czyli istnienia błędu losowego, nie może uznać zaobserwowanych odchyleń za losowe. Stwierdza więc, że istnieje statystycznie istotna różnica pomiędzy strukturą próby a strukturą populacji. Innymi słowy, statystycznie istotny oznacza znaczący, nawet po uwzględnieniu dopuszczalnych rozbieżności spowodowanych czynnikami losowymi.

Istotny czy ważny?

Już w samym brzmieniu terminu „statystycznie istotny” kryje się pewna pułapka. Większość osób, które wcześniej nie interesowały się naukowymi eksperymentami i wnioskowaniem, termin ten utożsamiać będzie z czymś ważnym, doniosłym, kluczowym. Bardzo podobne jest zresztą rozumienie tego terminu w języku angielskim (statistically significant). Tymczasem statystycznie istotny nie zawsze oznacza ważny. Czasami może wręcz opisywać coś mało ważnego. I vice versa – określenie „statystycznie nieistotny” może odnosić się do czegoś ważnego albo mającego duży potencjał. To pierwszy z powodów, dla których część naukowców wolałaby nie używać tego terminu.

Prześledźmy to na przykładzie. Załóżmy, że w badaniach nad nowym lekiem A na nadciśnienie uzyskano wynik wskazujący na to, iż jego zastosowanie obniża ciśnienie krwi średnio o 0,2 jednostki, a odchylenia od tego wyniku są u poszczególnych pacjentów niewielkie (przeciętnie 0,03 jednostki). Wynik taki uznany zostanie za statystycznie istotny.

Sens tego stwierdzenia będzie taki, iż lek A z dużą dozą pewności powoduje spadek ciśnienia krwi u pacjentów, którzy go otrzymali. Jest to co prawda niewielki spadek, ale występuje u niemal wszystkich poddanych badaniu, ponieważ przy tak małym rozproszeniu wyników nie znajdzie się niemal żaden pacjent, którego ciśnienie nie zmniejszyłoby się w wyniku podania leku A.

Nie sposób wytłumaczyć zaobserwowanego obniżenia ciśnienia krwi wyłącznie czynnikami losowymi. Niestety, w praktyce znaczenie tych wyników testowania leku A będzie niewielkie, biorąc pod uwagę, że typowy poziom ciśnienia krwi u człowieka waha się w okolicy stu jednostek. Trudno więc będzie traktować statystycznie istotny wynik jako ważny lub doniosły.

I odwrotnie: wynik badania, w którym inny lek B obniża ciśnienie krwi aż o dziesięć jednostek, z przeciętnym odchyleniem ciśnienia u badanych pacjentów równym także dziesięć jednostek, zostanie uznany za statystycznie nieistotny. Duże zróżnicowanie reakcji pacjentów na ten lek wyraża niepewność co do jego skuteczności. Czyli u znacznej frakcji pacjentów nie będzie żadnej reakcji na lek B, a u części nastąpi nawet wzrost ciśnienia. Rezultat działania tego leku jest statystycznie nieistotny, choć w dalszych badaniach nad nim może się to zmienić. Wszak przeciętnie skutkuje on spadkiem ciśnienia krwi aż o dziesięć jednostek. Ważny może się okazać potencjał leku B.

Problemem, który dotyczy nas wszystkich, nie tylko naukowców, są konsekwencje uznania działania danego leku za statystycznie nieistotne. Cóż z tego, że lek ten ma potencjał, że warto prowadzić nad nim dalsze badania, skoro etykieta „statystycznie nieistotne zmiany” byłaby dla badaczy jak wyrok. Trudniej z takimi wynikami uzyskać finansowanie dalszych badań, a jeszcze trudniej przebić się z publikacją „statystycznie nieistotnych” rezultatów. W publikacjach naukowych – jak przyznaje coraz więcej badaczy – występuje więc sztuczna nadwyżka badań nie zawsze ważnych, ale zarazem takich, które zdołały uzyskać status statystycznie istotnych. Drugą stroną medalu jest porzucenie innych badań i brak podejmowania dyskusji nad nimi tylko dlatego, że statusu tego nie uzyskały. Ostateczne koszty tego ponosimy wszyscy, nie tylko naukowcy.

Próg pięciu procent

W tych okolicznościach trudne do przecenienia są jasne i jednoznaczne kryteria, które decydują o uznaniu rezultatów badań za statystycznie istotne bądź nieistotne. I ta właśnie sprawa jest drugą fundamentalną kwestią wywołującą rosnące niezadowolenie w środowiskach naukowych. Wraz z upowszechnieniem się sprawnego oprogramowania komputerowego, zdolnego wykonać w ciągu kilku sekund skomplikowane obliczenia statystyczne, coraz częściej o uznaniu wyników badania za statystycznie istotne przesądza tylko jeden prosty wskaźnik. Programy komputerowe wyliczają go błyskawicznie. Wskaźnikiem tym jest tzw. prawdopodobieństwo krytyczne, częściej nazywane z angielskiego p-value. Jest to prawdopodobieństwo tego, że określona miara syntetyczna wyników z próby (np. średnia arytmetyczna) przyjmie wartość taką, jak zaobserwowano, lub bardziej od niej ekstremalną (większą lub mniejszą). Gdy przy sformułowanej na wstępie hipotezie badawczej okaże się, że w próbie zaobserwowano wyniki, które są bardzo mało prawdopodobne, to uznaje się, że hipoteza jest nieprawdziwa. Przyjmując np. założenie, że kostka do gry jest symetryczna, prawdopodobieństwo nieuzyskania ani jednej „szóstki” w dwudziestu kolejnych rzutach, wynoszące 0,026, jest na tyle małe, że przesądza o uznaniu kostki za niesymetryczną. Gdzie więc leży wartość graniczna prawdopodobieństwa, poniżej której badacz decyduje się na uznanie wyjściowej hipotezy za fałszywą?

W większości dziedzin nauki przyjmuje się, że progiem tym jest dla p-value wartość 0,05. Innymi słowy, stając przed wyborem, czy uznać, że w losowej próbie zrealizowało się zdarzenie o prawdopodobieństwie mniejszym niż 5 proc., czy raczej to, że wyjściowa hipoteza jest nieprawdziwa, badacz wybiera to drugie (zob. ramka). W ten sposób całość analiz statystycznych zostaje zredukowana do sprawdzenia, czy wskaźnik p jest większy, czy mniejszy od 0,05. Tak daleko posunięte uproszczenie staje się jednak dla wielu nie do zaakceptowania. Między innymi Amerykańskie Towarzystwo Statystyczne wydało przed trzema laty specjalne oświadczenie na ten temat, zwracając uwagę na niebezpieczeństwa takich uproszczeń. A dyskusję we wspomnianym „The American Statistician” z bieżącego roku otwiera artykuł pod znamiennym tytułem: „Wkraczając do świata poza p 0,05”.

Niektóre dziedziny stosują bardziej wyśrubowane kryteria wartości p. W fizyce cząstek elementarnych istnienie postulowanej cząstki uznaje się za udowodnione dopiero przy osiągnięciu wartości p równej 0,0000003. Jednak większość dziedzin, zwłaszcza tych, gdzie czysty eksperyment jest niemożliwy, nie może sobie na taki luksus pozwolić. W medycynie czy naukach społecznych (np. psychologii) ani próba nie może być dowolnie duża, ani nie jest realne założenie, że wyniki w próbie nie są obarczone innymi błędami, głównie nielosowymi.

Wspólnym wnioskiem z tych dyskusji i postulatem statystyków jest to, aby wskaźnika p-value nie uznawać ani za decydujący, ani za jedyny w rozstrzyganiu o prawdziwości sprawdzanej hipotezy. Większość badaczy sprzeciwia się ustanawianiu progu dla prawdopodobieństwa p i jego dychotomizacji.

Postuluje się, aby w publikacjach z badań podawać konkretne wartości tego wskaźnika, informować czytelnika o wszystkich sprawdzanych hipotezach, o założeniach wykorzystywanego modelu, a także o możliwych błędach w realizacji badania.

Chodzi więc o większą przejrzystość procesu badania i wnioskowania, której nie jest w stanie zapewnić proste stwierdzenie o przekroczeniu przez p-value progu 5 proc.

W niewoli komputerów

Sądzę, że to poruszenie w świecie nauki ma szereg pozytywnych konsekwencji.

Po pierwsze, uświadamia nam wszystkim, jak bardzo ulegamy w naszych działaniach – także w sferze badań naukowych – prymatowi techniki.

Mniej lub bardziej świadomie podporządkowujemy nie tylko to, co robimy, ale często także to, jak myślimy, nowym rozwiązaniom oferowanym przez technologię komputerową.

Po drugie, dyskusje na temat statystycznej istotności pokazują, jakie zagrożenia tkwią w uproszczonych kryteriach oceny wartości naukowej rezultatów badań. Znaczny procent wyników badań – jak stwierdzają w komentarzu opublikowanym w „Science” w marcu tego roku Valentin Amrhein z Uniwersytetu Bazylejskiego i współpracownicy – nie znajduje potwierdzenia w powtórzonych doświadczeniach.

Po trzecie, oprócz zagrożeń ujawnia się też w tego typu uproszczonych procedurach potencjalnie dużo zaniechanych wysiłków badawczych, gdy pierwsze wyniki nie znalazły się po właściwej stronie progu 5 proc. Skłonni do zbyt daleko idących uproszczeń, kuszeni świetnym oprogramowaniem komputerowym, naukowcy zbyt dużo ryzykują. Chodzi nie tylko o prestiż ich pracy, ale w równym stopniu o pożytek, jaki społeczeństwa mają z finansowania badań naukowych. Dlatego dobrze, że w tym względzie szykuje się zmiana. ©

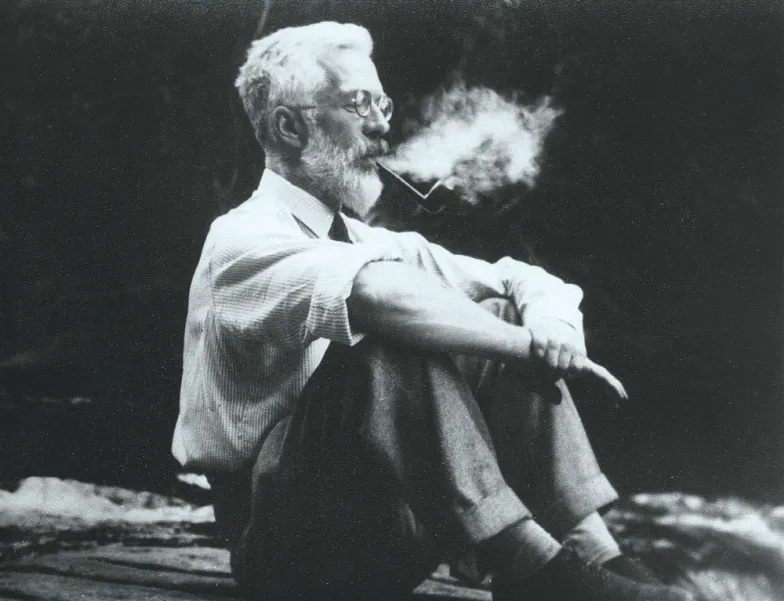

HIPOTEZA ZEROWA RONALDA FISHERA

Zagadnienie statystycznej istotności efektów, które obserwuje się w eksperymentach prowadzonych na próbach losowych, wiąże się z ważnym dla nauki problemem weryfikacji hipotez. Autorem jednego z podejść do testowania hipotez był Ronald A. Fisher, niezwykle wpływowy statystyk i ewolucjonista.

Fisher posługiwał się pojęciem tzw. hipotezy zerowej, która zakłada, że uzyskany wynik jest efektem przypadku. Jeżeli przy założeniu, że hipoteza zerowa jest prawdziwa, uzyskano wynik eksperymentu mało prawdopodobny – trudny do wytłumaczenia zmiennością losową lub przypadkiem – to świadczyć to miało przeciw hipotezie zerowej.

Kiedy przyjaciółka Fishera Muriel Bristol stwierdziła, że herbata smakuje jej tylko wtedy, gdy najpierw do filiżanki naleje się mleko, a dopiero potem herbatę, i jest w stanie to rozpoznać, Fisher postanowił z przyjaciółmi sprawdzić tę zaskakującą umiejętność. Stwierdził, że zamiast próbować dowodzić, iż Muriel potrafi rozróżnić, w której filiżance do mleka dodano herbatę, a w której do herbaty mleko, należy raczej dążyć do odrzucenia hipotezy (zerowej), że dokonany przez nią wybór jest podyktowany przypadkiem (losowością). Eksperyment z dwiema filiżankami herbaty, w których w odmiennej kolejności nalano herbatę i mleko, nie wchodził w grę, gdyż losowo zgadując, Muriel miałaby aż 50 proc. szans na udzielenie poprawnej odpowiedzi najpierw nalano herbaty (następnie dodano trochę mleka), w przypadku pozostałych czterech postąpiono odwrotnie. Okazało się, że Muriel bezbłędnie wskazała wszystkie filiżanki z rzeczywistą kolejnością nalewania mleka i herbaty. Prawdopodobieństwo tego, że losowo udzieli się w pełni poprawnej odpowiedzi w tym eksperymencie, wynosi zaledwie 1/70, czyli 1,4 proc.

Co prawda Fisher nie mógł ze stuprocentowym przekonaniem wykluczyć, że Muriel po prostu sprzyjało szczęście, ale byłoby to bardzo mało prawdopodobne.

Za próg, poniżej którego prawdopodobieństwo radził uznać za zbyt małe, by utrzymała się hipoteza zerowa, wskazał właśnie 5 proc. ©