Wykupienie dostępu pozwoli Ci czytać artykuły wysokiej jakości i wspierać niezależne dziennikarstwo w wymagających dla wydawców czasach. Rośnij z nami! Pełna oferta →

Czy więcej danych zebranych w badaniu statystycznym, jak sondaż wyborczy, może oznaczać gorszą jakość wnioskowania? Pytanie to ma prawo dziwić, gdyż dla większości z nas więcej oznacza zwykle lepiej. Więcej informacji zgromadzonych o danej zbiorowości powinno się przekładać na lepszą jakość opisu jej charakterystyk. Wraz ze zwiększaniem się liczby obserwacji w próbie powinna następować poprawa wiarygodności i precyzji uzyskanych ocen. Niestety, tak się dzieje jedynie w sytuacjach modelowych, od których coraz częściej i coraz dalej odbiega rzeczywistość podlegająca najróżniejszym badaniom statystycznym. Przede wszystkim rzeczywistość życia społecznego i politycznego.

W gorączce kampanii wyborczej konkurować zdają się ze sobą nie tylko kandydaci i partie, ale także sondaże. Często słyszymy, że typowy błąd takich badań wynosi 3 proc., co w praktyce oznacza, że rzeczywiste wyniki każdej partii mogą się różnić od tych uzyskanych w naszym sondażu o trzy punkty procentowe. Taka różnica to dla niektórych partii kwestia zwycięstwa w wyborach, wejścia do parlamentu albo osiągnięcia samodzielnej większości. Któż z nas nie wolałby przeczytać sondażu, w którym ukazałby się błąd 1 proc.? Zmniejszenie błędu z 3 do 1 proc. wiąże się z koniecznością zbadania dodatkowych ponad 8,5 tys. respondentów (co oznacza automatycznie większe koszty badania).

Obok kwestii finansowej co najmniej równie istotnym powodem trwania przy standardowej próbie 1,1 tys. respondentów oraz 3-procentowym błędzie świadomość wpływu innych błędów na ostateczne wyniki wśród realizatorów tych badań. Chodzi o błędy nielosowe, które w przeciwieństwie do błędu losowego (błędu losowania) nie ulegają zmniejszeniu wraz ze wzrostem liczebności próby. A w całkowitym błędzie badania, przy rosnącej liczebności próby, ich udział rośnie!

Geneza błędów systematycznych

Problem ten ma znacznie szerszy zakres, wykraczający dalece poza typowe sondaże polityczne lub ankiety konsumenckie. Dotyczy bowiem badań statystycznych, w szczególności wszelkich badań reprezentacyjnych, w różnych obszarach nauk społecznych. Oznacza on, że zwiększanie wielkości próby losowej – kosztowne, ale stosunkowo łatwe, przy wykorzystaniu współczesnych narzędzi teleinformatycznych – nie daje podstaw do twierdzenia, że trafniej i precyzyjniej wnioskujemy o badanych zbiorowościach. Czyli rosnąca liczba obserwacji w próbie losowej może niekiedy szkodzić jakości wnioskowania.

Żeby mechanizm ten zrozumieć, trzeba się cofnąć do początków XX wieku i prac dwóch twórców klasycznego wnioskowania statystycznego: Egona Pearsona (1895–1980) oraz polskiego statystyka Jerzego Neymana (1894–1981). Tworząc aktualne do dzisiaj fundamenty przedziałowej estymacji nieznanych wielkości populacji (np. średniej wartości dochodów w gospodarstwach domowych czy odsetka wyborców popierających daną partię polityczną) oraz procedury testowania hipotez, skupili się tylko na jednym z błędów, jaki w badaniach reprezentacyjnych może wystąpić – na błędzie losowania.

Z tym błędem powiązali zarówno wymaganą wielkość próby, precyzję oszacowań (szerokość przedziału, w którym z dużym prawdopodobieństwem znajduje się interesujący nas parametr populacji), jak i jakość (moc) testów statystycznych, czyli ich zdolność do rozstrzygania o prawdziwości lub nieprawdziwości hipotez.

Założenie o losowym wyborze jednostek do próby pozwoliło na zastosowanie w tej koncepcji klasycznego rachunku prawdopodobieństwa oraz na włączenie do rozważań kilku znanych już wówczas rozkładów prawdopodobieństwa, przede wszystkim rozkładu Gaussa (nazywanego też rozkładem normalnym). I wszystko w tym podejściu dobrze się sprawdza w praktyce, dopóki nie pojawią się zakłócenia: albo w strukturze próby badawczej, albo w informacjach uzyskanych od wylosowanych jednostek.

Pierwsza z tych sytuacji obejmuje bardzo powszechne problemy z odmowami respondentów wylosowanych do próby i konieczność odstępstw od założonej struktury próby, a także nie mniej częste błędy w wykazach osób z badanych populacji. Druga zaś sytuacja to zakłócenia w modelu wnioskowania spowodowane przede wszystkim udzieleniem przez respondentów nieścisłych lub nieprawdziwych informacji (świadomie lub nieświadomie). Przy czym warto dodać, że owe nieścisłe dane mogą być m.in. wynikiem źle skonstruowanego kwestionariusza, niewłaściwie dobranej metody pomiaru sondażowego albo niestaranności w pracy ankietera. Niekoniecznie muszą one obciążać respondenta.

Błędy powstałe w wyniku omawianych zakłóceń nie znalazły swojego miejsca w koncepcji wnioskowania stworzonej przez Neymana i Pearsona. W konsekwencji trudno oszacować ich wpływ na jakość wnioskowania. Z tego powodu wysiłek realizatorów badań koncentruje się nie tyle na pomiarze wielkości tych błędów, co na minimalizowaniu ich skali oraz wpływu na wyniki wnioskowania.

I tu wracamy do kwestii liczebności próby. Czy większa liczba obserwacji w próbie nie byłaby remedium na te błędy? Odpowiedź na to pytanie prześledźmy na przykładzie najbardziej uciążliwego w badaniach reprezentacyjnych błędu braków odpowiedzi.

Co oznacza brak odpowiedzi

Najprostsza, ale i najmniej prawdopodobna jest sytuacja, kiedy odmowy wśród respondentów można potraktować jako losowe. Byłyby takie, gdyby można uznać, iż nie są powiązane z cechami korespondującymi z celem badania. Na przykład, gdyby w sondażu na temat oceny prac rządu przez wyborców poszczególnych ugrupowań politycznych frakcje odmów nie były zależne od preferencji partyjnych. Losowa eliminacja obserwacji w próbie nie powodowałaby wówczas błędów systematycznych. Zmniejszyłaby się co prawda wielkość zaprojektowanej próby, ale wciąż posiadałaby ona swoje atrybuty reprezentatywności.

W praktyce jednak z taką sytuacją mamy do czynienia rzadko. Znacznie częściej odmowy są powiązane z pewną cechą charakteryzującą respondentów odmawiających współpracy. Na przykład w badaniu wydatków gospodarstw domowych współpracy mogą odmawiać respondenci o wysokich dochodach. Są oni w zaprojektowanej próbie losowej zastępowani dodatkowo wylosowanymi osobami, wśród których nadal ci o wysokich dochodach nie godzą się na uczestniczenie w badaniu. Ostatecznie badacz pozostaje z próbą, w zamierzeniu reprezentatywną, w której brakuje obserwacji z pewnej szczególnej części populacji (tej o wysokich dochodach). Jest oczywiste, że sytuacja ta rodzić będzie błąd systematyczny – niedoszacowanie wydatków, spowodowane brakiem obserwacji u tych, którzy najprawdopodobniej wydają najwięcej.

Przykładowo: uzyskane z badania oszacowanie średnich wydatków wyniesie 1000 zł, a w rzeczywistości wynosi ono w populacji 1200 zł (i tyle otrzymalibyśmy w badaniu, gdyby nie odmówili w nim udziału najbogatsi). Zwiększenie liczebności próby, mimo że dostarczać będzie nowych danych, nie będzie miało wpływu na powstałe obciążenie (czyli zafałszowanie) wyników wnioskowania. Nie będzie w stanie go zmniejszyć, a tym bardziej wyeliminować.

Mało tego, dodawanie kolejnych obserwacji w próbie będzie w tych warunkach pogarszało całą sytuację. Otrzymywać będziemy coraz „mocniejsze dowody” na to, że średnie wydatki wynoszą właśnie ok. 1000 zł. Każde zwiększenie liczby obserwacji (zniekształconych przez odmowy) upoważniać będzie do przypisania wynikom takiego badania mniejszego błędu. Czyli mniejszej rozpiętości przedziału, w której znajduje się nieznana wielkość średnich wydatków. Coraz ściślej oszacowania średnich wydatków będą się koncentrować wokół nieprawdziwej wartości 1000 zł.

Coraz mniej prawdopodobne więc będzie, że w przedziale takim zmieści się rzeczywista wartość 1200 zł. Realizatorzy badania deklarować więc będą zmniejszający się błąd statystyczny, a w rzeczywistości oznaczać to będzie coraz silniejsze utwierdzanie odbiorców w błędnym przekonaniu.

Tu wróćmy do sondaży. Zakładając przykładowo, że znaczna większość elektoratu pewnej partii „Z” odmawia udziału w badaniach opinii, wyniki sondaży będą w tych warunkach systematycznie (a nie losowo) zniekształcone. Niedoszacowanie w sondażach partii „Z” może wynieść 2 pkt. proc. Jeżeli sondaż wykonywany jest na typowej próbie ok. 1,1 tys. respondentów, to towarzyszący mu błąd 3 proc. jest na tyle duży, że najczęściej (przeciętnie) prawidłowo będzie informował o rzeczywistym poparciu dla partii „Z” (ponieważ pamiętamy, że rzeczywisty wynik każdej partii może się różnić o trzy punkty procentowe od takiego sondażu). Gdyby jednak wielkość próby zwiększyć do prawie 10 tys. respondentów, to pracownia wykonująca taki sondaż podałaby słusznie, iż błąd losowania (błąd statystyczny) nie przewyższa 1 proc. Ogólne wrażenie z takiego sondażu byłoby pozytywne, bo zmalał błąd. W rzeczywistości zaś pogorszeniu uległaby jakość wnioskowania – bo prawie do zera zmalałoby prawdopodobieństwo tego, że w przedziale – o rozpiętości plus minus 1 proc. – znajdzie się rzeczywista frakcja poparcia dla partii „Z”. Dopóty, dopóki wyniki badania będą obciążone błędem systematycznym, zwiększenie liczby obserwacji w próbie prowadzić będzie do umacniania się badaczy w błędnym przekonaniu i utwierdzaniu w nim odbiorców.

Problemy Big Data

W ogromnej większości wykonywanych badań ankietowych i sondażowych deklarowany błąd odnosi się jedynie do tej części całkowitego błędu, za który odpowiada mechanizm losujący. Znacznie poważniejszym wyzwaniem są współcześnie błędy nielosowe. Szczególnie zaś wtedy, kiedy powodują systematyczne obciążenia wyników w próbie. Wówczas zwiększanie liczby obserwacji nie tylko nie poprawia jakości wnioskowania, lecz może ją wręcz pogorszyć.

Warto o tym pamiętać także w kontekście Big Data. Samo posiadanie bardzo dużych zbiorów obserwacji nie gwarantuje poprawnego wnioskowania. W zbiorach tych systematyczne obciążenia mogą wynikać z pominięcia w ciągach obserwacji osób nieposiadających telefonów komórkowych, nieobecnych na portalach społecznościowych albo niedokonujących transakcji handlowych w internecie. W zbiorach Big Data dominują błędy nielosowe, a nie błąd losowy, który potrafimy mierzyć i kontrolować. A co może najważniejsze: zwiększenie czy nawet zwielokrotnienie liczby obserwacji nie jest w stanie zmniejszać wielkości błędów nielosowych i ich wpływu na ostateczne wyniki wnioskowania. ©

Autor jest profesorem, ekonomistą, specjalizuje się w rozwoju i nowych zastosowaniach nauk ilościowych. Kierownik Katedry Statystyki na Wydziale Zarządzania Uniwersytetu Gdańskiego, członek Komitetu Statystyki i Ekonometrii PAN.

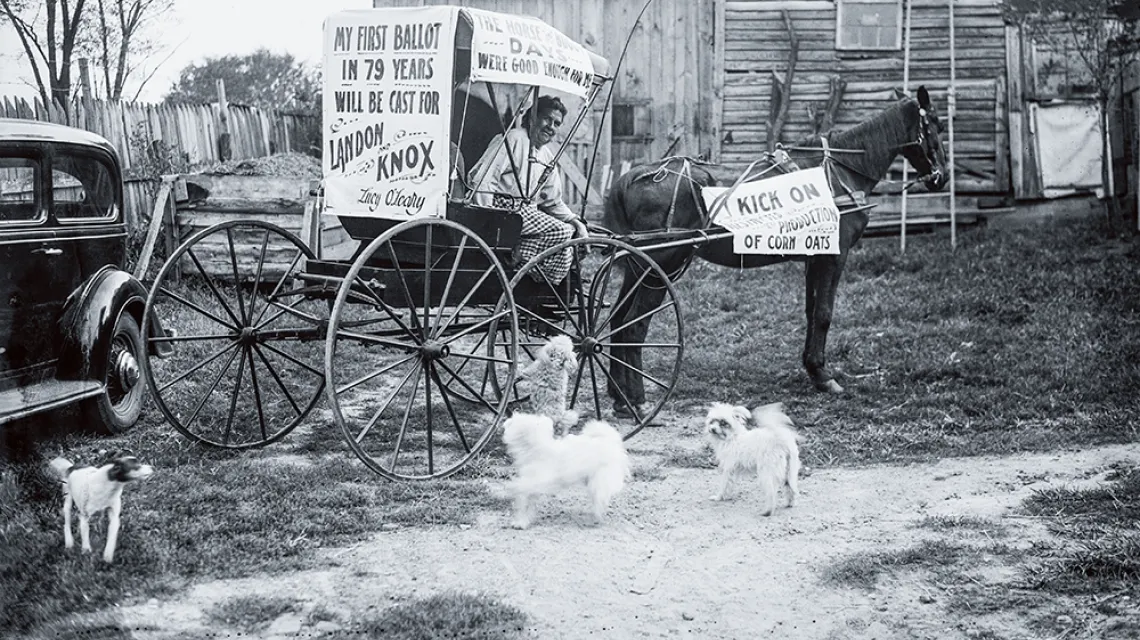

Na zdjęciu: 79-letnia LUCY O’LEARY, która po raz pierwszy zagłosuje w wyborach prezydenckich w listopadzie 1936 r. – na Republikanina Alfa Landona. Przedwyborczy sondaż magazynu „Literary Digest” sugerował, że 57 proc. wyborców zagłosuje tak samo. W ankiecie wypowiedziało się 2 mln Amerykanów, spośród 10 mln, których listownie poproszono o głos. Wybory wygrał jednak Demokrata Franklin D. Roosevelt, z 60 proc. głosów.

Kiedy próba jest reprezentatywna?

Nie ma ścisłej matematycznej definicji próby reprezentatywnej. Jest to podzbiór jednostek badanej zbiorowości – wybranych zwykle drogą losowania – którego struktura jest zgodna ze strukturą całej populacji. Innymi słowy, reprezentatywna próba to populacja „w pigułce”.

„Próba reprezentatywna” i „próba losowa” to nie to samo.

Po pierwsze dlatego, że reprezentatywna może być też próba, do której jednostki wybrano inaczej niż przez losowanie. Np. odwzorowując w niej znaną wcześniej strukturę populacji.

Po drugie, samo losowanie nie gwarantuje uzyskania reprezentatywnej próby. Losując np. sto przedsiębiorstw spośród wszystkich firm na danym terenie, często uzyska się próbę złożoną wyłącznie z mikroprzedsiębiorstw, bo stanowią one ponad 98 proc. całej zbiorowości, a firmy małe, średnie i duże to pozostałe 2 proc. Taka próba będzie niereprezentatywna ze względu na średnią wartość majątku, produkcji, inwestycji itp.

W praktyce reprezentatywne próby uzyskuje się najczęściej łącząc wstępną wiedzę o strukturze populacji z losowaniem. Np. w losowaniu warstwowym, stosowanym w ogólnokrajowych badaniach, takich jak „Diagnoza społeczna”, losuje się jednostki osobno z każdej wcześniej określonej grupy (warstwy) populacji. © MSz