Wykupienie dostępu pozwoli Ci czytać artykuły wysokiej jakości i wspierać niezależne dziennikarstwo w wymagających dla wydawców czasach. Rośnij z nami! Pełna oferta →

Sztuczna inteligencja wskazała wynik wyborów parlamentarnych dokładniej niż sondażownie”. „Ludzkości zajęło kilka stuleci odkrycie, że Ziemia krąży wokół Słońca, a sztuczna inteligencja doszła do tego wniosku w kilka godzin”. Albo: „Naukowcy z Uniwersytetu Technicznego w Delft wynaleźli bardzo mocny materiał, nie prowadząc żadnych testów, a jedynie wykorzystując sztuczną inteligencję”.

To najnowsze doniesienia i wciąż można by je aktualizować, bo w zasadzie codziennie pojawiają się kolejne informacje o tym, jakich cudów i przełomów udało się dokonać dzięki sztucznej inteligencji (artificial intelligence, AI). Tyle że jej twórcy aż takiego zachwytu nie podzielają.

„Wciąż jesteśmy daleko od sztucznej inteligencji, która posiadałaby ogólną inteligencję choćby na poziomie pchły” – mówi David Gausebeck, współzałożyciel Matterport, firmy, która skanuje świat w 3D. Arcymistrz szachowy Garri Kasparow podsumowuje równie jednoznacznie: „Jesteśmy na początku MS-DOS, a ludzie myślą, że mamy już Windowsa”.

Magia czy technologia

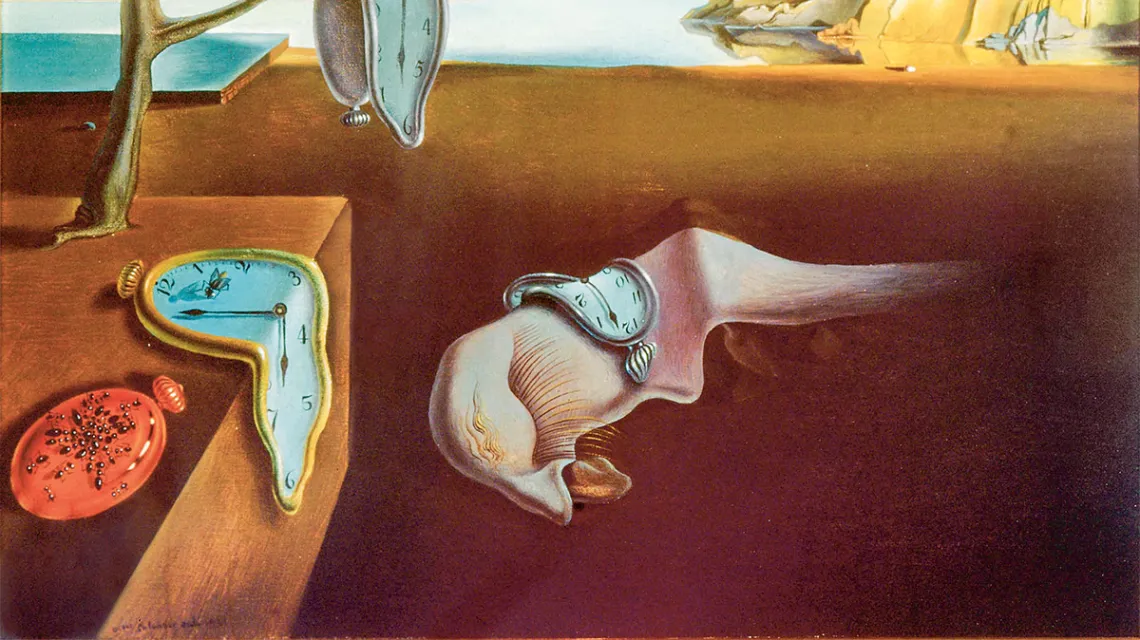

„Forbes” przepytał 50 czołowych twórców sztucznej inteligencji o jej kondycję i w zasadzie wszyscy się zgodzili co do jednego: ludzie nie rozumieją, z czym mają do czynienia. Sarjoun Skaff, współzałożyciel i dyrektor generalny Bossa Nova Robotics, w wywiadzie dla magazynu podkreślał, że największym nieporozumieniem, z jakim się spotyka, jest przekonanie, że sztuczna inteligencja jest... inteligentna: „To bardzo dobre narzędzie do dopasowywania wzorców, ale żeby funkcjonowało dobrze, naukowcy muszą zrozumieć szczegóły jego działania i nie traktować jak inteligentnej czarnej skrzynki”. Skrzynki, której odpowiedzi przyjmują bezrefleksyjnie, choć zupełnie nie mają pojęcia, skąd się wzięły. W przypadku naukowców nie powinno się sprawdzać prawo Arthura C. Clarke’a, legendy science fiction i autora „2001: Odysei kosmicznej”, który twierdził, że „każda dostatecznie zaawansowana technologia jest nie do odróżnienia od magii”.

Sztuczna inteligencja stała się chętnie nadużywanym pojęciem-parasolem. Dowody, jak mocno nadużywanym, można znaleźć m.in. w raporcie londyńskiej firmy inwestycyjnej MMC Ventures. Przeanalizowano w nim działalność 2830 europejskich start-upów, które twierdziły, że zajmują się sztuczną inteligencją. Okazało się, że 40 proc. tego po prostu nie robi, a pięknie brzmiące deklaracje służą jedynie pozyskaniu inwestorów.

Nadużywanie tego pojęcia bierze się stąd, że sztuczna inteligencja, wedle definicji, to gałąź informatyki, której celem jest stworzenie komputerów zdolnych do wykonywania czynności wymagających ułamka ludzkiej inteligencji. Z drugiej strony, twórcy AI rozumieją dziś to pojęcie zadaniowo – a tworzone przez nich algorytmy oparte o sztuczną inteligencję radzą sobie ze stawianymi przed nimi zadaniami (w rodzaju: „rozpoznaj twarz na zdjęciu”, „wytycz najszybszą trasę” czy, dajmy na to, „przetłumacz tekst z tamilskiego na korsykański”) sprawnie, inteligentnie, a niekiedy wręcz spektakularnie.

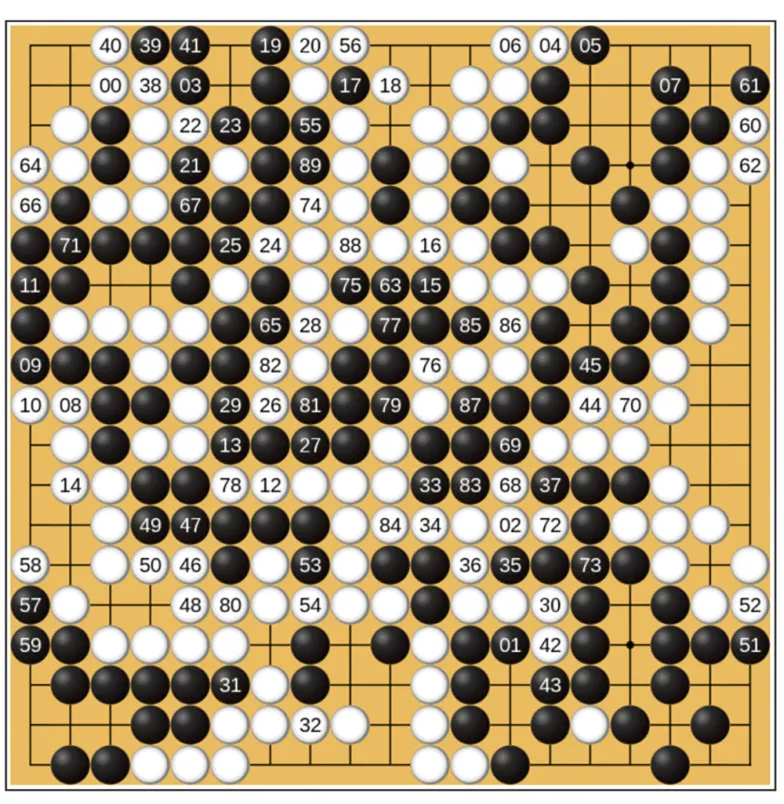

Nieżyjący już Marvin Minsky, współzałożyciel laboratorium sztucznej inteligencji w Massachusetts Institute of Technology (MIT), wskazywał, że częścią problemu ze zrozumieniem, czym AI jest, a czym nie, są „słowa-walizki”. Przypisuje się im wiele znaczeń, by mówić krótko o skomplikowanych sprawach. Jednym z takich słów jest „uczenie”. Oznacza całkiem inne doświadczenia, gdy myślimy o nauce gry gam na pianinie, niż kiedy chodzi o nauczenie się rozpoznawania dźwięków w utworze albo nut zapisanych na papierze. Kiedy ludzie słyszą o „uczeniu maszynowym”, zwykle automatycznie odnoszą to do ludzkich doświadczeń. Tymczasem to, że komputer tak dobrze „nauczył się” grać, iż pobił ludzkiego mistrza szachów (1997) czy najlepszych graczy w starożytną chińską grę go (2016), wcale nie znaczy, że ów komputer w ogóle był świadomy tego, iż prowadził grę ani nawet co to jest gra. Mało tego, zmiana zasad automatycznie nie nokautuje ludzi, lecz od razu rozłoży na łopatki AlphęGo czy Deep Blue.

Mimo że moda na wszystko, co inteligentne – od żarówek i szczoteczek do zębów, przez telewizory i lodówki, aż po całe miasta – zapanowała niedawno, a sztuczna inteligencja przebojem wdarła się na czołówki gazet, pamiętać trzeba, że to dziedzina stworzona już pół wieku temu. To wtedy wymyślono samo pojęcie AI, podobnie jak trzy podstawowe formy jej wdrażania – uczenie maszynowe, sieci neuronowe oraz rozpoznawanie wzorców. Przyrost mocy obliczeniowej komputerów, a także Big Data – czyli dostęp do olbrzymich baz danych – jedynie zwiększają dokładność działania, ale do prawdziwego przełomu nie doprowadziły.

Nieudolny lekarz

Watson dla sztucznej inteligencji miał być tym, czym pierwszy krok na Księżycu dla ludzkości. Ten superkomputer IBM mierzył bardzo wysoko. W 2013 r. jego twórcy ogłosili pierwsze jego komercyjne zadanie: pomóc medykom leczyć raka. Jednak pięć lat i 62 mln dolarów później w oficjalnej opinii na jego temat lekarz z Jupiter Hospital na Florydzie napisał: „Ten program to kupa g...”. Ta opinia w zasadzie pokrywa się z oceną innych lekarzy. Ich zdaniem leczenie wedle zaleceń Watsona mogło nieść groźne, a nieraz śmiertelne skutki dla pacjentów.

Przykłady podobnych niepowodzeń związanych ze sztuczną inteligencją można mnożyć. Dość reprezentatywnym jest stworzenie botów, które tak bardzo zaangażowały się w badanie języka, że stworzyły swój własny i zajęte same sobą zerwały kontakt z otoczeniem. Albo zbudowanie przez izraelski start-up Faception aplikacji, która na podstawie zdjęć twarzy i struktury kości miała określać iloraz inteligencji, osobowość, a nawet tendencje do agresji. Abstrahując od absurdalnych założeń, że te takie cechy fizyczne mogłyby cokolwiek powiedzieć o inteligencji człowieka, sam program okazał się ekwiwalentem rasistowskiego wujka. Na początku listopada z sieci zniknęła aplikacja DeepNude, która na podstawie zwykłych zdjęć generowała fotografie tych samych ludzi, tyle że nago, i w ciałach wyłącznie kobiet, bo algorytm szkolił się na zdjęciach z sieci, a tam łatwiej znaleźć fotografie rozebranych pań.

Tego typu niepowodzenia zwykle biorą się z prostego faktu, że to, co dziś nazywamy sztuczną inteligencją, to w istocie nieco bardziej zaawansowane algorytmy rozpoznawania wzorców, zależne całkowicie od tzw. zbiorów treningowych, czyli danych, na których „uczą się” reguł. Odstępstwo od nich bywa nokautem.

„Każde zaburzenie reguł lub błąd w doborze elementów zbioru treningowego powoduje znaczące zachwianie wyników działania całości. Nowotwory nie są rozpoznawane. Każdy obywatel o ciemnej karnacji klasyfikowany jest jako przestępca. Autonomiczne samochody wypadają z drogi” – mówi Michał Jarski, członek zespołu badawczego CypherSign.

„Nie używajmy społeczeństwa do testowania technologii, co do których nie jesteśmy pewni, jak to społeczeństwo zmienią” – ostrzegała Carly Kind, dyrektorka brytyjskiego Ada Lovelace Institute, podczas sierpniowej konferencji Digital Frontrunners w Kopenhadze. Padło tam wiele przykładów projektów, które wdrożono, zanim zostały dokładnie przetestowane. Na tej samej konferencji inny badacz sztucznej inteligencji, Kristinn R. Thórisson, założyciel Icelandic Institute for Intelligent Machines, mówił: „Każdy chce być nowatorski albo doprowadzić do przełomu, od uniwersytetów przez firmy aż po rządy. Oni wszyscy myślą, że sztuczna inteligencja to kolejna wielka rzecz, ale tak naprawdę na razie mamy do czynienia ze sztuczną głupotą”.

Można się oczywiście naśmiewać z badaczy sztucznej inteligencji, którzy o spore pieniądze zakładali się, że ich programy trafnie wskażą zwycięzców mistrzostw świata w 2018 r. (spudłowali), ale to nie znaczy, że taką właśnie mocno niedoskonałą sztuczną inteligencję – podobnie jak całkiem organiczną głupotę – można lekceważyć. Flagowym przykładem jest tu Facebook. Jego niekontrolowane przez ludzi algorytmy, rozsiewając fake newsy, w ciągu zaledwie kilku lat stały się poważnym zagrożeniem dla zachodnich demokracji, doprowadziły do fałszywych oskarżeń wobec niewinnych ludzi i linczów czy – jak wskazał raport komisji powołanej przez ONZ – do ludobójstwa w Birmie.

Zmienione mózgi

W zamierzchłych czasach – czyli jeszcze ze dwie dekady temu – nie mieliśmy w zasięgu ręki gigabajtów danych. Dziś zajmuje chwilę znalezienie adresu kawiarni, w której dawno nie byliśmy, sprawdzenie, czy z pestki kupionego w supermarkecie awokado można wyhodować roślinę, albo ustalenie, jak mieli na imię bracia Wright. Kiedyś takie ciekawostki musieliśmy przechowywać we własnych głowach. Mając smartfona, teoretycznie nie musimy już tego wszystkiego pamiętać. Jest w tym jednak haczyk. Z badań publikowanych w ciągu ostatniej dekady wynika, że nowoczesne technologie to coś więcej niż wygoda, bo zmieniają sposób, w jaki myślimy, i to, jak działają nasze mózgi. A można zaryzykować stwierdzenie, że dziś każda interakcja z technologią, zwłaszcza informatyczną i komunikacyjną, to interakcja z jakąś formą sztucznej inteligencji. To algorytmy AI podsuwają nam źródła wiedzy o świecie i znajomych, selekcjonują wyniki wyszukiwania i odgadują, co mieliśmy na myśli, pytając wyszukiwarkę.

Początkowo naukowcy podchodzili do tego zagadnienia bardzo ostrożnie. Nie wyciągali pochopnych wniosków np. z obserwacji uczniów w Finlandii. W programie International Student Assessment (PISA) w 2000 r. fińskie dzieci zdobywały bardzo wysokie wyniki z matematyki i nauk ścisłych, a najlepsze na świecie były w czytaniu. Od 2006 r. przez kolejnych sześć lat ich pozycja w rankingu zaczęła jednak gwałtownie spadać, przy czym chłopcy wypadali gorzej niż dziewczęta. Trend udało się odwrócić dopiero, gdy wprowadzono ograniczenia czasu spędzanego przed ekranami (statystycznie chłopcy z komputerów i komórek korzystają częściej). Daleko idących wniosków nie wyciągano też m.in. z badań, w których udział wzięli studenci Uniwersytetu w Arkansas, gdy okazało się, że ci, którzy nie przynosili telefonów na test, mieli z niego ocenę o stopień wyższą niż ci, którzy mieli przy sobie smartfona. Podobny wynik przyniosło badanie przeprowadzone w 91 brytyjskich szkołach średnich.

Jedna z najgłośniejszych publikacji naukowych na ten temat nosi tytuł „Mózg w kieszeni: dowody na to, że smartfony są używane do wypierania myślenia”. Jej autorzy, Nathaniel Barr i Gordon Pennycook z wydziału psychologii Uniwersytetu Waterloo w Ontario, stwierdzili, że częściej na technologii polegają ludzie, którzy myślą intuicyjnie, a mniej analitycznie. Dowiedli też, że „chociaż tendencja do poszukiwania wiedzy i informacji jest czasem utożsamiana z inteligencją, większe zdolności poznawcze wiązały się z rzadszym używaniem smartfona i wyszukiwarek internetowych”. Nicholas Carr, badacz społeczeństwa sieci, autor książki „Płytki umysł. Jak internet wpływa na nasze mózgi”, ujął to tak: „Jeśli zawsze czerpiesz fakty z Google’a, możesz odpowiedzieć na pytania, ale nie zbudujesz bazy wiedzy niezbędnej do głębokich i rozważnych przemyśleń”.

W ostatnich latach dowiedziono nie tylko, że inaczej myślimy niż w czasach przed masowym pojawieniem się algorytmów, ale też że nowoczesne technologie „hamują rozwój bliskości interpersonalnej i zaufania ” oraz zmniejszają „stopień, w jakim jednostki odczuwają empatię”. To jednak jeszcze nie koniec. Już 12 lat temu prof. Gary Small z Uniwersytetu Kalifornijskiego w Los Angeles dowiódł, że w mózgach osób regularnie korzystających z internetu powstają nowe ścieżki neuronalne. Natychmiast pojawiły się nagłówki, że korzystając z sieci stajemy się coraz inteligentniejsi. Problem w tym, że ciągłe rozpraszanie uwagi wywołane surfowaniem między różnymi źródłami informacji – co również prof. Small przebadał – osłabia przednią część kory mózgowej, rejon zaangażowany w przetwarzanie informacji i emocji na wysokim poziomie.

Dziś, dzięki najnowszym badaniom, wiemy, że to nie jedyny obszar mózgu, który się zmienia. Na przykład poleganie na telefonie lub internecie podczas przemieszczania się wpływa na aktywność i objętość szarej materii hipokampu, obszaru mózgu ważnego dla nawigowania w środowisku oraz konsolidacji pamięci krótkotrwałej do pamięci długotrwałej.

Skutki długoterminowe

Sztuczna inteligencja jest, albo przynajmniej ma być, motorem napędowym wszystkich nowych technologii. Założenie jest takie, że ma nas uwolnić od tych wszystkich drobnych, uciążliwych myśli i decyzji. Możliwe, że dzięki temu będziemy mieli czas do głębszych przemyśleń i stanie się ona dobrodziejstwem. Tylko czy rzeczywiście wszystkie zadania, które przekazujemy sztucznej inteligencji, są trywialne? I po drugie: czy słuszne jest założenie, że zrobimy coś ważniejszego w wolnym czasie?

Czytaj także: Zapytaliśmy sztuczną inteligencję, kto będzie autorem artykułu napisanego przez AI?

„Ludzie mają tendencje do przeceniania krótkoterminowych skutków technologii i niedoceniania jej skutków długoterminowych” – to słowa Roya Amary, współzałożyciela słynnego Institute for the Future w Palo Alto. W problemie z przewidzeniem możliwego wpływu wynalazków na człowieka i społeczeństwo nie ma jednak nic nowego. Już Sokrates ponoć uważał, że książki doprowadzą do epidemii zapominania. 2 tysiące lat później ówczesnych arystokratów o bezsenność przyprawiał problem mentalnego przeciążenia mas z powodu wynalezienia maszyny drukarskiej. Podobne obawy wywoływało upowszechnienie się map – miały spowodować, że ludzie stracą orientację przestrzenną. Zresztą nie trzeba sięgać aż tak daleko. Wystarczy sobie przypomnieć argumenty, których używano, gdy chcieliśmy w szkole zamiast uczyć się tabliczki mnożenia używać kalkulatorów. Warto może samemu sobie odpowiedzieć, w jakim stopniu dziś polegamy na wpojonej nam wówczas wiedzy, a w jakim na aplikacjach, które każdy ma w komputerze czy telefonie, i do jak skomplikowanych obliczeń ich używa.

Zajmujący się nowymi technologiami Markham Heid z tygodnika „Time” skutki wykorzystania sztucznej inteligencji porównuje do korzystania z samochodu zamiast nóg. Teoretycznie przemieszczanie się jest łatwiejsze i szybsze, ale jednocześnie więcej czasu spędzamy siedząc, a to ma swoje – nie zawsze korzystne – skutki dla naszego ciała.

Andrzej Zybertowicz z Uniwersytetu Mikołaja Kopernika w Toruniu w kontekście prognoz związanych z nowymi technologiami używa plastycznego porównania do siekiery: wcześniej mieliśmy kontrolę nad narzędziami, które wytworzyliśmy, i choć sami mogliśmy sobie zrobić nimi krzywdę, źle ich używając, to jednak żadne z nich nie było potężniejsze od człowieka. Nowe technologie odwracają jednak tę relację i teraz to człowiek zaczyna być przez nie zniewalany. Jak bardzo? Internet od lat 90. zmienił świat, jednak za tą przemianą nie stali wielcy myśliciele naszych czasów, demokratyczne społeczeństwa czy choćby politycy, lecz inżynierowie i informatycy, których – w zdecydowanej większości – nazwisk nawet nie znamy. „Czy głosowaliście kiedykolwiek w sprawie internetu?” – pyta Yuval N. Harari w książce „21 lekcji na XXI wiek”, dodając: „System demokratyczny wciąż usiłuje pojąć, co się stało; nie jest przygotowany na kolejne wstrząsy, czy na przykład na pojawienie się sztucznej inteligencji i nadejście rewolucji, jaką jest blockchain”.

Dziś założenie jest takie, że sztuczna inteligencja ma nam ułatwiać życie, ale bez względu na to, jak na razie jest głupia, czy pewnego dnia te role mogą się odwrócić? Gdy sztuczna inteligencja osiągnie już dostatecznie wysoki poziom, czy możliwe jest, że zacznie manipulować nami po to, byśmy to my uzupełniali jej niedoskonałości? I co wtedy? Nie damy się jej, tak po prostu? A czy dziś umielibyśmy z dnia na dzień wyłączyć komputery i funkcjonować bez nich? Google, jako panaceum na uzależnienie od smartfona, zaproponował ostatnio wydrukowanie sobie jego odpowiednika w postaci książeczki, żeby odciąć się od prawdziwego urządzenia choćby na parę godzin. Nie wyjaśnia tylko, jak te kilka godzin cyfrowego detoksu miałyby poprawić stan już nieco upośledzonego hipokampu.

Przebudzenie

To może być dopiero początek, bo jeśli idzie o sztuczną inteligencję – używając metafory Kasparowa – mamy zaledwie MS-DOS, choć bardzo pragniemy Windowsa. Istnieje jednak zasadnicza różnica między wszystkimi dotychczasowymi wynalazkami a sztuczną inteligencją. Gdy wreszcie nam dorówna, będzie ostatnim, co wynajdzie ludzkość, bo samodoskonalące się maszyny nie będą nas już do doskonalenia siebie potrzebowały. Co najwyżej może będziemy mogli je w jakimś stopniu uzupełniać. Kiedy sztuczna inteligencja osiągnie taki poziom i czy w ogóle kiedykolwiek do tego dojdzie, jest kwestią poważnych sporów wśród badaczy i współczesnych filozofów.

W tym kontekście do myślenia dają jednak argumenty Harariego, że organizmy to w zasadzie algorytmy, a każde zwierzę – w tym także człowiek – jest nagromadzeniem organicznych algorytmów ukształtowanych przez dobór naturalny w ciągu milionów lat ewolucji. Na obliczenia nie ma jednak wpływu rodzaj materiału, z jakiego zbudowany jest kalkulator, bo bez względu na to, czy liczydło jest drewniane, metalowe, czy plastikowe, dwa plus dwa zawsze da wynik cztery. „Nie ma zatem powodu uznawać, że organiczne algorytmy potrafią robić rzeczy, których nieorganiczne nigdy nie będą w stanie naśladować lub przewyższyć”. Podobnego zdania jest Nick Bostrom, szwedzki matematyk i filozof, autor książki „Superinteligencja”, choć on ujmuje to tak: „Neuron wysyła impuls z częstotliwością dwustu herców dwieście razy na sekundę. Dzisiejsze tranzystory operują w gigahercach. Informacja podróżuje przez akson najwyżej 100 metrów na sekundę, podczas gdy w komputerach sygnał może poruszać się z prędkością światła. Istnieją też limity wielkości: ludzki mózg musi zmieścić się w czaszce, komputer może być jak hala fabryczna albo jeszcze większy. Potencjał superinteligencji jest więc uśpiony, tak jak moc atomu, która była uśpiona od początku ludzkości, cierpliwie czekając na przebudzenie w 1945 r.”. Kiedy dojdzie do „przebudzenia” w tym przypadku, nie wiadomo. „Nie ma jednak żadnego niepodważalnego argumentu, że do tego nie dojdzie” – twierdzi Max Tegmark, profesor fizyki w MIT i autor bestsellerowej książki „Życie 3.0”.

Wszystko wskazuje na to, że sztuczna inteligencja, nawet jeśli jeszcze długo nie osiągnie równego nam poziomu ani nie pojawi się jej świadomość, nie będzie pierwszym wynalazkiem, który niepostrzeżenie zmieni dosłownie wszystko. Początków zegarów mechanicznych należy szukać w XII i XIII w. w klasztorach benedyktyńskich. Miały pomóc w regulowaniu rutyny, do której należała modlitwa siedem razy dziennie, ale – jak pisze Neil Postman w swoim słynnym „Technopolu” – „mnisi nie przewidzieli, że zegar stanie się nie tylko narzędziem do mierzenia upływu godzin, lecz także do kontrolowania i synchronizowania działań ludzi. Tak więc już w połowie XIV w. zegar opuścił mury klasztorne, by wnieść nową i precyzyjną regularność w życie robotników i kupców (...) Paradoks, zaskoczenie i cud polegają na tym, że wymyślili go ludzie, którzy chcieli bardziej rygorystycznie poświęcić się Bogu, a ostatecznie stał się on technologią najużyteczniejszą dla tych, którzy chcą się poświęcać akumulacji pieniądza. W wiecznej walce między Bogiem a Mamoną zegar, dość nieoczekiwanie, stanął po stronie tej ostatniej”.

Jedna z wielkich debat naszych czasów dotyczy tego, czy umiemy stworzyć sztuczną inteligencję w taki sposób, by nie doprowadzić do zagłady naszego gatunku. I tu też nie ma żadnych jednoznacznych odpowiedzi. Na razie pewne jest, że już dziś sztuczna inteligencja, choć wciąż może nie jest tak inteligentna, jak byśmy sobie tego życzyli, zaczyna wpływać na to, jak działają nasze społeczeństwa i mózgi. To rodzi pytania, na które odpowiedzi raczej nie da się znaleźć w internetowej wyszukiwarce. ©

Autorzy są dziennikarzami Polsat News, stale współpracują z „Tygodnikiem”.

SPEKTAKULARNE PORAŻKI

AUTONOMICZNY DROGOWY ZABÓJCA W marcu 2018 r. po raz pierwszy kierowany przez sztuczną inteligencję pojazd (na zdjęciu) zabił przechodnia.

49-letnia Elaine Herzberg nocą przeprowadzała rower przez drogę w Tempe w Arizonie. Testowane przez firmę Uber autonomiczne auto uderzyło w kobietę z prędkością 62 km na godzinę. Śledztwo amerykańskiej Narodowej Rady Bezpieczeństwa Transportu wykazało, że czujniki auta zarejestrowały obecność Herzberg ponad pięć sekund przed uderzeniem, ale komputer nie zainicjował hamowania. Sterujący autem kod nie uwzględniał tego, że piesi mogą przechodzić przez jezdnię w niedozwolonym miejscu.

SEKSISTOWSKI ALGORYTM Amazon od 2014 r. budował narzędzia wykorzystujące sztuczną inteligencję do wspomagania procesu rekrutacji. Rok temu po cichu z nich zrezygnował. Powód? Oprogramowanie przyznawało potencjalnym kandydatom od jednej do pięciu gwiazdek. Kobiety dostawały ich z założenia mniej, bo algorytm wyszkolono na podstawie bazy CV nadesłanych do firmy na przestrzeni poprzedniej dekady. W branży technologicznej większość z tych CV nadesłali mężczyźni. Program uznał więc, że to oni są preferowanymi kandydatami.

ZIDENTYFIKOWANI W KONGRESIE Amazon jest też autorem jednego z najpowszechniej stosowanych systemów do rozpoznawania twarzy. Jego twórcy twierdzą, że jest w stanie rozpoznać nawet 100 osób na jednym zdjęciu i je zidentyfikować czy śledzić na żywo za pośrednictwem kamer monitoringu. System przetestowała Amerykańska Unia Swobód Obywatelskich. Porównując zdjęcia członków Izby Reprezentantów i Senatu z bazą danych zawierającą 25 tys. zdjęć zatrzymanych, system błędnie zidentyfikował trzech senatorów i 25 kongresmenów jako notowanych przestępców. Wykazał się przy okazji rasizmem. O ile przedstawiciele ras innych niż biała stanowią 20 proc. członków Kongresu, w puli „przestępców” stanowili 39 proc. © AK, WB

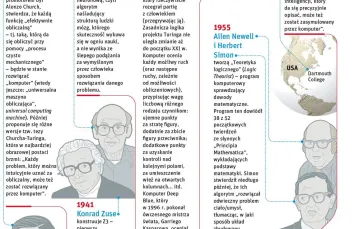

KALENDARIUM INTELIGENTNYCH MASZYN

IV w. p.n.e. – Nieznany malarz maluje na ceramicznym kraterze śmierć Talosa. Wedle mitu zbudowany z brązu olbrzym miał strzec Krety przed obcokrajowcami. Talosa można więc uznać za pierwsze wyobrażenie autonomicznego systemu uzbrojenia.

Ok. 60 r. n.e. – Heron z Aleksandrii tworzy pierwsze programowalne maszyny, takie jak napędzany ciężarkiem na sznurku wózek. Ich zdolność reagowania na otoczenie była jednak ograniczona, bo program zapisany był w formie sznurków owiniętych wokół osi wózka.

1580 – Wedle legendy rabin Jehuda Löw ben Becalel tworzy golema, czyli glinianego człowieka pozbawionego duszy, by ten chronił mieszkańców dzielnicy żydowskiej w Pradze.

1921 – W sztuce „Roboty uniwersalne Rossuma” Karla Čapka pojawia się po raz pierwszy słowo „robot”.

1942 – Isaac Asimov publikuje opowiadanie „Zabawa w berka”, w którym przedstawia stworzone przez siebie trzy prawa robotyki:

Robot nie może skrzywdzić człowieka ani przez zaniechanie działania dopuścić, aby człowiek doznał krzywdy.

Robot musi być posłuszny rozkazom człowieka, chyba że stoją one w sprzeczności z Pierwszym Prawem.

Robot musi chronić samego siebie, o ile tylko nie stoi to w sprzeczności z Pierwszym lub Drugim Prawem.

1943 – Matematyk Alan Turing (na zdjęciu) i neurolog Grey Walter zakładają Ratio Club, nieformalny klub dyskusyjny skupiający psychologów, inżynierów, matematyków i psychiatrów zafascynowanych cybernetyką. Walter tworzy pierwsze autonomiczne mobilne roboty.

1950 – Turing publikuje pracę naukową „Maszyneria obliczeniowa i inteligencja”, jedną z pierwszych poświęconych temu, co dziś nazywamy sztuczną inteligencją. Opisuje test, później nazwany od jego nazwiska, w którym maszynę można uznać za inteligentną, kiedy jej rozmówca nie potrafi odróżnić jej od człowieka.

1951 – Marvin Minsky buduje pierwszą stochastyczną sieć neuronową SNARC.

1954 – Pentagon finansuje badania nad automatycznym tłumaczeniem z rosyjskiego. Prace, oparte na teoriach Noama Chomsky’ego, początkowo szły nieźle, ale szybko wieloznaczność języka zaczyna nastręczać coraz poważniejszych problemów. Wedle anegdoty zdanie „duch jest chętny, lecz ciało słabe” miało zostać przetłumaczone przez system na „wódka jest dobra, ale mięso zgniłe”.

1956 – Konferencja w Dartmouth, uznawana za formalny początek badań nad sztuczną inteligencją.

1958 – General Motors instaluje w fabryce pierwszego prototypowego robota przemysłowego Unimate.

1958 – Frank Rosenblatt buduje Perceptron, pierwszą uczącą się maszynę do rozpoznawania obrazu, w tym przypadku znaków alfanumerycznych. Kolejne generacje mają „widzieć, słyszeć, uczyć się, rozmnażać i staną się świadome swojego istnienia”.

1964 – Narodowa Rada Badawcza USA powołuje Komitet Doradczy ds. Automatycznego Przetwarzania Języka. Na stworzenie komputerowego tłumacza dostaje budżet 20 mln dol. Dwa lata później Komitet opublikował raport, w którym stwierdza, że tłumaczenia maszynowe są droższe, wolniejsze i gorsze od wykonywanych przez ludzi. Ta klęska miała być jedną z głównych przyczyn, dla których kolejna dekada bywa nazywana „zimą sztucznej inteligencji”.

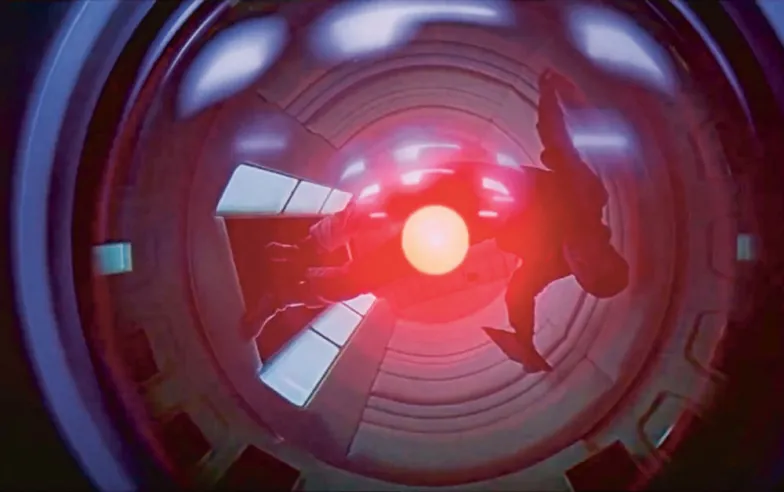

1968 – Premiera filmu „2001: Odyseja kosmiczna” wraz z jego czarnym charakterem: inteligentnym komputerem HAL 9000.

1969 – Autonomiczny robot Shakey, sterowany komputerem zajmującym spore pomieszczenie, bardzo powoli porusza się po prostym torze przeszkód.

1972 – PARRY, zbudowany na Uniwersytecie Stanforda czatbot, symuluje osobę chorą na schizofrenię paranoidalną.

1973 – Prof. James Lighthill publikuje miażdżący raport o sztucznej inteligencji, wedle którego żaden komputer nie zagra w szachy na poziomie przewyższającym „utalentowanego amatora”.

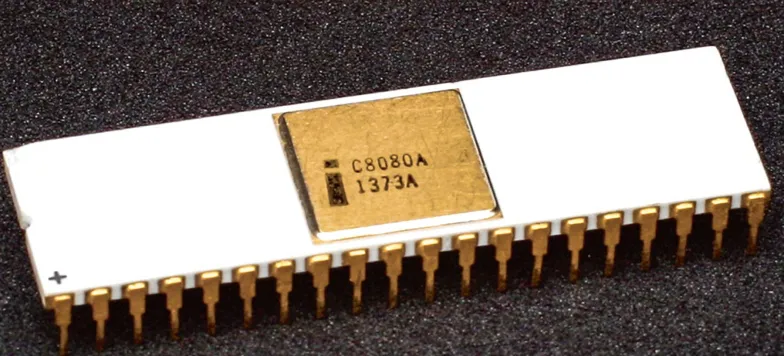

1974 – Intel wypuszcza na rynek chip 8080, pierwszy produkowany na masową skalę mikroprocesor.

1997 – Deep Blue pokonuje w meczu szachowym Garriego Kasparowa.

1998 – powstaje Google.

2000 – ONZ szacuje, że na świecie jest 742 tys. robotów przemysłowych.

2005 – Zbudowany na Uniwersytecie Stanforda samochód Stanley jedzie w trybie autonomicznym przez 131 minut.

2006 – Google udostępnia usługę Translate, początkowo oferując wyłącznie tłumaczenia angielsko-arabskie. Dziś tłumacz wyszkolony na transkryptach posiedzeń ONZ i Parlamentu Europejskiego obejmuje 104 języki.

2011 – Apple udostępnia Siri, pierwszego inteligentnego asystenta głosowego.

2017 – AlphaGo wygrywa z Ke Jie, numerem jeden w światowym rankingu graczy w go. Na zdjęciu ruchy 200-289 pierwszej partii. ©

AK, WB