Wykupienie dostępu pozwoli Ci czytać artykuły wysokiej jakości i wspierać niezależne dziennikarstwo w wymagających dla wydawców czasach. Rośnij z nami! Pełna oferta →

Redakcja mogłaby mnie podpisać jako filozofa i kognitywistę, ale jestem też tłumaczem. Przekładałem różne teksty: instrukcje obsługi, artykuły na temat programowania, pomoc ekranową, komunikaty na ekranach telefonów. Zebrało się też kilkanaście książek. Dobre dziesięć lat temu napisałem nawet słownik terminologii informatycznej i telekomunikacyjnej, wydany nakładem C.H. Beck.

Kiedy zaczynałem pracę w tym zawodzie, tłumaczenie maszynowe było pośmiewiskiem. Nikt nie używał go na poważnie. W branży technicznej panują dosyć wyśrubowane standardy, jeśli chodzi o spójność stylistyczną i terminologiczną. Dlatego od lat stosuje się specjalne oprogramowanie wspomagające, tzw. pamięć tłumaczeń, bez którego dochodzi do pomieszania z poplątaniem. Kiedy np. zespół tłumaczy – może być ich nawet setka – przygotowuje polską wersję systemu Windows, wszyscy muszą ściśle przestrzegać zaleceń stylistycznych i stosować te same terminy. Inaczej użytkownik będzie zdezorientowany. Przykład: kiedyś poproszono mnie o uzupełnienie tłumaczenia paru stron instrukcji nowej wersji pewnej drukarki. Okazało się, że komunikaty sterownika drukarki dla systemu Windows, a więc wyświetlające się użytkownikowi na ekranie komputera, tłumaczyła jedna firma, a komunikaty ukazujące się na wyświetlaczu drukarki – inna. Z inną terminologią. A potem trudno się zorientować, czy „taca na papier” jest tym samym, co „pojemnik dolny”.

Jeszcze na początku XXI w. myśleliśmy, że daleka droga do tego, by tłumaczenie maszynowe zastąpiło tłumacza. Lecz już kilka lat później, zamiast przekładać rzeczywiście dosyć nudnawe i powtarzalne frazy od zera, zaczęliśmy korzystać z tłumaczenia maszynowego, a nie tylko komputerowego wspomagania. Zadaniem tłumacza-człowieka jest wówczas tzw. postedycja, czyli redagowanie wyniku pracy maszyny. Korzystając ze wstępnie podtłumaczonego tekstu, mogłem znacznie szybciej, a chyba i lepiej przetłumaczyć książkę Davida Chalmersa „Świadomy umysł”, co pokazuje, że te systemy nie ograniczają się do instrukcji obsługi, ale mogą też poradzić sobie z filozofią. Dziś praktycznie nie wyobrażam sobie pracy tłumacza bez pomocy automatów.

Jak do tego doszło? I czy tłumaczy zupełnie zastąpią maszyny?

Marzenie o regułach

Idea, żeby zmechanizować tłumaczenie za pomocą komputerów cyfrowych, zrodziła się bardzo szybko, praktycznie jednocześnie z ideą sztucznej inteligencji. Nic dziwnego. W czasach zimnej wojny oba mocarstwa chciały jak najszybciej wiedzieć, co zawierają dokumenty przeciwnika. W takim przypadku nie jest ważna idealna jakość literacka, lecz zgrubne odtworzenie sensu przejętej depeszy.

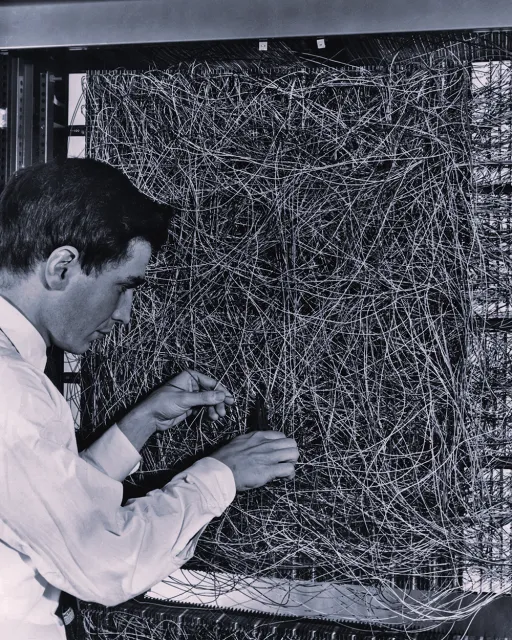

Pierwsze próby stworzenia takich systemów pojawiły się w czasie, kiedy Noam Chomsky rozpoczynał rewolucję w językoznawstwie. Pomysł był prosty: należy odpowiednio ujawnić strukturę zdania oryginału, przeprowadzając analizę składniową i znaczeniową, a następnie, za pomocą odpowiednich reguł, wygenerować odpowiednie struktury w języku docelowym. Realizacja tego pomysłu jest jednak niesłychanie pracochłonna, gdyż wymaga nie tylko ogromnych słowników dwujęzycznych, ale także żmudnej pracy lingwistów nad opracowywaniem takich reguł.

Postępy były na tyle powolne, że opracowany w 1966 r. raport ALPAC dotyczący dotychczasowego rozwoju tłumaczenia automatycznego w USA doprowadził do wstrzymania dużych i kosztownych projektów, nieprzynoszących większych efektów. Ten i podobne krytyczne raporty, które ukazały się na przełomie lat 60. i 70., na długie lata spowolniły rozwój sztucznej inteligencji jako takiej – do tego stopnia, że drugą połowę lat 70. określa się czasem jako „zimę AI” (AI winter). Prace trwały jednak w obozie „demokracji ludowej” oraz w Niemczech i Francji. Wyjątkiem był system Systran, opracowywany w USA od kilkudziesięciu lat.

Znacznie już później, po zakończeniu zimnej wojny, powstał w Polsce system oparty na podobnych zasadach: Poleng, później nazwany Translaticą. Został opracowany przez specjalistów z Poznania, związanych z Uniwersytetem Adama Mickiewicza, pod kierownictwem prof. Krzysztofa Jassema. Stale rozwijana Translatica, korzystająca z dużego i bardzo dobrego słownika oraz reguł przetwarzania angielszczyzny, jest dziś w stanie analizować stosunkowo skomplikowane zdania.

Problem z tym podejściem polega na tym, że dla każdej pary języków, pomiędzy którymi mielibyśmy przekładać, trzeba by przygotowywać osobny system. Lingwiści zaproponowali więc, aby opracowywać reguły tłumaczenia na język pośredni, zwany „interlinguą”. W ten sposób można byłoby mieć pewien zasób reguł wspólnych, a tłumaczenie pomiędzy dowolnymi dwoma wybranymi językami dokonywałoby się za pośrednictwem interlinguy.

To jednak nie takie podejście doprowadziło do rewolucji w tłumaczeniu. Powód był bardzo prosty: zbudowanie takiego systemu jest kosztowniejsze niż zatrudnienie tłumaczy, zwłaszcza korzystających ze wsparcia pamięci tłumaczeń. Istnieją jednak cały czas rozwijane systemy regułowe, także wolnodostępne, jak Apertium, obsługujące 49 par języków. Z ciekawostek: Apertium tłumaczy między polszczyzną a gwarą śląską.

Statystyka na odsiecz

Już Warren Weaver, jeden z twórców teorii informacji, w 1949 r. proponował, aby tłumaczenie oprzeć na statystycznej analizie języka. Pomysł jest prosty: wystarczy wyznaczyć odpowiednie rozkłady prawdopodobieństw, że dla pewnego ciągu znaków oryginału jego przekładem jest inny ciąg znaków, a potem z tych rozkładów korzystać. Łatwiej jednak powiedzieć niż zrobić, kiedy pamięć komputerów mierzy się w kilku bajtach – i dopiero z pojawieniem się internetu można było tanio zdobyć duże zasoby tekstowe potrzebne do tej analizy.

Początkowo analizowano współwystępowanie pojedynczych wyrazów oryginału i tłumaczenia, ale każdy, kto próbował tłumaczyć słowo po słowie, wie, dlaczego nie tędy droga. Słowa są wieloznaczne. A najczęstsze słowa są najbardziej wieloznaczne (to głosi tzw. prawo Zipfa). Znany przykład obrazujący trudność stworzył logik Jehoszua Bar-Hillel. W 1960 r. dowodził, że nie ma szans na zbudowanie systemu tłumaczącego proste angielskie zdanie „The box was in the pen”, gdyż składa się ono z samych wieloznacznych wyrazów. Nawet dzisiaj niektóre systemy tłumaczące, np. Tłumacz Google, dają wynik dosyć nonsensowny („Pudełko było w piórze”, zamiast poprawnego „Pudełko było w kojcu” – jest to fragment opowieści o Jasiu szukającym pudełka z zabawkami).

Twórcy systemów statystycznych zaczęli na początku XXI w. radzić sobie z tym problemem w inny sposób. Budowali modele języka docelowego wskazujące, z jakim prawdopodobieństwem pewne wyrazy będą występować obok siebie. Można więc zbudować model złożony z pojedynczych wyrazów (co w sumie nie będzie odbiegać od ich częstości), ich par, trójek, czwórek itd. Im dłuższe te ciągi, tym kosztowniejsze obliczeniowo, ale także trafniejsze będzie tłumaczenie. Metoda opracowana w 1993 r. przez specjalistów z IBM zdominowała przekład automatyczny na dobre 20 lat.

Jak takie modele budować? Okazuje się to bardzo łatwe, kiedy istnieje internet. W sieci znajduje się coraz więcej tekstu, a że w bazie danych nie przechowujemy całego tekstu, lecz tylko grupy słów i pewne parametry statystyczne, nie ma problemu z prawami autorskimi. Nic dziwnego, że potentatami okazali się producenci wyszukiwarek internetowych. W końcu to oni mieli dostęp do ogromnych zasobów tekstowych.

Stworzenie systemu tłumaczenia okazało się tanie i szybkie, ograniczone tylko szybkością komputerów, a wyniki były wystarczająco dobre, aby przyspieszały pracę tłumaczy. Choćby nawet pozostawały błędy, to poprawienie kilku końcówek wyrazów czy paru błędnych słów zabiera mniej czasu niż napisanie zdania od zera. Pojawiły się wkrótce narzędzia pozwalające stworzyć własne statystyczne systemy tłumaczenia, korzystające zwykle z będącego w wolnym dostępie systemu Moses. Wystarczy tylko mieć duże powiązane ze sobą zbiory oryginałów i tłumaczeń, zwane „korpusami równoległymi”. Skąd jednak je wziąć?

Okazuje się, że nic prostszego. Europejskie instytucje tłumaczą ulotki produktów medycznych, można więc stworzyć wielojęzyczne korpusy medyczne. Tłumacze unijni tłumaczą wszystkie dokumenty na wszystkie języki oficjalne. Instytucje religijne tłumaczą i udostępniają swoje teksty, zwłaszcza Biblię i Koran. Wreszcie amatorzy tłumaczą podpisy do filmów, a biura tłumaczeń czy wielkie firmy gromadzą własne zasoby z poprzednich projektów.

Od typu tekstu i jego problematyki zależy, czy wybrany korpus równoległy pozwoli stworzyć system dający rozsądne wyniki. Kiedy wytrenowałem Mosesa na ulotkach medycznych i poprosiłem go o przetłumaczenie tytułu piosenki Elvisa „Are You Lonesome Tonight”, program zaproponował tłumaczenie: „Są pacjentki odludny wieczór”. Gdybym użył korpusu biblijnego do tłumaczenia ulotek medycznych, efekt byłby zapewne jeszcze bardziej zaskakujący.

Statystyczne tłumaczenie maszynowe znalazło zastosowania praktyczne, jednak trudno było nie dostrzec niedoskonałości jego rezultatów. Ze względu na to, że propozycja przekładu powstaje na podstawie sposobu użycia danych słów w zadanych tekstach „wzorcowych”, system taki nie jest w stanie poradzić sobie choćby z twórczym charakterem języka.

Kłopoty z produktywnością

To właśnie twórczość czy też produktywność języka sprawia, że statystyczne uczenie maszynowe musi być niedoskonałe. Każdy z nas jest w stanie zrozumieć i wytworzyć potencjalnie nieskończoną liczbę zdań. Co więcej, prawie żadne pisane przez nas zdanie, które nie jest po prostu cytatem lub formułą grzecznościową, nie było napisane przez nikogo wcześniej. A niektóre kombinacje wyrazów, chociaż całkowicie poprawne, po prostu nigdy wcześniej się nie pojawiły.

Przypuśćmy, że w tego typu nowej kombinacji pojawiło się słowo „nie”. System tłumaczący może nie mieć w swoich zbiorach danych podobnego tekstu z negacją, uzna więc, że niskie jest prawdopodobieństwo wystąpienia w tym miejscu „nie”. Dostaniemy w ten sposób zdanie będące logicznym zaprzeczeniem oryginału. Podobne osobliwości znają użytkownicy tłumaczenia statystycznego: niekiedy tłumaczy ono symbole miar czy walut, nie przeliczając wartości, a 36,6 stopni Celsjusza to nie to samo, co 36,6 stopni Fahrenheita, 15 złotych zaś to nie to samo, co 15 euro. Co więcej, w naszym języku bardzo łatwo tworzyć neologizmy, np. „mechanotłumacz”. Czegoś takiego tradycyjne statystyczne metody nie potrafią zanalizować.

W systemie Moses rozpoczęto więc próby wzbogacenia metod statystycznych przez analizę gramatyczną. I nic. Większość wyników była jeszcze gorsza. Wydawało się, że pozostaje jedynie połączyć jakieś elementarne reguły (np. sprawdzające, czy nie nastąpiło przekłamanie przy tłumaczeniu oznaczeń miar i walut) z tłumaczeniem statystycznym. Tymczasem w firmie Google trwały eksperymenty nad zastosowaniem uczenia głębokiego w tłumaczeniu.

Głębiej i głębiej

Od lat 80. XX w. trwa renesans innego podejścia do sztucznej inteligencji: sztucznych sieci neuronowych. Początki sięgają pierwszego obliczeniowego modelu mózgu Warrena McCullocha i Waltera Pittsa z 1943 r., którzy założyli, że neurony odpowiadają operacjom logicznym: negacji, alternatywie czy koniunkcji. Są to zatem bramki logiczne. McCulloch i Pitts dowiedli przy tym, że z takich bramek można stworzyć maszynę realizującą wszelkie obliczalne funkcje matematyczne. Jednak ich neurony były cyfrowe i niezmienne, a dopiero kolejny model – perce- ptron – opracowany przez Franka Rosenblatta w 1957 r. można było uczyć. W dodatku nie był on cyfrowy, lecz analogowy – było to urządzenie mechaniczno-elektroniczne, które zaopatrzono w potencjometr z gałką, którą w sposób ciągły przesuwał mały silniczek. Od ustawienia tego potencjometru zależała wartość wyjściowa przy danych wartościach na wejściu. Początkowo sądzono, że to klucz do sztucznej inteligencji, ale, czego dowiódł w 1969 r. Marvin Minsky (szkolny kolega Rosenblatta) wraz z Sey- mourem Papertem (późniejszym twórcą dydaktycznego języka programowania Logo), perceptrony nie były tak uniwersalne jak model McCullocha i Pittsa. Przeciwnie, nie mogły nawet nauczyć się wszelkich funkcji logicznych.

Na wiele lat zapanował wspomniany już wyżej zastój w badaniach nad sztucznymi sieciami neuronowymi, który przełamał u zarania lat 80. Geoffrey Hinton, pracujący obecnie dla Google. To on stworzył podwaliny koneksjonizmu: modelowania procesów uczenia przez sztuczne sieci neuronowe. W ostatnich latach zaś nowe metody uczenia takich sieci pozwoliły znacznie poprawić wyniki w zakresie rozpoznawania wzorców, w tym obrazów, tekstu drukowanego, mowy, ale także generowania sztucznej mowy czy tworzenia zdjęć fikcyjnych ludzkich twarzy, a nawet filmów z twarzami znanych osób [zob. artykuł Wojciecha Brzezińskiego na str. 119 – red.]. Musiało więc pojawić się pytanie, czy nie dałoby się tych metod zastosować do tłumaczenia maszynowego.

Sieci neuronowe, chociaż inspirowane do pewnego stopnia biologicznie, były jeszcze na początku XXI w. traktowane przez praktyków od przetwarzania języka jako stosunkowo nieinteresująca, a ponadto wolniejsza forma uczenia maszynowego. Uczenie maszynowe polega wszak właśnie na wydobywaniu wzorców z danych. Nowsze algorytmy tworzenia takich sieci i większa dostępność danych do uczenia pozwoliły jednak uzyskać bezprecedensowe rezultaty.

Chociaż wyuczenie sztucznej sieci potrafi nadal być czasochłonne, to zwykle się opłaca. Sztuczne sieci neuronowe nadają się zwykle bardzo dobrze do wykrywania skomplikowanych wzorców, a więc uczą się rozpoznawać strukturę. Struktura ta może być stosunkowo bogata, dlatego w przypadku współczesnych sieci mówi się o uczeniu głębokim, gdyż głęboko analizują one strukturę wzorców. A język taką strukturę przecież ma.

Poza wykorzystaniem specjalnego sprzętu (tzw. procesorów tensorowych) opracowanych w Google równie istotnym pomysłem była rezygnacja z tradycyjnego podejścia do tekstu. Tekst do tłumaczenia statystycznego jest odpowiednio przygotowywany: cały tekst przerabia się na pisany małymi literami (wielkie litery przywraca się w modelu języka docelowego), dzieli się go na zdania, a następnie na poszczególne wyrazy, zwykle zgodnie z zasadami ortografii danego języka. Rzecz w tym, że granice słów w języku pisanym bywają arbitralne, co mogą potwierdzić na pewno wszyscy ci, którzy zmagali się z pisownią łączną lub rozłączną w języku polskim. Końcówki typu „-bym” potrafią przyczepić się do wielu różnych części mowy, a w dodatku czasem pisze się je łącznie, a czasem osobno. Nigdy jednak nie mają one samodzielnego znaczenia. Tłumacz Google postępuje więc inaczej: słowa nie są dzielone na podstawie znaków interpunkcyjnych i spacji, lecz podlegają dalszym podziałom.

Kilka eksperymentów wystarczy, by się przekonać, że Tłumacz poradzi sobie nawet z niektórymi neologizmami. Zdanie „To jest mechanotłumacz języka polskiego” tłumaczy jako „This is the mechanotranslation of the Polish language”. Trudno wyobrazić sobie lepszy wynik, co potwierdzają też dane z ewaluacji nowego systemu. Dzięki niemu wyniki w zakresie tłumaczenia pojedynczych zdań poprawiły się – w ocenie przeprowadzanej przez ludzi – o 60 proc. w stosunku do poprzedniego systemu tłumaczenia, a to wynik wręcz niesłychany, gdyż osiągnięto go wyjątkowo szybko. Dlatego też nowy system został wdrożony niemal błyskawicznie dla większości obsługiwanych przez Google języków.

Co dalej?

Jeszcze 20 lat temu byłem przekonany, że tłumacz techniczny to świetny zawód, bo metody komputerowe to zabawki. Dzisiaj już nie są zabawkowe. Wiele tekstów, wcześniej przekładanych przez człowieka, tłumaczy maszyna. Dotyczy to chociażby rzadziej używanych informacji technicznych – np. Tłumacz Bing służy w firmie Microsoft do tłumaczenia jej Bazy Wiedzy dla użytkowników (jest to oznaczone na stronach internetowych w stopce). Chińskie sklepy tak generują polskie opisy swoich produktów. Nie są one może idealne, ale wystarczająco dobre, aby ktoś na ich podstawie kupił towar – a nie zapominajmy, że funkcją wielu, jeśli nie większości tekstów nie jest wcale wywoływanie zachwytu estetycznego, lecz czysto pragmatyczny przekaz informacji.

Trwają intensywne prace nad dostosowaniem tłumaczenia maszynowego do rozpoznawania mowy. Coś, co niedawno było domeną fantastyki naukowej – automatyczne tłumaczenie zupełnie nieznanego języka na żywo – jest już rzeczywistością i każdy z nas może ściągnąć aplikację na swój telefon, która jest to w stanie zrobić, z jakością zależącą głównie od tego, jaką parę języków wybierzemy. Mowa jest wyjątkowo trudna nie tylko ze względu na wielość akcentów i błędy wymowy, ale również dlatego, że problematyczne jest samo wyodrębnianie rozmowy z tła. My, ludzie, bez trudu rozpoznajemy głos swojego rozmówcy w głośnej kawiarni i skupiamy się tylko na jego słowach, nawet kiedy rozmawiamy w większej grupie. Automatyczne systemy wciąż mają z tym problem. Nadal nie wiadomo też, jak właściwie ten kłopot rozwiązuje nasz mózg. Wiadomo, że w audycji radiowej jest to większy problem też dla naszego mózgu, o czym świadczy dowolna rozmowa z udziałem kilku przekrzykujących się polityków. Ale jak to działa w studiu radiowym?

Czym innym jest tłumaczenie przybliżone przez maszynę, a czym innym przekład idealny. Tłumaczenie ma również twórczy charakter i nie ma jednego jedynego poprawnego rozwiązania dla danego problemu translatorskiego. Nie ma wcale jasności, czy „Hamleta” należy tłumaczyć jak Józef Paszkowski, Stanisław Barańczak, Maciej Słomczyński czy może jak Piotr Kamiński. To dotyczy jednak nie tylko literatury, ale nawet instrukcji montażu zlewu. W pewnym momencie po prostu nie wiadomo, jak tłumaczyć lepiej. Maszyny obecnie nie dochodzą do poziomu takich wyborów, lecz gdy dotrą – nie wiemy, co im podpowiedzieć.

Przede wszystkim jednak dobre tłumaczenie wymaga rozumienia tekstu. Wylano dużo atramentu na dyskusję, czy kiedykolwiek komputery będą w stanie rozumieć tekst. Zamiast omawiać eksperymenty myślowe, które mają przeważać szalę na jedną lub drugą stronę, wróćmy do przykładu Bar-Hillela. Skąd mamy wiedzieć, że kiedy pada wyraz „pen”, chodzi o kojec, a nie długopis czy pióro? W oryginalnej historyjce wcześniej pojawia się zdanie mówiące o tym, że Jasio schował zabawki do pudełka. Stąd można by wywnioskować, że po pierwsze Jan jest w wieku, w którym chowa się zabawki, a po drugie, że to jest to samo pudełko, o którym mowa później. Powoli powstają algorytmy, które pozwalają określać tego rodzaju relacje w tekście, lecz systematyczne rozwiązanie tego problemu wymagałoby stworzenia algorytmów budujących modele rzeczywistości na podstawie jej opisów. A to już jest zadanie stworzenia pełnej sztucznej inteligencji, gdyż wymaga skomplikowanych procesów wnioskowania oraz posiadania ogromnej wiedzy dodatkowej (np. wiążącej zdrobnienie imienia z wiekiem).

Jest w dodatku wątpliwe, czy da się w ogóle wyposażyć automat w taką wiedzę, jeśli sam automat nie będzie w stanie reprezentować rzeczywistości – a zatem mieć informacji, które będzie mógł sam wykorzystywać, a przede wszystkim oceniać pod kątem prawdziwości. Z tym zadaniem muszą mierzyć się również twórcy autonomicznych robotów podejmujących coraz bardziej skomplikowane decyzje. Systemy uczenia maszynowego nawet nie ocierają się o próby wykorzystania takiej autentycznej sztucznej inteligencji – lecz gdy się zbliżą, to następny artystyczny przekład „Odysei” heksametrem po polsku będzie tylko kwestią czasu. ©