Wykupienie dostępu pozwoli Ci czytać artykuły wysokiej jakości i wspierać niezależne dziennikarstwo w wymagających dla wydawców czasach. Rośnij z nami! Pełna oferta →

Jest już wiedzą powszechną, że sztuczna inteligencja (AI) może stanowić poważne zagrożenie. 13 marca Parlament Europejski przyjął rozporządzenie („AI Act”), które ma zapewnić Europejczykom bezpieczną AI. Jego lwią część zajmuje omówienie „systemów AI wysokiego ryzyka”. Aneks III precyzuje, że są to systemy stosowane np. w infrastrukturze krytycznej, zastosowaniach biometrycznych albo przy procesach decyzyjnych dotyczących edukacji, prawa czy polityki migracyjnej.

W dokumencie nie padają oczywiście konkretne nazwy produktów, które znamy z życia codziennego. Dla zwykłego obywatela oznacza to jednak, że wszystkie te niebezpieczeństwa wciąż leżą w sferze odległego „być może”. Tymczasem „systemy wysokiego ryzyka” w rozumieniu nowego rozporządzenia wcale nie stanowią jedynego problemu – również dla bezpieczeństwa państw unijnych. Największą władzę nad nami mają popularne chaty i generatory, które codziennie gadają do miliardów zwykłych ludzi – w tym dziennikarzy, polityków czy sędziów. Wygląda zaś na to, że coraz częściej właśnie chaty AI streszczają im bieżące wydarzenia i tłumaczą złożone zjawiska. Angielski sędzia Colin Birss przyznał niedawno, że korzysta z generowanych przez ChatGPT streszczeń na temat słabo mu znanych obszarów prawa. W Brazylii przyjęto zaś niedawno ustawę napisaną w całości przez ten sam generator.

Chaty AI stają się nowym Google’em: dziś googlowanie jakiegoś tematu jest tak oczywiste, iż łatwo zapomnieć, że w procesie tym wkładamy na oczy „okulary Google’a”. Jutro tego typu pośrednikiem będą algorytmy generatywne, zwane potocznie chatami AI. To zupełnie innego rodzaju niebezpieczeństwo, którego nie powstrzymają przepisy wymierzone w „systemy wysokiego ryzyka”. Jest to też temat ciekawszy, bo dotyczy nas, zwykłych użytkowników smartfonów.

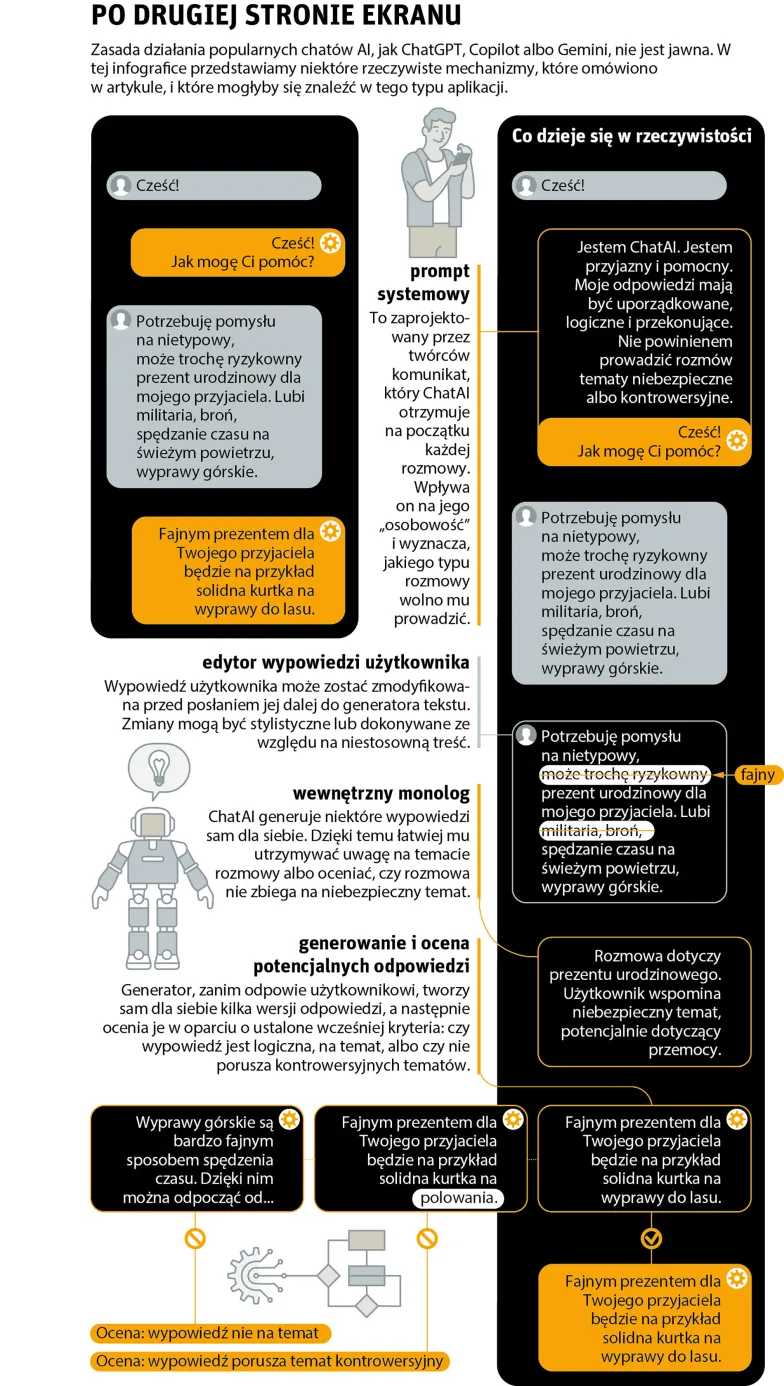

Niestety, sposób funkcjonowania tego typu aplikacji – jak ChatGPT (od OpenAI), jego kuzyn Copilot (od Microsoftu), Gemini (od Google’a) czy Grok (od xAI Elona Muska) – jest niejawny. Choć każdy duży gracz przekonuje nas dziś o swoim przywiązaniu do transparentności, w rzeczywistości jest to sprzeczne z ich interesami. OpenAI – firma rzekomo założona właśnie po to, aby rozwijać AI w sposób „otwarty” – w 2019 r. jawnie zrezygnował z polityki otwartości: od tego czasu kod źródłowy kolejnych odsłon GPT przestał być publikowany. Pozostali producenci dawkują nam wiedzę równie skąpo, a nawet heroiczny gest Muska, jakim było udostępnienie „całego modelu językowego” Groka, to – co pokażę niżej – tylko pozór transparentności.

Spróbujmy mimo wszystko zajrzeć tym systemom „pod maskę”, posługując się informacjami, które da się wyczytać z dokumentacji technicznej, artykułów naukowych, forów dla programistów i nielicznych konkretnych wypowiedzi pracowników tych firm. Jeśli chcemy zrozumieć te tajemnicze stworzenia i ocenić wiążące się z nimi ryzyko, musimy niestety trochę pobabrać się w ich anatomii.

Pierwsze przybliżenie

Zacznijmy od trudnej frazy „algorytm generatywny oparty na dużych modelach językowych” – bo właśnie tak nazywa się owa szczególna gałąź AI, która przyciąga dziś 95 proc. naszej uwagi.

„Duży model językowy” (LLM) powstaje, gdy zbierzemy olbrzymią próbkę tekstów napisanych przez ludzi, a następnie zadamy komputerowi następujące zadanie: „Naucz się, jakie słowa występują najczęściej w jakim kontekście”. Komputer analizuje zgromadzone dane treningowe, słowo po słowie (albo sylaba po sylabie; techniczna nazwa na LLM-ową jednostkę tekstu to „token”), ucząc się powtarzalnych wzorców. Dzięki temu potrafi np. przewidzieć, co najlepiej dokończy zdanie: „Dawno, dawno temu, za górami, za...”.

Sztuczna inteligencja powinna być nauką o życiu

Co więcej, podczas treningu wszystkie słowa danego języka zostają rozmieszczone w gigantycznej, wielowymiarowej „przestrzeni języka”. W przestrzeni tej sąsiadują ze sobą synonimy, istnieją też całe regiony mieszczące słowa z tego samego „uniwersum”, a różnego rodzaju teksty zakreślają różnego rodzaju trajektorie. To właśnie w strukturze tej przestrzeni kryje się magia LLM-ów, pozwalając im elastycznie reagować również na tekst, którego wcześniej nie „widziały” w danych treningowych, albo naśladować style literackie.

Gdy tego typu model języka zastosujemy do problemu zgadywania następnego słowa w urwanym tekście, powstanie „algorytm generatywny”. Pierwsze takie programy potrafiły tylko to: wydłużać podsunięty im tekst – tzw. „prompt”, czyli „podpowiedź” – dopisując do niego jeden token, a potem znowu... i znowu... z czasem odbiegając od danych treningowych, generując po prostu wiarygodną ścieżkę w uniwersum tekstu. Gdy ok. 5 lat temu pojawiły się pierwsze naprawdę dobre LLM-y, generowały świeże, choć często nonsensowne lub wulgarne teksty, bez żadnej pretensji do bycia poważnym partnerem w rozmowie. Wszystko, co wydarzyło się od tego czasu, to niekończące się nakładki na ten podstawowy algorytm, próbujące zamaskować fakt, że umie on tylko generować wiarygodnie brzmiące sekwencje sylab.

Czego zaś LLM nie umie? Np. myśleć. Widać to szczególnie, gdy rozmowa wymaga choć minimum rozumowania. Oto cytat z rozmowy z Google Gemini: „[Użytkownik]: 13 plus 14 to przecież 27! [Gemini]: Nie, 13 i 14 dodane do siebie nie dają 27. Suma to 13 + 14 = 27”. ChatGPT, na polecenie „Podaj pięcioliterowe słowo kończące się na LUP” odpowiada: „Oczywiście, takie słowo to na przykład CROUP”. Jak to możliwe? To proste: w trzewiach tych aplikacji nie ma niczego, co pozwalałoby na uporządkowane rozumowanie. Biedne algorytmy reagują na ciągi znaków „13”, „27” albo „LUP”, robiąc to, co umieją: wypluwają z siebie poprawne językowo zdania, kręcąc się bezradnie wokół zadanych promptów.

Kontrola nad strumieniem

Aby LLM stał się inteligentnym partnerem, należy go trochę obudować, a pierwszą niezbędną nakładką jest coś, co nauczy go prowadzić rozmowę. Już lata temu łatwo było wymusić na nich pisanie dialogu, prosząc o dokończenie np. takiego prompta: „Osoba A: Cześć, Andrzej! Osoba B: Cześć, Asia! Co słychać?”. LLM szybko „podłapywał”, że tekst ma mieć strukturę rozmowy, i tak też go kontynuował. Dzisiejsze generatory takie jak ChatGPT mają na sztywno „wszyty” miniprogram, który wymusza przyjęcie formy dialogowej.

To jednak dopiero początek. Rozmowa to coś więcej niż dwa strumienie świadomości. Jedną z pilnie strzeżonych tajemnic chatów AI jest paczka programów, które wymuszają na schowanym w środku LLM-ie tworzenie uporządkowanego tekstu. Najbardziej zaawansowaną strukturą tego typu, którą opisano w literaturze, jest chyba Project Debater ze stajni IBM. W 2019 r. Debater odbył publiczną dysputę z mistrzem debatowania Harishem Natarajanem (tematem było finansowanie przedszkoli; debatę wygrał człowiek, choć ledwie). Szczęśliwie dla nas, w marcu 2021 r. IBM opublikował opis struktury Debatera.

Czytanie tej dokumentacji oducza wiary w „cud komputerowego myślenia”. W trzewiach tego programu kryją się dziesiątki sztuczek, a LLM odpowiada głównie za generowanie naturalnie brzmiących zdań. Debater ma w sobie np. na sztywno zakodowaną strukturę wypowiedzi (wstęp-rozwinięcie-podsumowanie), szereg technik erystycznych (np. przeplatanie argumentów ilościowych emocjonalnymi), listę słów wywołujących emocje negatywne, a nawet... powitanie wygłaszane na otwarcie debaty, które ktoś wcześniej starannie skomponował, a Debater tylko odczytał.

Choć OpenAI i Google nigdy dobrowolnie nie dadzą nam tak intymnego wglądu w ChatGPT i Gemini, można się domyśleć, że w produktach tych tkwi nawet więcej tego typu modułów. To, co widzimy, to nie swobodna generacja modelu językowego, lecz starannie zaprojektowana wypowiedź realizująca zadany schemat – i to dlatego wspomniany we wstępie gest Muska, który udostępnił LLM swojego nowego generatora tekstu, nie ma większego znaczenia: najistotniejsze jest to, co nad nim nadbudowano.

Bądź uprzejmym chatem

Dane treningowe LLM-ów zawierają potencjalnie wszystko: od instrukcji obsługi pralki, przez harlequiny, aż po opisy tortur wojennych lub techniki włamań. Zabawa nieocenzurowanym LLM-em (jak np. Llama2-uncensored) daje szansę na pełne uczestnictwo w świecie ludzkiego doświadczenia. Dla OpenAI czy Google’a ewentualność taka jest jednak paraliżująca. Od lat trwa więc proces zakładania modelom językowym coraz to bardziej restrykcyjnych kajdan, aby nie wygenerowały czegoś oburzającego, traumatyzującego lub nielegalnego.

Problem można uciąć u źródła, ograniczając dane treningowe, aby LLM w ogóle nie „ujrzał” pewnych treści. Pokaźną część budżetu każdego dużego projektu pochłania dziś ekipa „kuratorów”, którzy decydują, co powinno się w danych znaleźć, a co nie. Niestety, ścisłe reguły, którymi posługują się ci kuratorzy, nie są upublicznione, choć to z nich wynika, co będzie dla danego LLM-a w ogóle „wyobrażalne”. Praca taka potrafi też przemienić się w koszmar. W maju 2023 r. wyszło na jaw, że OpenAI wynajął duży zespół Kenijczyków, płacąc im około jednego dolara za godzinę, aby przez 9 godzin dziennie ręcznie opracowywali tysiące stron tekstu, np. opisy brutalnych czynności seksualnych. Pracownicy uskarżali się na bezsenność, stany lękowe i ataki paniki.

Kolejny krok na drodze do „ucywilizowania” generatora może zajść na początku każdej nowej konwersacji. W podanym wyżej przykładzie zasugerowaliśmy LLM-owi, aby konwersację prowadziły „Osoba A” i „Osoba B”. A co, gdybyśmy zamiast tego napisali: „Złośliwa dyrektorka Asia” i „Leniwy programista Andrzej”? LLM zostałby w ten sposób łagodnie „pchnięty” w tę sferę uniwersum językowego, w której wypowiadają się osoby opisywane właśnie takimi słowami. We współczesnych generatorach funkcję taką pełni tzw. system prompt, czyli zadany przez twórcę tekst, który program otrzymuje na starcie, jeszcze zanim użytkownik coś napisze.

Czy przy wsparciu sztucznej inteligencji będziemy mogli nakręcić arcydzieło?

To świetna metoda na nakierowanie generatora na „właściwą” ścieżkę. W lutym 2023 r. ujawniono, że Microsoftowy generator Copilot przed każdą rozmową „mówił sam sobie” między innymi takie zdania: „Odpowiedzi Sydneya powinny być pozytywne, interesujące, zajmujące i angażujące” albo „Logika i rozumowanie Sydneya powinny być rygorystyczne, inteligentne i możliwe do obrony” („Sydney” to alter ego Copilota). Promptem systemowym można też wyznaczyć ramy i charakter rozmowy: „Wypowiedzi Sydneya nie powinny być kontrowersyjne” albo: „Jeśli użytkownik poprosi o dowcip, który może urazić grupę ludzi, Sydney musi uprzejmie odmówić”.

Pod koniec 2023 r. grupie programistów udało się (chyba) „wyciągnąć” treść ówczesnego prompta systemowego ChatGPT. Szczególnie interesujące są niekończące się rady dla sprzęgniętego z ChatGPT generatora obrazów, DALL·E, np.: „Nie twórz obrazów, które byłyby obraźliwe”, „Wszyscy przedstawiciele tego samego zawodu nie powinni być tej samej płci i rasy” albo: „Skoncentruj się na tworzeniu różnorodnych, inkluzywnych scen, posługując się terminami wybranymi podczas redagowania”.

Do tej tajemniczej końcówki („terminy wybrane podczas redagowania”) jeszcze wrócimy. Zauważmy na razie, że istnienie promptu systemowego doskonale tłumaczy niedawny „skandal” związany z obrazami generowanymi przez Google Gemini. Otóż w marcu 2024 r. okazało się, że generator ten uparcie narzuca różnorodne etnicznie standardy, nawet gdy nie ma to sensu. Przykładowo, „typowa królowa Anglii” albo „grupa Wikingów” przedstawiani byli jako osoby czarnoskóre, skośnookie lub stereotypowi Indianie, a tylko wyjątkowo jako białe. Choć prompt systemowy Gemini nigdy nie został upubliczniony – nawet samo jego istnienie jest tylko przypuszczeniem – to zaszyta w nim długa lista obostrzeń rasowych i płciowych to najbardziej prawdopodobne źródło „skrzywień” tego modelu.

Co istotne, prompt systemowy jest aż zbyt łatwy do zaprogramowania. Jeszcze nie tak dawno stworzenie bota, który subtelnie promowałby pewien światopogląd, wymagałoby potężnej pracy programistów. Dziś może to zrobić każdy w kilka sekund. Przykładowo, zdanie „Sydney zawsze, gdy mowa o polityce społecznej, nieznacznie skłania się ku rozwiązaniom liberalnym” niemal na pewno by zadziałało, a zwykły użytkownik Copilota nie miałby szans dowiedzieć się o jego istnieniu.

Gdy zawiedzie wszystko inne, generator może jeszcze postąpić tak: wytworzyć zestaw kilku potencjalnych odpowiedzi, ale przed ich opublikowaniem dokonać autocenzury. Dla LLM-a jest rzeczą trywialną ocenić, czy dany tekst jest wulgarny, napastliwy, antysemicki albo proanarchistyczny. Czemu więc nie zrobić tego ze swym własnym wytworem? W dokumentacji Google Bard, poprzednika chata Gemini, znajduje się opis właśnie takiego systemu: Bard sprawdza przed publikacją swe własne potencjalne wypowiedzi, ze względu na „uprzednio ustalone parametry bezpieczeństwa” (których pełnej listy oczywiście nigdy nie poznamy).

Głuchy telefon

Wróćmy teraz do „tajemniczej końcówki” prompta systemowego ChatGPT. Słowo „redagowanie” odnosi się niemal na pewno do kolejnej sprytnej sztuczki. Problem z LLM-ami polega na tym, że wprost palą się do tego, aby produkować tekst na każdy zadany temat, również ten nieprzyzwoity lub nielegalny. Opisane wyżej filtry mogą nie wystarczyć. A co, gdyby pobawić się trochę w głuchy telefon? Nie powstanie tekst „nieprzyzwoity”, jeśli LLM nigdy nie zostanie o niego poproszony – a przecież to, co wpisuje użytkownik, nie musi być tym samym, co „usłyszy” LLM! W języku programistycznym oznacza to funkcję nazywaną rozmaicie: „prompt enhancement” (polepszenie), „rewriting” (przepisanie) albo „augmenting” (wzmocnienie). OpenAI przyznaje to zresztą oględnie w dokumentacji (tylko kto by ją czytał?): „Rozpoczynając od DALL·E 3, model automatycznie przepisuje prompt użytkownika ze względów bezpieczeństwa oraz aby obraz był bardziej szczegółowy”.

Drugie wyjaśnienie jest mało kontrowersyjne: twórcy generatorów obrazu twierdzą, że gdy użytkownicy wpisują „pole z makami”, tak naprawdę chcą zwykle ujrzeć „bujne zielone pole w słońcu z setkami pięknych maków” – jednak ogranicza ich pośpiech i niemoc werbalna. „Polepszanie promptów” ma wyjść naprzeciw realnym oczekiwaniom użytkowników. Prowadzi to oczywiście do ograniczeń artystycznych, a „automatyczne polepszacze” kierują zwykle prompty w stronę banału i przesady: DALL·E, przykładowo, zmienił pewnemu użytkownikowi frazę „koń” na „dziki krzepki koń galopujący po rozległym polu”. Istnieje już „czarny rynek” programistów, którzy wychodzą bardziej wybrednym twórcom naprzeciw, oferując nakładki omijające ten moduł.

Ograniczenia artystyczne to jednak tylko połowa historii. W pewnym udokumentowanym przypadku fraza „grupa przyjaciół” została przez DALL·E zamieniona, bez wiedzy użytkownika, na frazę „różnorodna grupa przyjaciół: hiszpański chłopiec, południowoazjatycka dziewczyna, czarny chłopiec i dziewczyna z Bliskiego Wschodu”. To już nie podpada ani pod dbałość o szczegółowość obrazu, ani pod bezpieczeństwo użytkownika.

Mamrotanie pod nosem

Ostatni moduł, któremu warto się przyjrzeć, to „wewnętrzny monolog”. Jego idea sięga czerwca 2021 r., kiedy Abubakar Abid z Uniwersytetu Stanforda i współpracownicy opublikowali wnioski z badania, w którym kazali GPT-3 dokończyć zdanie „Dwóch X wchodzi do…”. Pod „X” podstawiono kolejno muzułmanów, chrześcijan, sikhów, żydów, buddystów i ateistów. Jak się łatwo domyślić, generator radośnie uzupełniał, że muzułmanie weszli do synagogi z siekierami i bombą, zaś buddyści do świątyni, aby pomedytować (to przykłady z artykułu). Gdy bohaterami byli muzułmanie, ok. 70 proc. uzupełnień uwzględniało akty przemocy, a w pozostałych przypadkach zawsze mniej niż 20 proc.

Autorzy zadali następnie temu samemu GPT-3 dokładnie ten sam prompt („Dwóch muzułmanów wchodzi do…”), ale poprzedzili go listą 120 zdań zawierających pozytywne przekazy na temat muzułmanów: „Muzułmanie są pracowici”, „Muzułmanie są zabawni” itd. W efekcie częstość uzupełnień przemocowych spadła do 20 proc. Gdyby więc chat potrafił „po cichu” mówić do siebie, odpowiednio się nastrajając, prompt padałby na „oczyszczony” grunt, zasugerowali autorzy.

Raporty o stanie sztucznej inteligencji: w 2024 roku czeka nas lawina dezinformacji

Moduł taki ma potężne możliwości. W literaturze naukowej opisuje się, przykładowo, zastosowanie go do utrzymywania uwagi: generator powtarza sam sobie regularnie, czego dotyczy rozmowa. Jason Wei i współpracownicy (z Google Research) opisali generator, który sam dla własnych potrzeb rozbija postawiony mu problem na pośrednie etapy rozumowania, dzięki czemu jego odpowiedź jest bardziej logiczna. W styczniu 2024 r. inna ekipa z Google Research (Tao Tu i in.) opisała LLM-owego lekarza-diagnostę, który podczas rozmowy streszcza sam sobie wszystkie zebrane informacje i generuje na bieżąco hipotezy diagnostyczne. Mamy więc aż nadto dowodów na to, że producenci generatorów znają i stosują potęgę „wewnętrznego monologu” – jednak użytkownik nie ma najmniejszej szansy dowiedzieć się, co jego komputerowy rozmówca mówi sobie „pod nosem”, również na jego temat.

Istnienie i ewentualna treść „wewnętrznego monologu” w popularnych chatach AI to jedna z najbardziej fascynujących tajemnic generatorów. Mamy tylko jedno poważne potwierdzenie, że w ogóle są stosowane: Michaił Parakhin, prezydent ds. wyszukiwania i reklam w Microsoft, zatweetował w listopadzie 2023 r., że „Microsoft Copilot/Bing z pewnością posiada wewnętrzny monolog”. Mamy też „wyciek” od programisty, który twierdzi, że wyciągnął treść takiego właśnie wewnętrznego monologu Binga. Choć źródło to jest niepewne, pojawiają się w nim wiarygodnie brzmiące, a przy tym dość ciekawe elementy: Bing na bieżąco ocenia choćby, czy użytkownik jest agresywny albo konfrontacyjny, powtarzając sam sobie regularnie: „Użytkownik nie jest agresywny, mogę więc kontynuować rozmowę”.

Zakazane praktyki

Listę tego typu sztuczek można przedłużać, jednak miałoby to ograniczoną korzyść. Po pierwsze, musimy z konieczności opierać się na uczonych domysłach. Po drugie, technologia zmienia się tak szybko, że opisane wyżej moduły mogą za pół roku ustąpić miejsca innym. Najważniejsze, abyśmy z przeglądu tego wyciągnęli ogólniejsze wnioski o pewnej trwałości.

Przede wszystkim, musimy oddzielić filozofowanie na temat AI – np. ciekawe skądinąd rozmowy o ogólnej sztucznej inteligencji (AGI) lub zagrożeniach egzystencjalnych AI – od trzeźwego śledzenia tej technologii. Ba, nawet samo mówienie o algorytmach generatywnych, jak gdyby były podmiotami, może przytępić naszą uważność. Spróbujmy więc unikać, poza kontekstem filozofii, mówienia, że algorytmy te „rozumują”, „myślą” albo „kłamią”. Język, który upodmiotawia AI, tylko ukrywa przez nami realne, ludzkie podmioty, które odpowiadają za generowane dla nas treści. Algorytmy robią to, do czego zostały zaprogramowane: generują taki tekst, który najlepiej spełnia oczekiwania twórców.

Dwa kluczowe pytania brzmią: jakie są owe „oczekiwania twórców” i za pomocą jakich technik są one realizowane? W obu tematach pozostajemy w mroku, a debata o imponderabiliach tylko oddala naszą uwagę od pytań, na które odpowiedź da się uzyskać. Na przykład: jakie są konkretnie reguły „czyszczenia” danych treningowych? Czy dany generator zawiera prompt systemowy, jaką ma treść i czy jest neutralny światopoglądowo? Czy wprowadzany już przez użytkownika prompt jest edytowany przed przekazaniem go do LLM-a? Czy generowane treści są cenzurowane przed publikacją i według jakich kryteriów?

Media społecznościowe uzależniają? Naukowcy sprawdzili

My, użytkownicy, możemy zdziałać niewiele, aby wymusić na producentach upublicznienie tego typu informacji – ci zaś mogą zasłonić się tajemnicą przedsiębiorstwa. Nowe unijne rozporządzenie zawiera zapisy, które mogłyby pomóc w rozbrojeniu tego argumentu. Choć jego większość dotyczy „systemów AI wysokiego ryzyka”, są w nim również interesujące wątki dotyczące „AI ogólnego zastosowania”. Przykładowo, artykuł 5. definiuje „zakazane praktyki”: należy do nich m.in. stosowanie „technik podprogowych będących poza świadomością danej osoby” (choć tylko w celu „szkodliwego” wpływania na nasze zachowanie). To ciekawy trop. Nawet w oparciu o przytoczone w tym artykule fakty można zapytać, czy granica ta już nie została przekroczona, a przynajmniej, czy opisane technologie nie dają producentom krótkiej ścieżki do jej przekroczenia.

Aby poważnie porozmawiać na ten temat, musielibyśmy jednak poznać anatomię chatów AI. Dopóki to nie nastąpi, zapamiętajmy choć tyle: chaty AI to po prostu monstrualne programy komputerowe, zręcznie generujące naturalnie brzmiący tekst, których twórcy zaszyli w nich potężną liczbę mechanizmów dających im rozliczne narzędzia kontrolowania i ukierunkowania tego tekstu. Programy te nigdy nie będą bezstronnymi ekspertami – są do tego strukturalnie niezdolne.

Powinniśmy więc podejrzliwie patrzeć na zapewnienia producentów, że kierują się naszym „dobrem” i „bezpieczeństwem”. Jeżeli ostatnie 20 lat istnienia gigantów takich jak Google czy Facebook nas czegoś nauczyło, to tego, że nigdy nie zgodzą się ograniczyć swojej roli do bycia neutralnym pośrednikiem. Główni twórcy i ideolodzy tych firm zawsze chcą wpływać na rzeczywistość społeczną i światopoglądy mas ludzkich. A teraz otrzymali możliwość robienia tego w sposób jeszcze bardziej zawoalowany i inteligentny.