Wykupienie dostępu pozwoli Ci czytać artykuły wysokiej jakości i wspierać niezależne dziennikarstwo w wymagających dla wydawców czasach. Rośnij z nami! Pełna oferta →

Kiedy się okazało, że chatbot Gemini AI wykazuje się poprawnością nadmiarową nawet jak na standardy wielkich korporacji dbających o swój progresywny wizerunek, firma Google zapowiedziała czasowe zawieszenie niektórych jego funkcji. W szczególności funkcji generatora obrazów – o to bowiem poszło. Proszony o stworzenie wizerunków „amerykańskich senatorów z XIX wieku”, „papieży”, „wikingów” czy też „niemieckich żołnierzy z czasów II wojny światowej”, Gemini AI posłusznie prezentował galerię spełniającą współczesne kanony różnorodności. Byli to zatem mężczyźni i kobiety o rozmaitych kolorach skóry i tożsamościach etnicznych, przyodziani zgodnie z panującymi w ich społecznościach i epokach zasadami. Wszystko to z imponującą mocą graficzną oraz dbałością o szczegół, tyle że absolutnie bez związku z realiami historii.

Że nie mieliśmy tutaj do czynienia z przemyślaną akcją dywersyjną radykalnej lewicy, jak ogłosiła od razu część prawicowych komentatorów, a jedynie z pomyłkowym zastosowaniem pewnych reguł także tam, gdzie się stosować nie powinny – o tym świadczy szybka reakcja producenta. Nikt nawet przez chwilę nie próbował bronić takiej, nazwijmy to, strategii obrazotwórczej. Przeciwnie: Jacob Krawczyk, jeden z dyrektorów odpowiedzialnych za projekt, od samego początku podkreślał, że generator trzeba poprawić, bo w tym przypadku zdecydowanie się zapędził. Można więc wziąć to polityczne zamieszanie w nawias, nie to jest w całej sprawie najistotniejsze, a przynajmniej nie w pierwszej kolejności. Rdzeń problemu tkwi głębiej, na poziomie – jak to często bywa – fundamentalnym. Wyraża go pytanie: dlaczego sztuczna inteligencja kłamie i kompletnie nic sobie z tego nie robi? Bo przecież ci nieszczęśni „senatorowie” to nie jest jedyna konfabulacja w wykonaniu takiego czy innego chatbota. Każdy, kto się z nimi zetknął, wie dobrze, że strasznie kręcą.

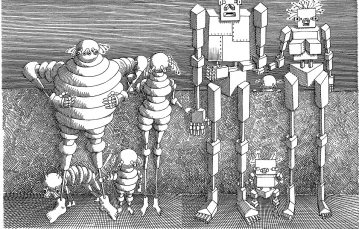

Zacznijmy od tego, że model językowy, jak sama nazwa wskazuje, zajmuje się wytwarzaniem zdań. Owszem – analizuje informacje, przetwarza dane, rachuje, ale przede wszystkim tworzy zdania. Ze zdań – większe całości. A z tych większych całości – jeszcze większe. Mają one jak najdokładniej odwzorowywać ludzką aktywność w tym obszarze. Imitować komunikację. Piszę „imitować”, bo dopóki nie istnieje ktoś, kto intencjonalnie chce coś powiedzieć komuś innemu – zawsze będziemy mieli do czynienia z imitacją. Choćby człowiek miał najgłębsze i najbardziej realistyczne doświadczenie spotkania z kimś, to dopóki tego kogoś faktycznie nie będzie, a będą wyłącznie zewnętrzne oznaki udające, że jest, dopóty pozostanie to imitacją spotkania.

W przypadku sztucznej inteligencji sięga to jeszcze dalej. Jak wspomniałem, jej podstawowym zadaniem jest generowanie spójnych wypowiedzi. Jak to robi? Tego do końca nikt nie wie, ale w każdym razie – analizując wypowiedzi już wcześniej sformułowane i wytwarzając na tej podstawie coś, co będzie akurat najlepiej pasowało do kontekstu. Otóż zwróćmy uwagę, że kwestia prawdy i fałszu w ogóle w tym polu nie powstaje. Bo i nie może powstać – skoro poruszamy się wyłącznie na poziomie zdań, nigdy zaś na poziomie tego, co te zdania mają opisywać. Owszem, istnieją i takie definicje prawdy – np. koherencyjna – w których w ogóle się o rzeczywistości innej niż językowa nie wspomina. W myśl takich definicji prawdziwe jest to, co niesprzeczne z innymi zdaniami oraz poprawne logicznie. Są to jednak definicje cokolwiek ryzykowne, nieuchronnie popadające w kłopoty, ilekroć ktoś zacznie się im z bliska przyglądać.

Kolejne fundamentalne pytanie brzmi zatem: do jakiego stopnia możemy w ogóle polegać na sztucznej inteligencji w takich kwestiach jak edukacja czy wiedza? Historia jest tutaj dobrym, acz oczywiście niejedynym przykładem. Historycy, ale i naukowcy z innych dyscyplin wykonują codziennie tytaniczną pracę, żeby wyekstrahować z oceanu wytwarzanych przez ludzkie umysły zdań jakieś okruchy, które w sposób rzetelny i adekwatny odzwierciedlają rzeczywistość. Mają do dyspozycji sieć naukowych instytucji, metodologię i doświadczenie wcześniejszych pokoleń, a i tak nierzadko dają się zwieść. Frazom pięknie brzmiącym, tekstom nadmiarowo spójnym oraz różnym środowiskowym presjom i modom, sugerującym, że lepiej się nie wychylać, nie podważać tego, co powszechnie ustalone, żeby się nie narazić na ostracyzm. Szczęśliwie system nauki działa tak, że prędzej czy później wyłapuje te zwiedzenia i dokonuje stosownych poprawek.

Teoretycznie mogłoby się wydawać, że sztuczna inteligencja będzie właśnie od tego wolna. I że nie lękając się żadnego cancelingu, nie ulegając żadnym presjom i modom, będzie po prostu mówić, jak jest. Tymczasem – nic podobnego. Jak na razie ekstrahuje ona z oceanu zdań te, które statystycznie wyglądają na najdogodniejsze do użycia, a kiedy takich nie znajduje, sama je dopisuje. I ani myśli stosować autokorektę.

Czy to się może zmienić? Czy wystarczy udoskonalić algorytm? Szczerze mówiąc – nie sądzę. Żeby mówić prawdę, trzeba rozumieć różnicę pomiędzy fikcją a rzeczywistością. A nie zrozumie jej nigdy ktoś, kto nie istnieje, lecz jedynie istnienie imituje.