Wykupienie dostępu pozwoli Ci czytać artykuły wysokiej jakości i wspierać niezależne dziennikarstwo w wymagających dla wydawców czasach. Rośnij z nami! Pełna oferta →

Była postrachem całego świata. Co roku tylko w Europie pochłaniała 400 tys. istnień, co trzeciego zarażonego. Oszpecała niemal wszystkich chorych i oślepiała prawie połowę tych, którzy przeżyli. W równym stopniu bali się jej biedacy, co królowie: jej ofiarami padli Ludwik XV, car Piotr II, austriacki cesarz Józef I i angielska królowa Maria II.

Czarna ospa, zwana dziś formalnie ospą prawdziwą (variola vera), stała się też pierwszą zarazą, w walce z którą wykorzystano w połączeniu ze sobą – skutecznie – dwa naukowe narzędzia, stojące od tej pory u podstaw zmagań ludzkości ze wszystkimi epidemiami. Szczepienia i modelowanie matematyczne.

Igły i równania

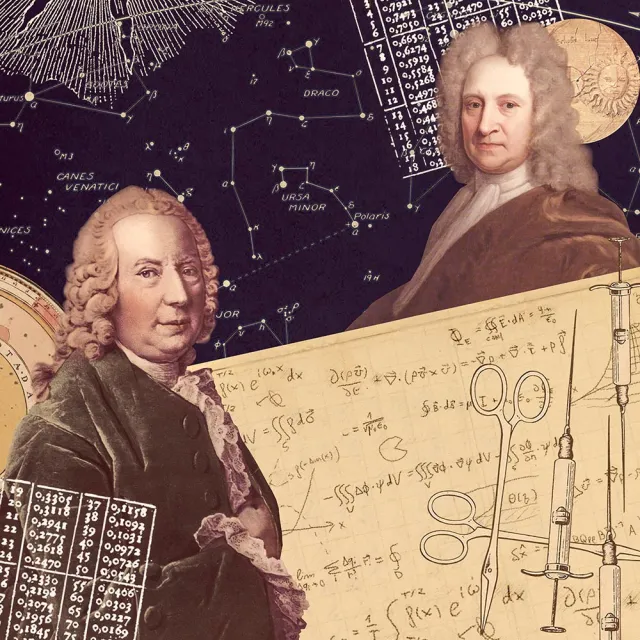

Za jednego z twórców epidemiologii matematycznej uchodzi ten sam człowiek, który w pewnym sensie nauczył ludzkość latać. Daniel Bernoulli. Ów XVIII-wieczny szwajcarski matematyk i fizyk sformułował równania opisujące przepływ cieczy, sto lat po jego śmierci wykorzystane do opisania siły nośnej generowanej przez skrzydło. Szerokie zainteresowania Bernoullego obejmowały jednak także medycynę i biologię. A nie było za jego życia bardziej palącego medycznego problemu niż epidemie dziesiątkujące świat. Matematyk oszacował, że trzy czwarte wszystkich żyjących w jego stuleciu ludzi zostało w którymś momencie zarażonych ospą.

Na czarną ospę nie było leku, była jednak znana jedna, zapożyczona ze Wschodu technika inokulacji, pomagająca chronić się przed zarazą: wcieranie w ranę ropy z pęcherzy chorych na mniej zjadliwy szczep ospy, variola minor. Zabieg ten dawał często odporność na „prawdziwą” czarną ospę, ale był sam w sobie niebezpieczny: śmiertelność wśród stosujących go dochodziła do dwóch procent.

Bernoulli postanowił sprawdzić, czy technika ta mogłaby umożliwić całkowite wyeliminowanie choroby. Wyniki swojej analizy ogłosił w 1760 r. na posiedzeniu Królewskiej Akademii Nauk w Paryżu. Zadał wówczas następujące, niełatwe pytanie: „Jak wyglądałby stan rasy ludzkiej, gdybyśmy, za cenę pewnej liczby ofiar, mogli dać jej wolność od naturalnej ospy?”.

Aby na nie odpowiedzieć, stworzył pierwszy matematyczny opis epidemii. Opierał się przy tym na tabelach urodzin i śmiertelności mieszkańców Wrocławia z lat 1687-1691 opracowanych przez astronoma Edmunda Halleya. Biorąc pod uwagę liczbę osób zakażonych, podatnych, odpornych, wielkość populacji, na którą przypada jedno zakażenie w każdym roku, i liczbę zachorowań, na które przypada zgon, Bernoulli starał się za pomocą rachunku różniczkowego odtworzyć rozprzestrzenianie się choroby wśród mieszkańców. Z jego wyliczeń wynikało, że wyeliminowanie ospy pozwoliłoby przedłużyć średnią długość życia wrocławian z 26 lat i 7 miesięcy do 29 lat i 9 miesięcy. Z hipotetycznej grupy 1300 niemowląt urodzonych w każdym roku 79 więcej dożyłoby dwudziestych piątych urodzin.

Obliczenia Bernoullego były przełomowe. Nie tylko przekonały władze o wartości inokulacji (30 lat później angielski lekarz Edward Jenner zademonstrował o wiele bezpieczniejszy i skuteczniejszy sposób sztucznego wytwarzania odporności – pierwszą nowoczesną szczepionkę na ospę), lecz przede wszystkim wprowadziły do medycyny i epidemiologii język matematyki, którym w walce z epidemiami posługujemy się do dziś. „Chciałbym, żeby w kwestiach, które są tak istotne dla dobrostanu ludzkości, nie podejmowano żadnych decyzji bez wiedzy płynącej z analizy i obliczeń” – pisał Szwajcar w podsumowaniu pracy.

Ile osób dzisiaj spotkasz?

Oczywiście, dzisiejsze modele mogą być o wiele bardziej złożone. Analizę danych epidemiologicznych przeprowadza się obecnie często z wykorzystaniem centrów obliczeniowych, a nie kawałka papieru i pióra. Ale ogólna zasada pozostaje podobna. Zamiast przyglądać się pojedynczym przypadkom, analizujemy cały system i próbujemy przewidzieć, jak przy różnych scenariuszach rozwoju wypadków rozprzestrzeniać się będzie choroba. To z kolei pozwala sterować polityką zdrowotną tak, by zmaksymalizować efektywność systemu opieki zdrowotnej przy ograniczonych zasobach.

Niemal każda prowadząca modelowanie epidemiologiczne grupa badawcza posługuje się własnym modelem statystycznym, często opracowywanym od lat. Ich podstawy są jednak bardzo podobne. Najprostszym schematem jest tzw. model SIR. Podobnie jak pierwotny model Bernoullego pozwala on na śledzenie liczebności trzech grup ludzkich: S (Suspectible – podatni), czyli osoby, które mogą zostać zainfekowane, ale jeszcze nie są; I (Infected), czyli zarażeni; oraz R (Removed), czyli osoby usunięte z obu poprzednich grup – albo na skutek przechorowania i nabycia odporności, albo, niestety, zgonu. Do tej samej grupy zaliczani są ludzie, którzy mają wrodzoną odporność i nie mogą zapaść na daną chorobę.

Modelujący przyjmują następnie założenia wyjściowe. Badacze mogą dzielić społeczeństwo na mniejsze podgrupy – ze względu na wiek, płeć, zawód, sposób spędzania wolnego czasu itd. – każdej przypisując inne parametry, takie jak podatność na zachorowanie czy ilość kontaktów wewnątrz i na zewnątrz grupy. Chodzi o ustalenie, kto spotyka się z kim i jak często oraz jak prawdopodobne przy okazji takiego kontaktu jest zarażenie. Co więcej, zachorowanie może wiązać się z różnym ryzykiem dla członków poszczególnych grup (kohort): inaczej chorobę przechodzą starsze kobiety, inaczej młodzi mężczyźni. Im więcej grup, tym model powinien stawać się precyzyjniejszy. Równolegle gwałtownie jednak wzrasta poziom skomplikowania obliczeń. Zwłaszcza że chcąc wziąć poprawkę na błędne założenia i nieprzewidywalność rzeczywistego świata – tzw. „znane nieznane” i „nieznane nieznane” – badacze każdą symulację powtarzają dziesiątki czy setki razy, wprowadzając drobne korekty w danych wejściowych.

Inne podejście, do niedawna nieosiągalne z czysto technicznych względów, to tzw. podejście agentowe, symulujące, na podstawie podobnych danych, zachowania jednostek w społeczeństwie. Ponieważ każdy człowiek modelowany jest z osobna, metoda ta wymaga wykorzystania ogromnej mocy obliczeniowej i gigantycznych baz danych, obejmujących codzienne zwyczaje, nawyki czy rutynowe działania członków danej grupy. Brytyjscy badacze z London School of Hygiene and Tropical Medicine (LSHTM), University College London i Cambridge oparli swój model agentowy na danych pochodzących z mediów społecznościowych 36 tys. ochotników.

O ile jednak możemy założyć, że ludzkie zachowania będą wyglądać podobnie, niezależnie od tego, jaką konkretnie chorobę modelujemy, o tyle naukowcy muszą też przyjąć założenia odnośnie biologii samego patogenu i tego, jak reaguje na niego nasz organizm. I tu zaczyna się poważny problem. Bo kiedy o atakującej nas chorobie nie wiemy nic lub niewiele, badacze muszą posługiwać się szacunkami. Muszą więc założyć, ile osób przeciętnie zarazi jeden chory (niesławna podstawowa liczba odtwarzania, R0), jaka jest śmiertelność czy podatność choroby na leczenie, a także jak wirus będzie wpływał na różne populacje – przykładowo, w Unii Europejskiej poszczególne kraje mają odmienne rygory szczepień obowiązkowych. Oczywiście, z biegiem czasu nasza wiedza się pogłębia, ale nawet niewielkie zmiany tych parametrów mogą mieć ogromne znaczenie dla prognozowanego przebiegu epidemii.

Zmiana kursu

Ciągła zmiana danych to powód, dla którego prognozy przebiegu epidemii bezustannie się zmieniają. Są jak prognoza pogody. Podczas epidemii wirusa ebola w Sierra Leone uczeni z LSHTM ustalili, że modele dają precyzyjne prognozy najwyżej na tydzień lub dwa. Muszą być aktualizowane na bieżąco, żeby oddawać zmiany sytuacji w rzeczywistym świecie oraz nową wiedzę.

Nie można na przykład z góry założyć, że nowa metoda leczenia zmniejszy śmiertelność albo przyczyni się do tego, że mniej ludzi będzie musiało korzystać z respiratorów. Nie da się też przewidzieć gdzie, kiedy i w jaki sposób czynnik chorobotwórczy zmutuje, wywracając całe równanie do góry nogami. W czasie epidemii matematycy epidemiologiczni są na permanentnym ostrym dyżurze. „Od stycznia nie miałem nawet jednego dnia wolnego – mówił magazynowi „Nature” Neil Ferguson, autor wpływowego, brytyjskiego modelu opublikowanego przez Imperial College London. – To niezwykle wyczerpujący okres”.

Ten sam Ferguson jest jednak żywym dowodem na to, że modele, przy wszystkich ograniczeniach, odgrywają kluczową rolę w epidemiologicznej polityce. Stosowany przez niego model, oparty na algorytmach wykorzystanych w 2005 r. podczas epidemii ptasiej grypy (H5N1), jeszcze w lutym zakładał, że 15 proc. chorych na COVID-19 będzie wymagało mechanicznej respiracji. Szacunki te pozwalały przypuszczać, że brytyjska służba zdrowia nie zostanie przeciążona i będzie w stanie pomóc wszystkim, którzy będą musieli trafić na OIOM.

Założenie to przyjęto na podstawie chińskich danych: co prawda podczas epidemii w Wuhan na intensywną terapię trafiło 30 proc. chorych, ale wielu z nich podano jedynie tlen i nie korzystali z respiratora. Lekarze uznali więc, że wystarczy im standardowa opieka szpitalna. Te dane wkrótce jednak zweryfikowała epidemia we Włoszech, gdzie sam tlen w wielu przypadkach okazał się niewystarczający. Gdy wartość podniesiono do 30 proc., model wskazał, że przeładowanie służby zdrowia na Wyspach może doprowadzić do śmierci pół miliona Brytyjczyków. Rząd, początkowo niechętny zamrożeniu życia gospodarczego i społecznego, w obliczu takiej wizji szybko zmienił kurs.

Strumienie danych

Największym problemem epidemiologów pozostaje jednak wciąż brak danych, przede wszystkim brak testów. Z perspektywy matematyka niemal żaden kraj nie robi ich dość, by mieć pełen obraz rozwijania się epidemii. Oksfordzki zespół epidemiologów prowadzony przez Sunetrę Guptę opublikował analizę, gorąco dyskutowaną i krytykowaną, z której wynikało, że obecne dane dotyczące liczby hospitalizacji i zgonów w równym stopniu mogą pasować do dwóch skrajnie różnych modeli przebiegu epidemii. Według pierwszego epidemia powoli przebija się przez brytyjskie społeczeństwo i do początku maja zaraziła ok. 200 tys. ludzi przy śmiertelności przekraczającej 15 proc. Według drugiego – wirus już dawno, niezauważony, przetoczył się przez cały kraj, zarażając ponad połowę mieszkańców i w przytłaczającej większości przypadków nie przyprawiając ich nawet o najsłabsze objawy. Problem w tym, że nikt nie ma dziś dość środków, by przetestować tak wielu bezobjawowych pacjentów. A bez badań i płynących z nich danych modele zawsze będą obarczone ogromną niepewnością.

Z pomocą idą już narzędzia Big Data, które w przyszłości będą odgrywały w całym procesie coraz większą rolę. Napędzające je algorytmy uczenia maszynowego mogą analizować na bieżąco dziesiątki strumieni danych: od zgłoszeń do szpitali, przez ruch na przejściach granicznych, lotniskach i stacjach metra, po obrazy z kamer czy dane genetyczne. Potrafią też czytać wpisy w mediach społecznościowych i śledzić, kto pisze, że „źle się czuje”, a także analizować przemieszczanie się i kontakty społeczne potencjalnych nosicieli. Ostatecznie, co doskonale ilustruje chiński przykład, mogą więc także obdzierać ludzi z prywatności pod płaszczykiem walki z epidemią. Stosowanie ich będzie wymagało ogromnej roztropności. Choroba może zakończyć nasze życie, ale niekontrolowany nadzór na usługach walki z epidemią może je zupełnie zmienić.

„Wszystkie modele się mylą, ale niektóre mogą być użyteczne”, miał mawiać legendarny brytyjski statystyk George Box. Użyteczne pozostają wtedy, jeśli dzięki nim jesteśmy w stanie zawężać spektrum możliwych rozwojów wypadków i racjonalnie dysponować środkami. Aby jednak tak było, epidemiolodzy muszą wiedzieć jak najwięcej: z jednej strony na temat samego wirusa i wywoływanej przez niego choroby, z drugiej – na temat liczby zakażonych w populacji. Bez tego modele mogą okazać się mylące, zwłaszcza jeśli za bardzo chcemy uwierzyć w te najbardziej optymistyczne.

Oczywiście, politycy najchętniej pokazywaliby na konferencjach te modele, które sugerują, że jest już niemal po wszystkim, że epidemia została opanowana i możemy wracać do „nowej normalności”. Harwardzki epidemiolog William Hanage przestrzega jednak w rozmowie z „Science” przed nadmierną wiarą w modele, które pokazują, że wirus jest pod kontrolą. Zwłaszcza taki wirus, o którym wciąż niewiele wiemy: „To tak, jakbyś postanowił ujeżdżać tygrysa. Ale nie wiesz, gdzie jest tygrys, jak duży jest ani właściwie z iloma tygrysami masz do czynienia”. ©