Wykupienie dostępu pozwoli Ci czytać artykuły wysokiej jakości i wspierać niezależne dziennikarstwo w wymagających dla wydawców czasach. Rośnij z nami! Pełna oferta →

ALEKSANDRA PRZEGALIŃSKA: Na jakim etapie znajdują się prace nad sztuczną inteligencją? To wciąż początki czy zbliżamy się do przełomu?

JEAN-GABRIEL GANASCIA: Nie ma łatwej odpowiedzi na to pytanie. Na każdym kroku widzimy niezwykły rozwój sztucznych inteligencji, a ich rosnąca moc obliczeniowa umożliwia kolejne praktyczne zastosowanie w naszym życiu. I to będzie postępować. Świat się zmienia, a wraz z nim sztuczna inteligencja. To od niej w dużej mierze uzależniony jest dalszy rozwój społeczny, z czego ludzie zwykle nie zdają sobie sprawy.

Dobrym przykładem może być internet, ale też użyteczna w telefonach funkcja rozpoznawania twarzy lub odcisku palca – to wszystko AI. Również programowanie przy użyciu inteligentnych technik jest coraz częstsze. Choć nie zawsze widać to na pierwszy rzut oka, sztuczne inteligencje zmieniają nasz świat.

Nasze społeczeństwo jest cyfrowe i uzależnione od przepływu informacji, a dane generowane przez czynniki pozaludzkie mogą być analizowane tylko przez pozaludzkie techniki. Żyjemy w społeczeństwie informacyjnym, gdzie liczy się umiejętność wyłapywania pogłosek, żeby przewidywać przyszłość. Osoby zajmujące się oprogramowaniem rozumieją ogromną rolę feedbacku w tworzeniu produktu. A jeszcze w połowie lat 90. nikt nie wiedział, jak ma wyglądać model ekonomiczny internetu. Zwłaszcza w USA, gdzie ludzie byli bardzo podekscytowani ideą sieci, ale nikt nie wiedział, jak na tym zarabiać.

Cała idea była na początku tworzona w hippisowskim duchu. Technologie i panujący w Kalifornii klimat były bardzo otwarte.

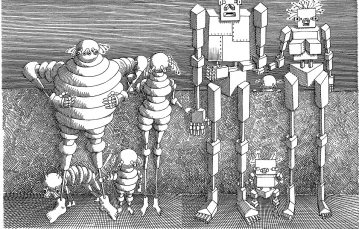

Aż zdano sobie sprawę, że da się czerpać zyski z samych danych. Na przykład zarabianie na reklamach jest trudne, bo grupa odbiorców jest szeroka, a zwrot z inwestycji niewielki. Ale jeśli skierujemy reklamy do konkretnych odbiorców, zaczyna się robić ciekawie. A to tylko jeden z przykładów zastosowania inteligentnych agentów we współczesnej gospodarce. Być może w przyszłości sztuczna inteligencja znajdzie zastosowanie w połączeniu z urządzeniami autonomicznymi. Ale wielu ludzi obawia się takich maszyn, sądząc, że – jak golemy – staną się niezależne i wykształcą wolną wolę. Jednak te obawy nie mają żadnego poparcia w faktach. Dotyczą raczej bardzo pierwotnego lęku, który pojawia się już w starożytnych opowieściach. Wie pani, że słowo „robot” powstało w Czechach?

Tak, wymyślił je pisarz Karel Čapek.

To ciekawe, że Čapek pochodził z Pragi, miejsca narodzin Golema. Ta legenda opowiada o mocy człowieka, który dorównuje Bogu, choć jego twór jest sprzeczny z naturą. Ważne jest jednak, żeby rozróżniać wyobraźnię od rzeczywistości. Świat zmienia się z powodu sztucznej inteligencji, ale nie tak, jak projektowały to najróżniejsze tradycje.

Co sądzi Pan o dyskursie osobliwości, o którym mówi Raymond Kurzweil – o zapowiedziach, że być może już za 20 lat możemy się spodziewać przełomu?

Interesuję się tematem osobliwości już od lat. Wciąż zdumiewa mnie, że tak wielu ludzi, zwłaszcza w wielkich firmach, przychyla się do tej hipotezy. Dla mnie to szaleństwo. Pytałem filozofów, dlaczego nie próbują jej negować. Śmiali się, że nie można tego traktować poważnie. Próbowałem dyskutować, byłem podejrzliwy i miałem konkretne, technologiczne argumenty, ale nic z tego nie wyszło. Czytała pani książki Raymonda Kurzweila?

„Nadchodzi osobliwość”?

Chociażby. Wszystkie jego książki są podobne. Pisze, że w naturze ewolucja przebiega wykładniczo – podobnie w technologii, bo tak działa cały świat. Prawo Moore’a stanowi koronny argument jego teorii. Można z tym dyskutować i właśnie próbuję to robić. Jak na razie wszystko wskazuje, że prawo Moore’a osiągnęło granicę i tak już pozostanie. Ale nawet gdyby okazało się inaczej – niczego to nie zmienia. Olbrzymia szybkość komputera nie wiąże się z powstaniem świadomości ani możliwością wgrania do niego własnej. W ogóle z filozoficznego punktu widzenia dziwnym jest mówienie o przenoszeniu świadomości do maszyny, bo to oznacza, że jesteś materialistą, a twój umysł może zostać kompletnie oddzielony od ciała.

Jakbyśmy nie mieli fenomenologii i nigdy nie odkryli inteligencji ciała. Jakby te dwie rzeczy mogły być zupełnie rozdzielne.

Dokładnie. Pojawia się też argument, że maszyny same się uczą, a wiedza zdobywana w ten sposób jest o wiele wydajniejsza niż nasza. Owszem, maszyny będą mądrzejsze od nas. Nawet bez świadomości będą podejmować lepsze decyzje – dlatego przekażemy im władzę i odpowiedzialność.

Thomas Kuhn stworzył pojęcie „zmiany paradygmatu”. W historii odkryć oznaczało to świadomość wydarzającej się rewolucji, wywracającej dotychczasowe koncepcje i pojęcia. Zdaję sobie sprawę z mocy technik maszynowych, ale znam również ich ograniczenia. Maszyny z pewnością same nie doprowadzą do zmiany paradygmatu. Ale współpraca w wielu dziedzinach jest możliwa – choćby w biologii czy fizyce sztuczne czynniki mogą odegrać niezwykle istotną rolę. W naukach humanistycznych czy kulturoznawstwie również. Sam współpracuję z literaturoznawcami nad budową nowego narzędzia interpretacyjnego do rozumienia tradycyjnej literatury.

A co Pan sądzi o uczeniu głębokim? Czy zanim zaimplementujemy te technologie, powinniśmy się zastanowić, jak uczynić je bardziej przejrzystymi, aby uniknąć zagrożenia?

Uczenie głębokie to bardzo potężna technika i brakuje nam semantyki na jej opisanie. Zwyczajnie nie wiemy jeszcze, jak dokładnie działa. Nie istnieje teoria uczenia głębokiego, co z naukowego punktu widzenia jest problematyczne. To zabawne, bo historia sieci neuronowych jest bardzo długa. Pierwsze ich modele zbudowano już w 1943 r. To było niezwykle trudne przedsięwzięcie. Okazało się, że przy sieci trójwarstwowej można uzyskać dowolną, w pełni sprawną konfigurację – model był uniwersalny. Ale konfiguracja takiej sieci jest bardzo trudna.

Ostatecznie uczenie głębokie okazało się bardzo praktyczne, więc fakt, że nie mamy żadnej teorii na temat jego działania, jest tym bardziej frapujący. Wyniki statystyczne pokazują, że techniki głębokiego uczenia radzą sobie z ogromnymi ilościami przykładów, i to z bardzo dobrymi rezultatami, co liczy się zwłaszcza przy nauce rozpoznawania obrazów czy głosu. To niezmiernie wydajna technologia, ale nie rozwiązuje wszystkich problemów i nie zaspokaja każdej potrzeby.

Czyli to nie czarodziejska różdżka.

Nie, czasem potrzebujemy uczenia nienadzorowanego do wygenerowania nowych koncepcji.

Poza tym trzeba wiedzieć dokładnie, jak konkretny przykład ma się do danych wyjściowych programu. Czasem nie jest to problem, ale w przypadku rozpoznawania twarzy już tak. Maszyna rozpozna Johna albo Aleksandra i nie możemy jej powiedzieć, że nie ma racji tylko dlatego, że nie wiemy, jak ona działa. Program może nam pomóc i jeśli statystycznie patrząc dobrze sobie radzi – to świetnie, jeśli nie, to pojawia się kłopot.

Natomiast w innych zastosowaniach konieczne jest szersze uzasadnienie wyniku. Weźmy przykład współpracy z firmą bankową, która chciała wykorzystać technologię sztucznych agentów do uproszczenia procesu udzielania kredytów. Maszyna służy tylko do wyliczania punktacji, na podstawie której stwierdza się zdolność kredytową. „Uzyskał pan 0,6, a potrzebne jest 0,7” – to się nie sprawdzi, bo klient będzie chciał znać konkretne powody, dla których bank nie chce mu dać pożyczki.

To przypomina chiński projekt punktowej oceny obywateli. Jest przerażający, bo nie wiadomo dokładnie, za co przyznawane są punkty, a kryteriów może być wiele. Podejrzewam, że system opiera się na głębokim uczeniu.

Dokładnie! I będzie to kwestia problematyczna dla przyszłości naszego społeczeństwa opartego na idei demokracji. Bez jawnych kryteriów to istny koszmar. Wyobraźmy sobie przyszłość, w której Facebook zacznie zamykać konta użytkownikom bez podawania przyczyny!

To straszna wizja!

Okropna! Ważne więc, by w przyszłości zadbać o uzasadnienia i umożliwić ludziom zgłoszenie sprzeciwu. Jeszcze przez wiele lat będziemy musieli korzystać z technik uczenia, które będą musiały uzasadniać rezultaty. Tym zajmujemy się na polu inteligentnych agentów, na tym etapie jesteśmy.

Ma Pan na myśli koncepcję tzw. wyjaśnialnej sztucznej inteligencji (XAI)?

Tak. Moim zdaniem w przyszłości to będzie niezwykle ważny aspekt. Nie jest konieczny do wszystkich zastosowań sztucznej inteligencji, ale w przypadku niektórych jest kluczowy.

Wspomnieliśmy już wiele zagrożeń i negatywnych scenariuszy. Chiński projekt oceny obywateli nie jest najlepszym przykładem społecznej przydatności AI, ale na zakończenie chciałam zapytać o największe zagrożenia oraz nadzieje związane ze sztuczną inteligencją.

Największe zagrożenie wynika z tego, że wraz z AI zmienia się społeczeństwo. Ewoluuje też pojęcie polityki. I to nie jest związane wyłącznie ze sztucznymi agentami. Działanie demokracji jest przedłużeniem państwa i terytorium. Dziś terytoria są penetrowane technologiami cyfrowymi, co stanowi znaczne utrudnienie. W rezultacie mogą pojawić się aktorzy niezależni od państwa. Może to mieć pozytywne skutki, ale może również być niebezpieczne, bo osłabia państwo, a aktorzy, którzy nie zostali wybrani przez społeczeństwo, są całkowicie niezależni i mogą robić, co tylko zechcą.

Weźmy Amazon – to coś strasznego! Mają dużo władzy i jeżeli chcą na przykład wykupić jakąś firmę, mogą wywierać odpowiednie naciski, bo mają odpowiednie środki. To chyba dobra ilustracja prawdziwego zagrożenia w przyszłości. Sztucznych agentów można zastosować do najróżniejszych celów, czasem koszmarnych. Zobaczymy, jak Chinom pójdzie z technologią rozpoznawania wizerunku. Ale te negatywne scenariusze wcale nie są już ustalone.

Wszystko zależy od nas. Swój optymizm uzależniam od tego, czy będziemy w stanie zrozumieć zarówno pozytywne, jak i negatywne aspekty nowych technologii. Jedne i drugie wynikają z samej natury informacji. Jeśli ludzie się z czymś nie zgadzają, wszystko się zmienia. I taka zmiana może nastąpić bardzo szybko. Myślę, że to właśnie nas czeka. Jeśli ludzie będą świadomi złych praktyk, firmy będą zmuszone do ich porzucenia.

Bywa też tak, jak w przypadku Facebooka – potęga pieniędzy i danych jest ogromna, co uodparnia na nasze niezadowolenie. Weźmy choćby rozwój nowej marki, czyli Instagrama – medium pozornie wolnego od grzechów ojca-giganta.

Zgadzam się. Dlatego od lat poszukuję narzędzi wywodzących się z filozofii politycznej, które mogą pomóc nam zrozumieć nową rzeczywistość. Dobrym przykładem jest pojęcie nadzoru. Może się pani z nim spotkała?

Uważam, że jest pożyteczne.

Zwłaszcza w nauce. Jestem przekonany, że z pomocą sztucznych agentów możliwe będą nowe odkrycia. Ale to nie znaczy, że nastąpią automatycznie. Potrzebujemy partnerstwa człowieka i maszyny. Dawno temu rozmawiałem we Francji z lekarzem, wiekowym i poważanym. Powiedział mi, że owszem, to by było bardzo interesujące, bo wszyscy naukowcy korzystają z tego samego dogmatu, rodzaju dominującej koncepcji. A maszyny byłyby od tego wolne i mogłyby uczyć się bez odgórnie przyjętych założeń czy uprzedzeń. Byłem wtedy bardzo młody i próbowałem mu wyjaśnić, że to bardziej złożone zagadnienie. Maszyny też mają dogmaty, bo kiedy podaje się maszynie przykład, otrzymuje ona konkretne przedstawienie.

Czyli człowiek przenosi własne dogmaty na maszynę? W końcu wszystkie dane to ludzkie dane.

Nawet w obecności dogmatu maszyna może pomóc w generowaniu nowych teorii. W relacji człowieka z maszyną rolą tego pierwszego jest nie tyle wymyślanie hipotez, co nowych pól ich tworzenia, które maszyny mogą potem zgłębiać. To ogromny przełom, który zawdzięczamy sztucznym agentom. W medycynie, fizyce i innych naukach wydarza się właśnie rewolucja, ale wiele osób, zwłaszcza w dziedzinie big data, zachowuje się naiwnie. Myślą, że wystarczą dane – bez modelu, bez teorii – żeby wygenerować rezultat wyjściowy. Teoria jest niezbędna właśnie dlatego, że nawet bez niej potrafimy osiągnąć tak wiele. ©

JEAN-GABRIEL GANASCIA jest profesorem z Sorbony, kieruje jednym z zespołów w LIP6 (centrum badawczym, zajmującym się nauką o danych i sztucznej inteligencji).

Na festiwalu Przemiany wygłosi wykład „Etyka autonomicznych agentów” (15 września, godz. 18.00).